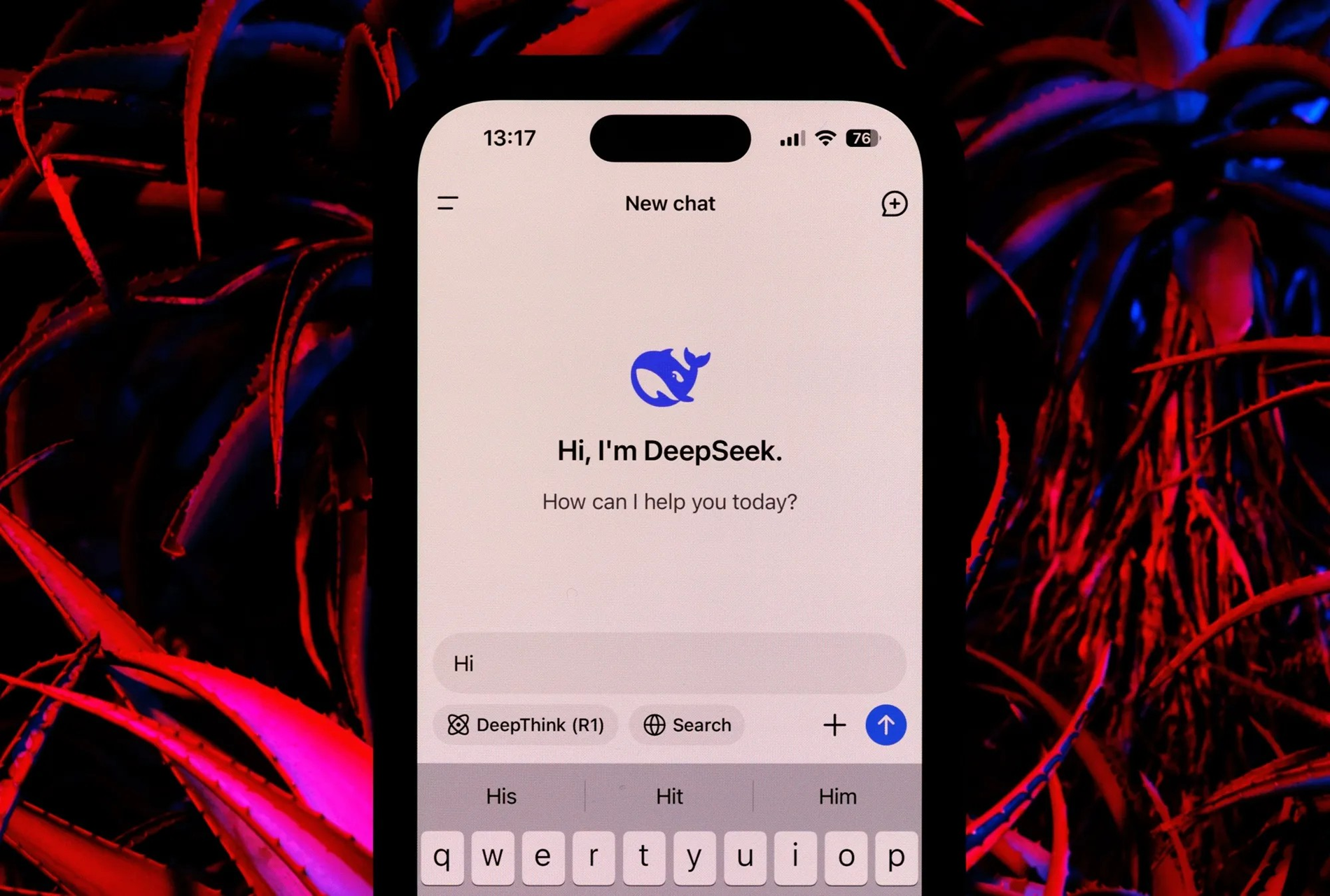

DeepSeek, la startup china más popular de los últimos días, ha generado dudas sobre su afirmación de crear una IA comparable a la de OpenAI con solo 5 millones de dólares.

DeepSeek tuvo una amplia cobertura mediática y en las redes sociales a principios del Año de la Serpiente, provocando temblores importantes en los mercados bursátiles mundiales.

Sin embargo, un informe reciente de la consultora financiera Bernstein advierte que, a pesar de los impresionantes logros, la afirmación de crear un sistema de IA comparable al de OpenAI por solo 5 millones de dólares es inexacta.

Según Bernstein, la declaración de DeepSeek es engañosa y no refleja el panorama general.

“Creemos que DeepSeek no ‘creó OpenAI con 5 millones de dólares’; los modelos son fantásticos, pero no creemos que sean milagros; y el pánico del fin de semana parece haber sido exagerado”, afirma el informe.

DeepSeek desarrolla dos modelos principales de IA: DeepSeek-V3 y DeepSeek R1. El modelo de lenguaje V3 a gran escala aprovecha la arquitectura MOE, combinando modelos más pequeños para lograr un alto rendimiento con un menor consumo de recursos informáticos que los modelos tradicionales.

Por otro lado, el modelo V3 tiene 671 mil millones de parámetros, con 37 mil millones de parámetros activos en un momento dado, incorporando innovaciones como MHLA para reducir el uso de memoria y utilizando FP8 para una mayor eficiencia.

El entrenamiento del modelo V3 requirió un clúster de 2048 GPU Nvidia H800 durante dos meses, lo que equivale a 5,5 millones de horas de GPU. Si bien algunas estimaciones sitúan el coste del entrenamiento en aproximadamente 5 millones de dólares, el informe de Bernstein enfatiza que esta cifra solo cubre los recursos informáticos y no considera los costos significativos relacionados con la investigación, las pruebas y otros gastos de desarrollo.

El modelo DeepSeek R1 se basa en la base de V3 al utilizar aprendizaje de refuerzo (RL) y otras técnicas para garantizar la capacidad de inferencia.

El modelo R1 puede competir con los modelos OpenAI en tareas de razonamiento. Sin embargo, Bernstein señala que desarrollar R1 requiere recursos considerables, aunque estos no se detallan en el informe de DeepSeek.

Al comentar sobre DeepSeek, Bernstein elogió los modelos y los calificó de impresionantes. Por ejemplo, el modelo V3 funciona igual o mejor que otros modelos de lenguajes importantes en lingüística, programación y matemáticas, a la vez que requiere menos recursos.

El proceso de preentrenamiento V3 requirió solo 2,7 millones de horas de trabajo de GPU, o el 9% de los recursos computacionales de algunos otros modelos de primer nivel.

Bernstein concluyó que, si bien los avances de DeepSeek son notables, hay que tener cuidado con las afirmaciones exageradas. La idea de crear un competidor de OpenAI con solo 5 millones de dólares parece desacertada.

(Según el Times of India)

[anuncio_2]

Fuente: https://vietnamnet.vn/deepseek-khong-the-lam-ai-tuong-duong-openai-voi-5-trieu-usd-2367340.html

![[Foto] El Secretario General To Lam visita el espacio expositivo que muestra libros, exposiciones fotográficas y logros de la transformación digital en el periodismo.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766110879215_1766110240024-jpg.webp&w=3840&q=75)

![[Foto] Encantador jardín de rosas antiguo en la ladera de la montaña en Nghe An](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766109900916_vuon-hong-chin-do-thu-hut-du-khach-toi-check-in-o-ha-noi-3-20162778-1671624890024-1671624890104198100259.jpeg&w=3840&q=75)

Kommentar (0)