اداره امنیت اطلاعات اخیراً در مورد تکرار مداوم کلاهبرداری ویدیویی و تصویری با فناوری پیشرفته هشدار داده است.

بر این اساس، وضعیت مجرمان سایبری که از تصاویر و ویدیوهای عمومی مردم برای ویرایش، بریدن و تهدید به اخاذی با ویدیوهای جعلی سوءاستفاده میکنند، توسط مقامات به تعداد زیادی از مردم هشدار داده شده است.

با استفاده از فناوری دیپفیک که امکان بازتولید صدا و تصویر یک فرد را با دقت بالا فراهم میکند، مجرمان میتوانند در جلسات آنلاین خود را جای رهبران جا بزنند یا ویدیوها و تماسهایی برای ارتکاب کلاهبرداری مالی ایجاد کنند.

علاوه بر این، این کلاهبرداریها اغلب از عوامل روانشناختی مانند فوریت، ترس یا قدرت سوءاستفاده میکنند و باعث میشوند قربانیان بدون بررسی دقیق صحت، عجولانه عمل کنند.

دیپفیکها محدود به کلاهبرداریهای سرمایهگذاری مالی نیستند. مثال دیگر، کلاهبرداریهای عاشقانه است که در آن از دیپفیکها برای ایجاد شخصیتهای خیالی استفاده میشود که از طریق تماسهای ویدیویی با قربانیان تعامل میکنند. پس از جلب اعتماد قربانی، کلاهبردار درخواست انتقال پول برای حل مشکلات اضطراری، هزینههای سفر یا وام میکند.

با توجه به شرایط فوق، اداره امنیت اطلاعات توصیه میکند که مردم نسبت به توصیههای سرمایهگذاری افراد مشهور در شبکههای اجتماعی محتاط باشند؛ مراقب پیامها، ایمیلها یا تماسهای ناشناس باشند؛ و به دقت حالات چهره غیرطبیعی را در ویدیوها مشاهده کنند.

همچنین افراد باید انتشار محتوای مربوط به اطلاعات شخصی در شبکههای اجتماعی را محدود کنند تا از سرقت اطلاعاتی مانند تصاویر، ویدیوها یا صداها توسط افراد شرور جلوگیری شود؛ در عین حال، برای محافظت از اطلاعات شخصی، حسابهای کاربری را در حالت خصوصی (private mode) قرار دهند.

نگو مین هیو، متخصص امنیت سایبری و از بنیانگذاران پروژه پیشگیری از کلاهبرداری سایبری ویتنام (Chongluadao.vn)، در گفتگو با خبرنگاران روزنامه دای دوان کت گفت که استفاده از فناوری دیپفیک در هوش مصنوعی برای جعل تماسهای ویدیویی با اهداف کلاهبرداری هنوز پیچیده است. افراد از این فناوری برای افزایش اعتبار «طعمه» خود سوءاستفاده میکنند.

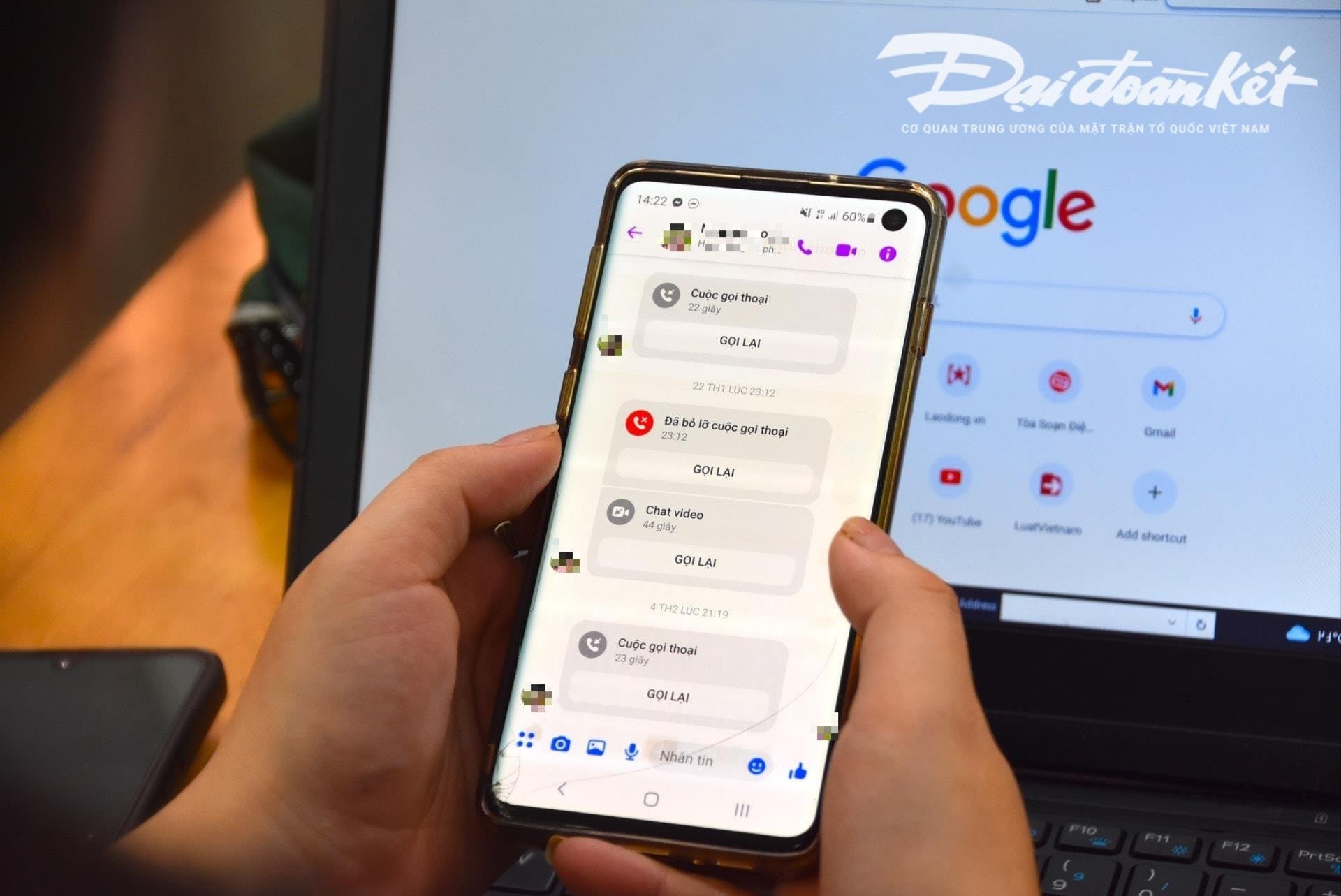

به طور خاص، افراد به طور فعال از طریق تصاویر و ویدیوهای "سرقت شده" قبلی با قربانیان تماس ویدیویی برقرار میکنند و با دستکاری تکنیک، صدا را تحریف میکنند یا مشکلات تصویر جعلی ایجاد میکنند تا اعتماد قربانی را جلب کنند.

معمولاً این تماسها بسیار کوتاه هستند و فقط چند ثانیه طول میکشند، سپس به بهانههایی مانند ناپایداری شبکه، حضور در خیابان و غیره از قربانی میخواهند که درخواستهای کلاهبردار را انجام دهد.

کارشناسان هشدار میدهند که استفاده از هوش مصنوعی برای کلاهبرداری سایبری احتمالاً در آینده نزدیک به طور قابل توجهی افزایش خواهد یافت. بنابراین، مردم باید به طور پیشگیرانه هوشیاری خود را افزایش دهند، به خصوص هنگام دریافت پیامها، تماسهای ویدیویی و لینکهای عجیب.

طبق تحلیل این متخصص، الگوریتم هوش مصنوعی دیپفیک فعلی در طول تماسهای آنی، در صورت چرخش تماسگیرنده به چپ، چرخش به راست یا ایستادن، قادر به مدیریت آن نخواهد بود...

یکی از نقاط ضعف خاصی که افراد هنگام دریافت این تماسها باید به آن توجه کنند، دندانها است. بر این اساس، الگوریتمهای هوش مصنوعی فعلی نمیتوانند دندانهای فرد جعل هویت شده را بازتولید کنند.

در صورت استفاده از دیپفیک، تصویر فردی که دهان خود را باز میکند ممکن است هیچ دندانی نداشته باشد، برخی افراد ممکن است ۳ یا حتی ۴ فک داشته باشند. بنابراین، ویژگیهای دندانها قابل تشخیصترین عنصر یک تماس جعلی با استفاده از دیپفیک هستند.

«کند کردن» و عدم پیگیری فوری درخواست، پیشنیاز جلوگیری از افتادن در دام کلاهبرداری است. هنگام دریافت هرگونه پیام یا تماس از طریق شبکههای اجتماعی، افراد باید مستقیماً با بستگان خود تماس بگیرند تا مطمئن شوند دقیقاً چه کسی با آنها تماس گرفته است، حداقل زمان تماس بیش از 30 ثانیه باشد یا حضوری ملاقات کنند.

در صورت سوءظن به جعل هویت بستگان در شبکههای اجتماعی برای کلاهبرداری یا تصاحب اموال، لازم است فوراً به نزدیکترین اداره پلیس گزارش دهید تا به موقع پشتیبانی و رسیدگی شود.

منبع: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[عکس] کت با - بهشت جزیره سبز](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[VIMC 40 روز سرعت برقآسا] بندر دا نانگ: وحدت - سرعت برقآسا - دستیابی به موفقیت تا خط پایان](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764833540882_cdn_4-12-25.jpeg)

نظر (0)