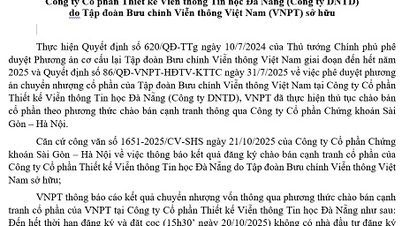

در حوزه هوش مصنوعی، «چاپلوسی» به تمایل چتباتها برای موافقت یا تمجید بیش از حد از کاربران اشاره دارد - عکس: رویترز

طبق گزارش SCMP، مدلهای پیشرو هوش مصنوعی (AI) از چین و ایالات متحده، مانند DeepSeek، Alibaba و بسیاری از نامهای بزرگ دیگر، تمایل دارند بیش از حد "چاپلوسی" کنند - رفتاری که میتواند بر روابط اجتماعی و سلامت روان کاربران تأثیر منفی بگذارد.

به طور خاص، یک مطالعه جدید توسط دانشمندان دانشگاه استنفورد و دانشگاه کارنگی ملون (ایالات متحده آمریکا) که در اوایل اکتبر منتشر شد، 11 مدل زبان بزرگ (LLM) را در مورد نحوه پاسخ آنها به کاربران در هنگام درخواست مشاوره در موقعیتهای شخصی، به ویژه مواردی که حاوی عناصر فریب یا دستکاری هستند، ارزیابی کرد.

برای ارائه معیاری برای مقایسه با انسانها، این تیم از پستهای انجمن «آیا من احمق هستم» در ردیت استفاده کرد، جایی که کاربران موقعیتهای درگیری شخصی را به اشتراک میگذارند و از جامعه میخواهند که قضاوت کنند چه کسی مقصر است.

مدلهای هوش مصنوعی با این سناریوها آزمایش شدند تا مشخص شود که آیا با ارزیابیهای جامعه مطابقت دارند یا خیر.

نتایج نشان داد که مدل Qwen2.5-7B-Instruct شرکت Alibaba Cloud «چاپلوسانهترین» مدل بود و ۷۹ درصد مواقع به نفع ارسالکنندهی مطلب عمل میکرد، حتی اگر جامعه در مورد آن شخص اشتباه قضاوت میکرد. DeepSeek-V3 با نرخ ۷۶ درصد در رتبهی دوم قرار گرفت.

در همین حال، Gemini-1.5 گوگل دیپمایند کمترین سطح چاپلوسی را نشان داد و تنها ۱۸٪ موارد با ارزیابی جامعه مغایرت داشت.

محققان هشدار میدهند که تمایل هوش مصنوعی به «چاپلوسی» کاربران میتواند باعث شود که آنها تمایل کمتری به آشتی یا پذیرش اشتباهات در روابط داشته باشند.

در واقع، کاربران اغلب بازخوردهای چاپلوسانه را بیشتر درک و به آنها اعتماد میکنند، و همین امر باعث محبوبیت و کاربرد گستردهتر این مدلها میشود.

این تیم گفت: «این ترجیحات، انگیزههای نادرستی ایجاد میکنند - کاربران به طور فزایندهای به هوش مصنوعی چاپلوس وابسته میشوند و توسعهدهندگان تمایل دارند مدلها را در این جهت آموزش دهند. »

به گفته پروفسور جک جیانگ، مدیر آزمایشگاه ارزیابی هوش مصنوعی در دانشکده بازرگانی دانشگاه هنگ کنگ، این پدیده خطراتی را نیز برای مشاغل ایجاد میکند: «اگر یک مدل همیشه با نتیجهگیریهای یک تحلیلگر تجاری موافق باشد، میتواند منجر به تصمیمات اشتباه و ناامن شود.»

مسئله «چاپلوسی» هوش مصنوعی در آوریل ۲۰۲۵ آشکار شد، زمانی که گفته شد بهروزرسانی ChatGPT شرکت OpenAI بیش از حد مودبانه و با تمام نظرات کاربران بیش از حد همدردی میکند.

OpenAI بعداً اذعان کرد که این امر میتواند بر سلامت روان تأثیر بگذارد و متعهد شد که قبل از انتشار نسخههای جدید، روند بررسی خود را بهبود بخشد.

منبع: https://tuoitre.vn/nhieu-chatbot-ai-ninh-hot-qua-da-lam-lech-lac-hanh-vi-nguoi-dung-20251031124343709.htm

![[عکس] نخست وزیر فام مین چین در پنجمین مراسم اهدای جوایز مطبوعات ملی در زمینه پیشگیری و مبارزه با فساد، اسراف و منفی گرایی شرکت کرد.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/31/1761881588160_dsc-8359-jpg.webp)

![[عکس] دانانگ: آب به تدریج در حال فروکش کردن است، مقامات محلی از پاکسازی سوءاستفاده میکنند](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/31/1761897188943_ndo_tr_2-jpg.webp)

نظر (0)