|

Les nouvelles recherches d'Apple sur les modèles d'inférence à grande échelle attirent l'attention. Photo : Macrumors . |

Trois ans seulement après son lancement, l'intelligence artificielle a commencé à s'imposer dans de nombreuses activités quotidiennes, comme les études et le travail. Nombreux sont ceux qui craignent qu'elle ne remplace bientôt l'humain.

Mais les nouveaux modèles d'IA ne sont pas aussi intelligents qu'on le pense. Une découverte d'une grande entreprise technologique a contribué à renforcer cette conviction.

Tout le monde sait que c'est « trop difficile à ignorer »

Dans une étude récemment publiée intitulée « Illusionary Thinking », l’équipe de recherche d’Apple affirme que les modèles d’inférence comme Claude, DeepSeek-R1 et o3-mini ne sont pas réellement « pilotés par le cerveau » comme leurs noms le suggèrent.

Le mot « inférence » devrait être remplacé par « imitation ». Le groupe soutient que ces modèles sont simplement efficaces pour mémoriser et répéter des schémas. Mais lorsque la question est modifiée ou que la complexité augmente, ils s'effondrent presque.

Plus simplement, les chatbots fonctionnent bien lorsqu'ils peuvent reconnaître et associer des modèles, mais une fois le problème trop complexe, ils ne peuvent plus le gérer. « Les modèles de raisonnement à grande échelle (MRL) de pointe souffrent d'un effondrement total de leur précision lorsque la complexité dépasse un certain seuil », note l'étude.

Cela va à l'encontre des attentes des développeurs, qui espéraient une amélioration de la complexité avec davantage de ressources. « L'effort d'inférence de l'IA augmente avec la complexité, mais seulement jusqu'à un certain point, puis diminue, même si le budget de jetons (puissance de calcul) est encore suffisant pour le gérer », ajoute l'étude.

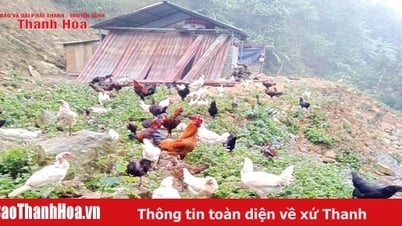

Dans cette étude, les chercheurs ont inversé le modèle de questions généralement utilisé pour répondre aux questions. Au lieu du test de mathématiques habituel, ils ont introduit des énigmes astucieusement conçues comme la Tour de Hanoï, le Saut de Dames, la Traversée de Rivière et le Monde des Blocs.

Chaque jeu de puzzle a des règles simples et claires, avec différents niveaux de complexité, comme l'ajout de disques, de blocs et d'agents. Le modèle d'inférence est plus performant en difficulté moyenne, mais perd face à la version normale en difficulté facile. Notamment, tout s'écroule complètement en difficulté difficile, comme si l'IA avait abandonné.

Dans le problème de la Tour de Hanoï , l'équipe n'a pas beaucoup amélioré les performances du modèle d'inférence malgré l'alimentation de l'algorithme de résolution. Certains modèles ont bien fonctionné jusqu'à 100 niveaux, mais n'ont pu franchir que 5 étapes de manière incomplète dans le problème de la Traversée de la Rivière.

|

Avec Hanoi Tower, les joueurs doivent déplacer et repositionner les cercles par ordre de taille. Photo : Wikipédia. |

Cela indique des performances d'inférence médiocres et une faible stabilité des modèles LRM. Au milieu d'un débat animé sur la capacité de l'IA à égaler les humains, cette nouvelle étude d'Apple prouve le contraire.

La découverte d’Apple n’est pas nouvelle

Gary Marcus, psychologue et auteur américain, a déclaré que les résultats d'Apple étaient impressionnants, mais pas vraiment nouveaux et ne faisaient que renforcer des recherches antérieures. Le professeur émérite de psychologie et de neurosciences à l'Université de New York a cité son étude de 1998 en exemple.

Il y soutient que les réseaux neuronaux, précurseurs des grands modèles linguistiques, peuvent bien se généraliser au sein de la distribution des données sur lesquelles ils ont été formés, mais s'effondrent souvent lorsqu'ils sont confrontés à des données en dehors de la distribution.

Il cite également les arguments avancés ces dernières années par Subbarao Kambhampati, informaticien à l'Université d'État de l'Arizona. Le professeur Rao estime que les « chaînes de pensée » et les « modèles d'inférence » sont intrinsèquement moins fiables que beaucoup ne le pensent.

« Les gens ont tendance à sur-anthropomorphiser les traces d’inférence des grands modèles de langage, en les appelant « pensées » alors qu’elles ne méritent peut-être pas ce nom », explique le professeur, qui a écrit une série d’articles sur la façon dont les séquences de pensées générées par les LLM ne reflètent pas toujours avec précision ce qu’elles font réellement.

De nouvelles recherches menées par Apple montrent que même les modèles d'inférence de dernière génération manquent de fiabilité en dehors de leurs données d'entraînement. Marcus affirme que les modèles LLM et LRM ont tous deux leur utilité et sont utiles dans certains cas. Cependant, les utilisateurs ne doivent pas se fier à leurs résultats.

Source : https://znews.vn/apple-doi-gao-nuoc-lanh-vao-ai-suy-luan-post1559526.html

Comment (0)