Si vous avez déjà consulté les réseaux sociaux, il y a de fortes chances que vous soyez tombé sur des images ou des vidéos créées par l'IA. Nombreux sont ceux qui se sont fait avoir, comme avec la vidéo virale de lapins sautant sur un trampoline. Mais Sora, une application sœur de ChatGPT développée par OpenAI, pousse l'IA vidéo encore plus loin, rendant la détection des contenus truqués de plus en plus urgente.

Les outils d'intelligence artificielle pour la vidéo rendent l'identification des vidéos authentiques plus difficile que jamais. (Source : CNET)

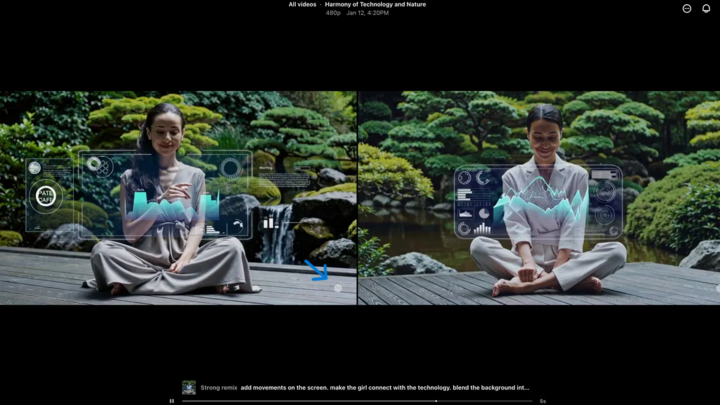

Lancée en 2024 et récemment mise à jour avec Sora 2, cette application possède une interface similaire à TikTok, où toutes les vidéos sont générées par IA. La fonctionnalité « caméo » permet d'intégrer de vraies personnes dans des séquences simulées, créant ainsi des vidéos d'un réalisme saisissant.

De nombreux experts craignent donc que Sora ne contribue à la propagation des deepfakes, en déformant l'information et en brouillant la frontière entre réalité et fiction. Les célébrités sont particulièrement vulnérables, ce qui a conduit des organisations comme la SAG-AFTRA à demander à OpenAI de renforcer la protection des données.

Identifier les contenus générés par l'IA représente un défi majeur pour les entreprises technologiques, les plateformes de médias sociaux et les utilisateurs. Il existe cependant des méthodes pour reconnaître les vidéos créées avec Sora.

Trouver le filigrane Sora

Le filigrane Sora (indiqué par la flèche bleue) est un marqueur qui identifie l'outil utilisé pour créer la vidéo. (Source : CNET)

Chaque vidéo créée sur l'application Sora pour iOS comporte un filigrane lors de son téléchargement : le logo blanc de Sora (icône de nuage) se déplace sur les bords de la vidéo, à l'instar du filigrane de TikTok.

Il s'agit d'une méthode visuelle pour identifier les contenus générés par l'IA. Par exemple, le modèle Gemini de Google, surnommé « nano-banane », ajoute automatiquement un filigrane aux images. Cependant, les filigranes ne sont pas toujours fiables. S'il est statique, il peut être facilement supprimé. Même les filigranes dynamiques, comme celui de Sora, peuvent être effacés à l'aide d'applications spécialisées.

Interrogé à ce sujet, Sam Altman, PDG d'OpenAI, a affirmé que la société devait s'adapter au fait que n'importe qui peut créer de fausses vidéos. Avant Sora, aucun outil n'avait jamais été aussi populaire, accessible et ne nécessitait de compétences particulières pour créer de telles vidéos. Son point de vue souligne la nécessité de recourir à des méthodes de vérification alternatives.

Vérifier les métadonnées

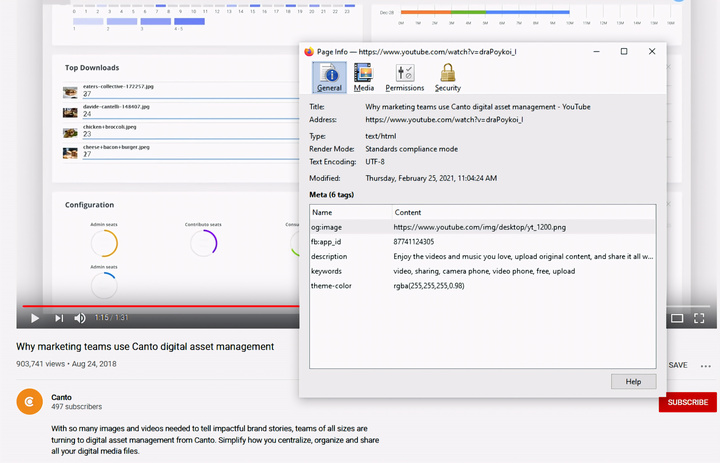

La vérification des métadonnées est une étape cruciale pour déterminer si une vidéo a été créée par une IA, comme Sora. (Source : Canto)

Vous pourriez penser que la vérification des métadonnées est trop compliquée, mais c'est en réalité assez simple et très efficace.

Les métadonnées sont un ensemble d'informations automatiquement associées à un contenu lors de sa création, telles que le type de caméra, le lieu, l'heure d'enregistrement et le nom du fichier. Qu'il soit généré par un humain ou par une IA, le contenu possède des métadonnées. Dans le cas du contenu généré par une IA, les métadonnées incluent souvent des informations d'attribution de la source.

OpenAI est membre de la Coalition pour l'origine et l'authenticité du contenu (C2PA). Les vidéos Sora contiennent donc des métadonnées C2PA. Vous pouvez le vérifier à l'aide de l'outil de vérification de l'initiative d'authenticité du contenu :

Comment vérifier les métadonnées :

- Visitez verify.contentauthenticity.org

- Téléversez le fichier à vérifier.

- Appuyez sur « Ouvrir »

- Consultez les informations dans le tableau de droite.

Si la vidéo a été créée par une IA, cela sera clairement indiqué dans le résumé. En consultant les vidéos Sora, vous verrez la mention « Publié par OpenAI » ainsi que des informations confirmant que la vidéo a été créée à l'aide d'une IA. Toutes les vidéos Sora doivent comporter cette information afin de vérifier leur origine.

Source : https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[En direct] Gala des prix d'action communautaire 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Photo] Le Premier ministre Pham Minh Chinh reçoit le ministre laotien de l'Éducation et des Sports, Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Image] L'esprit combatif tenace du football féminin vietnamien](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F17%2F1765990260956_ndo_br_4224760955870434771-copy-jpg.webp&w=3840&q=75)

![[Image] Images divulguées avant le gala des Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Photo] Le Premier ministre Pham Minh Chinh reçoit le gouverneur de la province de Tochigi (Japon)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[En direct] Cérémonie de clôture et remise des prix du concours de création vidéo/clip « Le tourisme impressionnant au Vietnam » 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Comment (0)