Comment fonctionnent les images truquées par IA ?

L'IA est omniprésente de nos jours, même en temps de guerre. Les applications d'intelligence artificielle ont tellement progressé cette année que presque n'importe qui peut utiliser des générateurs d'IA pour créer des images d'apparence réaliste, du moins au premier abord.

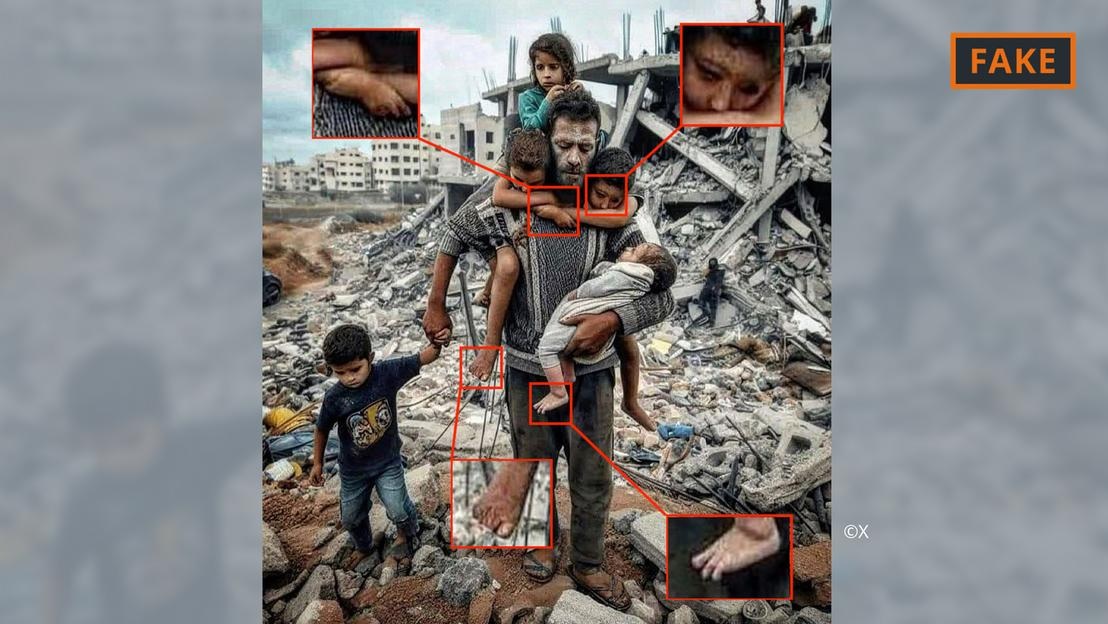

Une fausse photo de la guerre à Gaza générée par une IA.

Il suffit aux utilisateurs de fournir à des outils comme Midjourney ou Dall-E quelques indications, notamment des spécifications et des informations, pour que ces outils d'IA convertissent ensuite le texte, voire la voix, en images.

Ce processus de génération d'images repose sur l'apprentissage automatique. Par exemple, si un créateur demande l'affichage d'une image d'un homme de 70 ans à vélo, le système effectuera une recherche dans sa base de données afin d'associer les termes à des images.

À partir des informations disponibles, l'algorithme d'IA générera une image du cycliste âgé. Grâce à l'enrichissement constant des données et aux mises à jour techniques, ces outils se sont considérablement améliorés et continuent d'apprendre.

Tout ceci est appliqué aux images liées au conflit au Moyen-Orient. Dans un conflit où les émotions sont à vif, la désinformation, notamment diffusée par des images générées par l'IA, a un impact considérable, explique Hany Farid, expert en IA.

Farid, professeur d'analyse numérique à l'Université de Californie à Berkeley, a déclaré que les batailles acharnées constituent le terreau idéal pour la création et la diffusion de faux contenus, ainsi que pour l'exacerbation des émotions.

Types d'images IA de la guerre israélo-hamas

Les images et les vidéos créées à l'aide de l'intelligence artificielle ont alimenté la désinformation relative à la guerre en Ukraine, et cela continue de se produire dans le conflit israélo-palestinien.

D'après les experts, les images générées par IA et circulant sur les réseaux sociaux au sujet de la guerre se répartissent généralement en deux catégories. La première met l'accent sur les souffrances humaines et suscite la compassion. La seconde, créée par une IA truquée, exagère les événements, incitant ainsi au conflit et à l'escalade de la violence.

Photo truquée générée par IA montrant un père et son enfant dans les décombres à Gaza.

Par exemple, la première catégorie comprend la photo ci-dessus montrant un père et ses cinq enfants devant un tas de gravats. Elle a été partagée de nombreuses fois sur X (anciennement Twitter) et Instagram, et vue des centaines de milliers de fois.

Cette image a été signalée par la communauté, au moins sur X, comme étant fausse. Elle est reconnaissable à diverses erreurs et incohérences typiques des images générées par IA (voir image ci-dessus).

Des anomalies similaires sont également visibles sur la fausse image d'IA devenue virale sur X ci-dessous, qui prétend montrer une famille palestinienne mangeant ensemble sur les ruines.

Photo truquée d'un parti palestinien générée par IA.

Parallèlement, une autre image montrant des soldats agitant des drapeaux israéliens alors qu'ils traversent une colonie remplie de maisons bombardées appartient à la deuxième catégorie, conçue pour attiser la haine et la violence.

D'où proviennent ces images générées par l'IA ?

La plupart des images de conflits générées par l'IA sont publiées sur les réseaux sociaux, mais elles sont également disponibles sur un certain nombre d'autres plateformes et organisations, et même sur certains sites d'information.

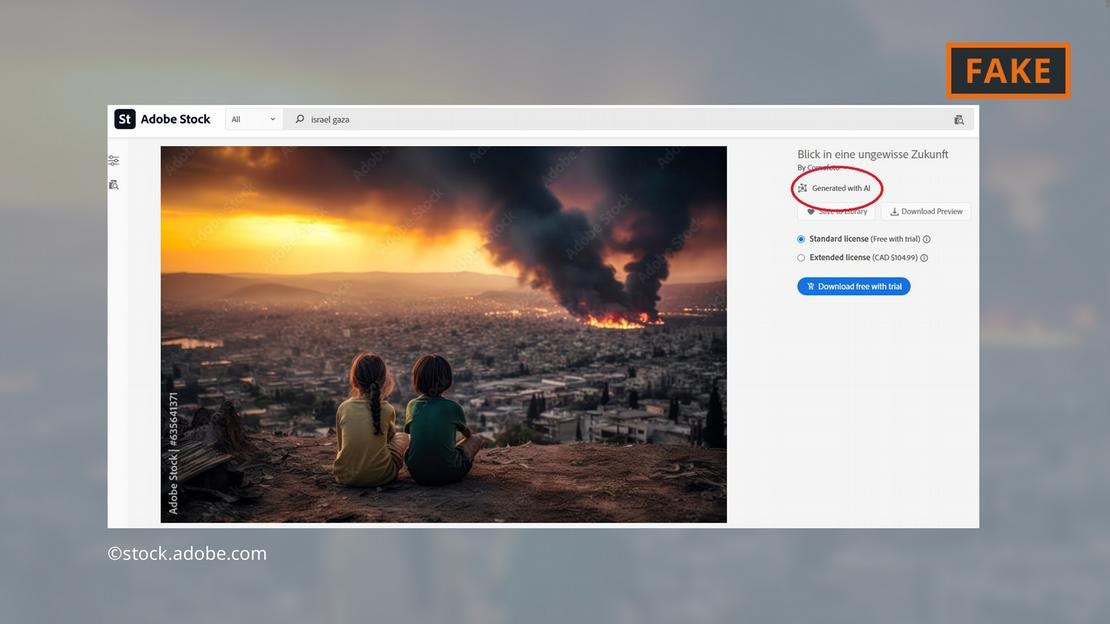

L'éditeur de logiciels Adobe a fait la une des journaux en ajoutant des images générées par l'IA à sa banque d'images d'ici fin 2022. Elles seront étiquetées en conséquence dans la base de données.

Adobe propose désormais également à la vente des images de la guerre au Moyen-Orient réalisées par IA, comme des explosions, des manifestations ou des panaches de fumée derrière la mosquée Al-Aqsa.

Adobe propose des images des combats à Gaza générées par l'IA.

Cette pratique a suscité l'inquiétude des critiques, certains sites continuant d'utiliser ces images sans les signaler comme étant générées par une IA. L'image en question, par exemple, est apparue sur la page « Dernières nouvelles » sans aucune indication qu'elle était générée par une IA.

Même le Service de recherche du Parlement européen, organe scientifique du Parlement européen, a illustré un texte en ligne sur le conflit au Moyen-Orient avec une image générée par IA provenant de la base de données Adobe, sans préciser qu'il s'agissait d'une image générée par IA.

L’Observatoire européen des médias numériques exhorte les journalistes et les professionnels des médias à faire preuve d’une extrême prudence lorsqu’ils utilisent des images générées par l’IA, et déconseille leur utilisation, en particulier lors de la couverture d’événements réels tels que la guerre à Gaza.

À quel point les images générées par l'IA sont-elles dangereuses ?

La viralité des contenus et images générés par l'IA risque de semer le doute chez les internautes. « Si l'on entre dans un monde où images, sons et vidéos peuvent être manipulés, tout devient suspect », explique Farid, chercheur à l'UC Berkeley. « On finit par perdre confiance en tout, même en la vérité. »

C’est précisément ce qui s’est passé dans le cas suivant : une image de ce qui semble être le corps carbonisé d’un bébé israélien a été partagée sur les réseaux sociaux par le Premier ministre israélien Benjamin Netanyahu et plusieurs autres personnalités politiques.

Jackson Hinkle, un influenceur anti-israélien, a par la suite affirmé que l'image avait été créée à l'aide d'une intelligence artificielle. Sa déclaration a été vue plus de 20 millions de fois sur les réseaux sociaux et a suscité de vifs débats.

Finalement, de nombreuses organisations et outils de vérification ont confirmé l'authenticité de l'image et la fausseté des affirmations de Hinkle. Toutefois, il est clair qu'aucun outil ne peut à lui seul rétablir facilement la confiance des utilisateurs.

Hoang Hai (selon DW)

Source

Comment (0)