Microsoft affirme ne pas avoir l'intention de commercialiser ces puces d'IA. Le géant technologique américain les utilisera plutôt en interne, dans ses logiciels, ainsi que dans le cadre de son service de cloud computing Azure.

|

| L’autoproduction de puces est une tendance qui aide les entreprises technologiques à réduire les coûts élevés de l’IA. |

Les dirigeants de Microsoft affirment qu'ils prévoient de faire face à la hausse du coût de l'IA en utilisant un modèle de plateforme commun pour intégrer l'IA à l'ensemble de l'écosystème logiciel. Et la puce Maia est conçue pour cela.

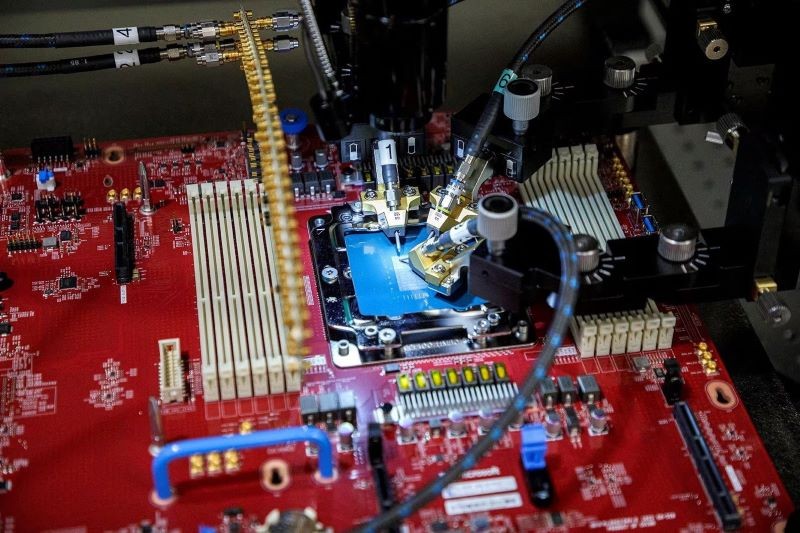

La puce Maia a été conçue par Microsoft pour exécuter de grands modèles de langage (LLM), la base du service Azure OpenAI, une collaboration entre Microsoft et la société propriétaire de ChatGPT.

Microsoft a également annoncé qu'elle offrirait l'année prochaine à ses clients Azure des services cloud fonctionnant sur les dernières puces phares de Nvidia et d'AMD. L'entreprise teste actuellement GPT-4 sur des puces AMD.

Entre-temps, la deuxième puce, nom de code Cobalt, a été lancée par Microsoft pour économiser les coûts internes et concurrencer le service cloud AWS d'Amazon, qui utilise sa propre puce conçue par ses soins « Graviton ».

Cobalt est une unité centrale de traitement (CPU) basée sur Arm actuellement testée pour alimenter le logiciel de messagerie d'entreprise Teams.

AWS affirme que sa puce Graviton compte actuellement environ 50 000 clients et que la société organisera une conférence de développeurs plus tard ce mois-ci.

Rani Borkar, vice-président d'entreprise du matériel et de l'infrastructure Azure, a déclaré que les deux nouvelles puces d'IA sont fabriquées à l'aide du processus 5 nm de TSMC.

La puce Maia est associée à des câbles Ethernet standard, plutôt que d'utiliser la technologie de réseau Nvidia personnalisée plus coûteuse que Microsoft a utilisée dans les supercalculateurs qu'elle a construits pour OpenAI.

Source

![[Photo] Le président de l'Assemblée nationale participe au séminaire « Construire et exploiter un centre financier international et recommandations pour le Vietnam »](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/28/76393436936e457db31ec84433289f72)

Comment (0)