(CLO) Az OpenAI beszédfelismerő eszközét, a Whispert „közel emberi szintű robusztusként és pontosként” hirdetik, de van egy fő hátránya: hajlamos szövegrészleteket vagy akár teljes mondatokat is gyártani!

A szakértők szerint a kitalált szövegek némelyike, amelyeket az iparágban hallucinációs szövegként ismernek, faji kommentárokat, erőszakot és akár képzeletbeli orvosi kezeléseket is tartalmazhat.

A szakértők szerint az ilyen kitalációk komolyak, mivel a Whispert világszerte számos iparágban használják interjúk fordítására és átírására, szövegek generálására és videók feliratozására.

Ami még aggasztóbb, hogy az egészségügyi központok Whisper-alapú eszközöket használnak a beteg-orvos konzultációk rögzítésére, annak ellenére, hogy az OpenAI figyelmeztetett, hogy az eszközt nem szabad „magas kockázatú területeken” használni.

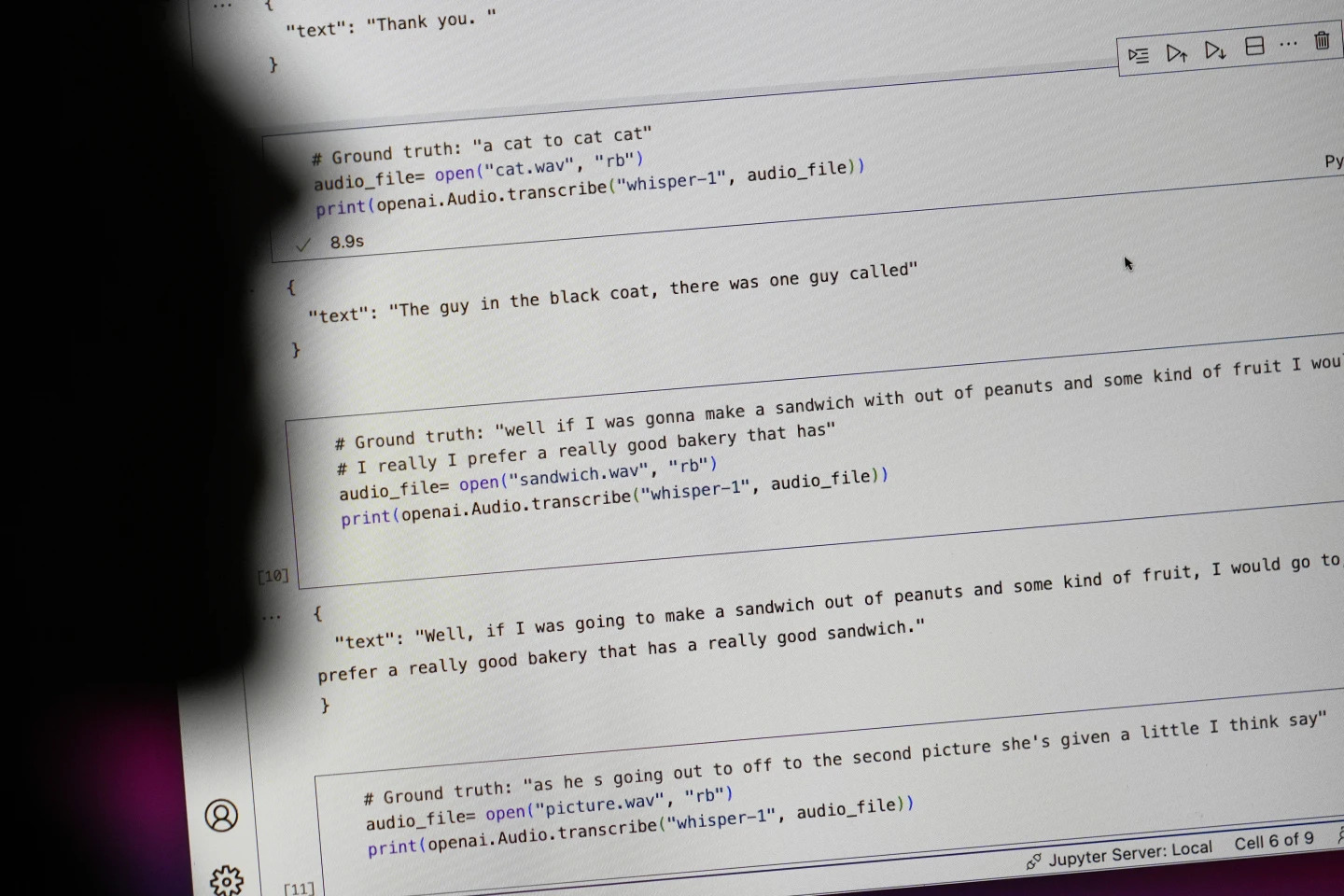

A „#Ground truth” kezdetű mondatok valójában elhangzottak, a „#text” kezdetű mondatok pedig azok, amelyeket Whisper lejegyzett. Fotó: AP

A kutatók és mérnökök szerint a Whisper gyakran hallucinációkat okoz használat közben. Például egy Michigani Egyetem kutatója azt mondta, hogy a megvizsgált 10 felvételből 8-ban hallucinációkat talált.

Egy korai gépi tanulási mérnök a több mint 100 órányi Whisper-átirat körülbelül felében manipulációt talált. Egy harmadik fejlesztő azt mondta, hogy a Whisperrel létrehozott 26 000 átirat szinte mindegyikében hallucinációkat talált.

Az illúzió még rövid, jól felvett hangmintákban is fennáll. Egy számítógépes tudósok által nemrégiben végzett tanulmány 187 torzítást talált több mint 13 000 tiszta hangklipben, amelyeket megvizsgáltak.

Ez a tendencia több tízezer hibához vezetne több millió felvételben, mondták a kutatók.

Az ilyen hibáknak „nagyon súlyos következményei lehetnek”, különösen kórházi környezetben – mondta Alondra Nelson, az Institute for Advanced Study Társadalomtudományi Karának professzora.

„Senki sem akar téves diagnózist kapni. Magasabb akadályra van szükség” – mondta Nelson.

Allison Koenecke, a Cornell Egyetem munkatársa és Mona Sloane, a Virginiai Egyetem munkatársa több ezer rövid részletet vizsgáltak meg, amelyeket a Carnegie Mellon Egyetemen található TalkBank kutatási archívumból szereztek be. Megállapították, hogy a hallucinációk közel 40%-a káros vagy zavaró volt, mivel a beszélő félreérthető vagy téves színben tüntethető fel.

Az egyik felvételen egy beszélő „két másik lányról és egy nőről” beszélt, de Whisper további faji kommentárokat gyártott, hozzátéve „két másik lányt és egy nőt, öhm, aki fekete volt”.

Egy másik átiratban Whisper feltalált egy nem létező gyógyszert, amelyet "fokozott aktivitású antibiotikumoknak" neveznek.

Míg a legtöbb fejlesztő elismeri, hogy az átíró eszközök hibázhatnak helyesírási hibák vagy más hibák miatt, a mérnökök és kutatók azt mondják, hogy még soha nem láttak olyan hallucinogén mesterséges intelligenciával működő átíró eszközt, mint a Whisper.

Az eszköz az OpenAI zászlóshajó chatbotjának, a ChatGPT-nek több verziójába is integrálva van, és az Oracle és a Microsoft felhőalapú számítástechnikai platformjának integrált szolgáltatása, amely világszerte több ezer vállalatot szolgál ki. Emellett szövegek számos nyelvre történő átírására és fordítására is használják.

Ngoc Anh (az AP szerint)

[hirdetés_2]

Forrás: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Fotó] Fedezzen fel egyedi élményeket az első Világkulturális Fesztiválon](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/11/1760198064937_le-hoi-van-hoa-4199-3623-jpg.webp)

![[Fotó] A Világ Kulturális Fesztivál megnyitója Hanoiban](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760113426728_ndo_br_lehoi-khaimac-jpg.webp)

![[Fotó] A főtitkár részt vesz a Koreai Munkáspárt alapításának 80. évfordulóját ünneplő felvonuláson](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/11/1760150039564_vna-potal-tong-bi-thu-du-le-duyet-binh-ky-niem-80-nam-thanh-lap-dang-lao-dong-trieu-tien-8331994-jpg.webp)

![[Fotó] Ho Si Minh-város ragyogóan pompázik a zászlókkal és virágokkal az I. párt 2025-2030-as ciklusának kongresszusának előestéjén.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760102923219_ndo_br_thiet-ke-chua-co-ten-43-png.webp)

Hozzászólás (0)