Departemen Keamanan Informasi baru-baru ini mengeluarkan peringatan mengenai terus terulangnya penipuan video dan gambar berteknologi tinggi.

Oleh karena itu, situasi penjahat dunia maya yang memanfaatkan gambar dan video publik orang untuk diedit, dipotong, dan mengancam akan memeras dengan video palsu telah diperingatkan secara luas oleh pihak berwenang kepada sejumlah besar orang.

Dengan menggunakan teknologi Deepfake yang memungkinkan reproduksi suara dan gambar seseorang dengan akurasi tinggi, penjahat dapat menyamar sebagai pemimpin dalam rapat daring, atau membuat video dan panggilan untuk melakukan penipuan keuangan.

Lebih jauh lagi, penipuan ini sering kali mengeksploitasi faktor psikologis seperti urgensi, ketakutan atau kekuasaan, yang menyebabkan korban bertindak tergesa-gesa tanpa memeriksa keasliannya dengan saksama.

Deepfake tidak terbatas pada penipuan investasi keuangan. Contoh lainnya adalah penipuan asmara, di mana Deepfake digunakan untuk menciptakan karakter fiktif yang berinteraksi dengan korban melalui panggilan video; setelah mendapatkan kepercayaan korban, penipu akan meminta transfer uang untuk mengatasi keadaan darurat, biaya perjalanan, atau pinjaman.

Mengingat situasi di atas, Departemen Keamanan Informasi menyarankan agar masyarakat waspada terhadap saran investasi dari selebriti di jejaring sosial; waspada terhadap pesan, email, atau panggilan telepon yang tidak dikenal; dan cermat dalam mengamati ekspresi wajah yang tidak wajar dalam video.

Orang-orang juga perlu membatasi pengeposan konten yang terkait dengan informasi pribadi di jejaring sosial untuk menghindari informasi seperti gambar, video, atau suara dicuri oleh orang jahat; pada saat yang sama, atur akun ke mode pribadi untuk melindungi informasi pribadi.

Berbicara kepada wartawan Surat Kabar Dai Doan Ket, pakar keamanan siber Ngo Minh Hieu, salah satu pendiri Proyek Pencegahan Penipuan Siber Vietnam (Chongluadao.vn), mengatakan bahwa penggunaan teknologi Deepfake dalam AI untuk memalsukan panggilan video untuk tujuan penipuan masih rumit. Pelaku memanfaatkan teknologi ini untuk meningkatkan kredibilitas "mangsa" mereka.

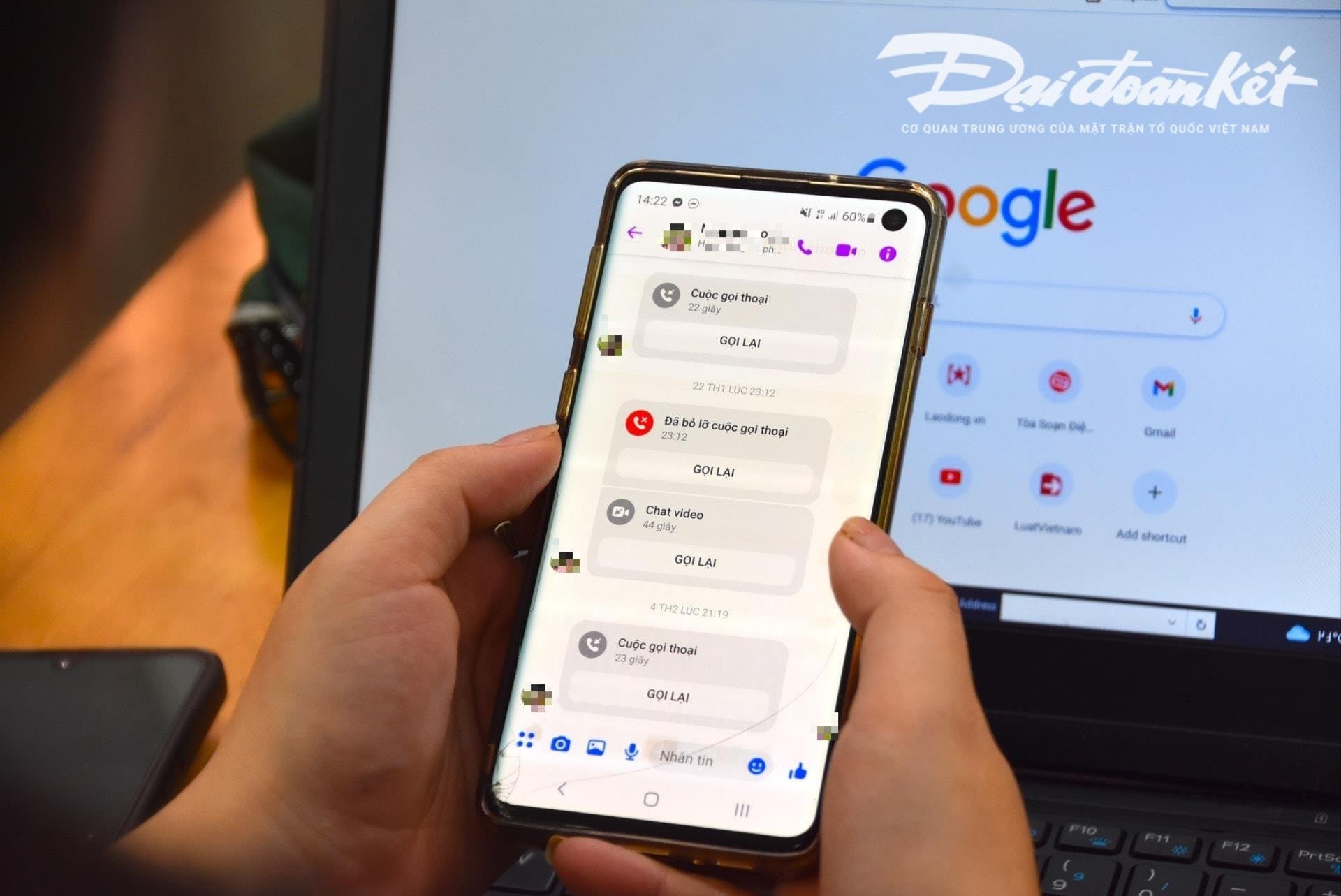

Secara khusus, pelaku akan secara proaktif melakukan panggilan video kepada korban dari gambar dan video yang sebelumnya "dicuri" dan memanipulasi teknik, mendistorsi suara atau masalah gambar palsu untuk mendapatkan kepercayaan korban.

Biasanya panggilan ini sangat singkat, hanya berlangsung beberapa detik saja, kemudian mereka menggunakan alasan jaringan tidak stabil, sedang di jalan, dan sebagainya untuk meminta korban melaksanakan permintaan penipu.

Para ahli memperingatkan bahwa penggunaan AI untuk penipuan siber kemungkinan akan meningkat secara signifikan dalam waktu dekat. Oleh karena itu, masyarakat harus secara proaktif meningkatkan kewaspadaan, terutama saat menerima pesan, panggilan video, dan tautan yang tidak dikenal.

Menurut analisis ahli ini, algoritma kecerdasan buatan (AI) Deepfake saat ini selama panggilan waktu nyata tidak akan mampu menanganinya jika penelepon berbelok ke kiri, berbelok ke kanan, atau berdiri...

Salah satu kelemahan yang perlu diperhatikan orang-orang saat menerima panggilan ini adalah gigi. Oleh karena itu, algoritma AI saat ini tidak dapat mereproduksi gigi orang yang ditiru.

Jika menggunakan Deepfake, gambar orang yang membuka mulutnya mungkin tidak memiliki gigi, beberapa orang mungkin memiliki 3 rahang, atau bahkan 4 rahang. Oleh karena itu, karakteristik gigi merupakan elemen yang paling mudah dikenali dari panggilan palsu menggunakan Deepfake.

"Memperlambat" dan tidak langsung menindaklanjuti permintaan merupakan prasyarat untuk menghindari jebakan penipuan. Saat menerima pesan atau panggilan melalui media sosial, orang perlu menghubungi kerabat mereka secara langsung untuk memverifikasi siapa yang menghubungi mereka dengan waktu minimal lebih dari 30 detik atau bertemu langsung.

Apabila terdapat dugaan tindak pidana penipuan atau penggelapan harta benda melalui media sosial, agar segera melaporkan kepada kepolisian terdekat agar dapat segera ditindaklanjuti dan ditangani.

[iklan_2]

Sumber: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[Foto] Ketua Majelis Nasional Tran Thanh Man menghadiri Upacara Penghargaan VinFuture 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

![[Foto] Peringatan 60 Tahun Berdirinya Asosiasi Seniman Fotografi Vietnam](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

Komentar (0)