ソーシャルメディアを閲覧したことがある人なら、AIが作成した画像や動画を目にしたことがあるでしょう。トランポリンでジャンプするウサギの動画が話題になったように、多くの人が騙されてきました。しかし、OpenAIが開発したChatGPTの姉妹アプリであるSoraは、AI動画を新たなレベルに引き上げ、偽コンテンツの検出をますます緊急なものにしています。

AIビデオツールの登場により、本物のビデオを見分けることがこれまで以上に困難になっています。(出典:CNET)

2024年にリリースされ、最近Sora 2にアップグレードされたこのアプリは、TikTokに似たインターフェースを備えており、すべての動画はAIによって生成されます。「カメオ」機能では、シミュレーション映像に実在の人物を挿入することができ、恐ろしいほどリアルな動画を作成できます。

そのため、多くの専門家は、SORAがディープフェイクの拡散を引き起こし、情報を歪曲し、現実と偽物の境界線を曖昧にすることを懸念しています。著名人は特に脆弱であり、SAG-AFTRAなどの団体はOpenAIに対し、保護強化を求めています。

AI生成コンテンツを識別することは、テクノロジー企業、ソーシャルメディアプラットフォーム、そしてユーザーにとって大きな課題です。しかし、Soraを使って作成された動画を認識する方法は存在します。

ソラの透かしを見つける

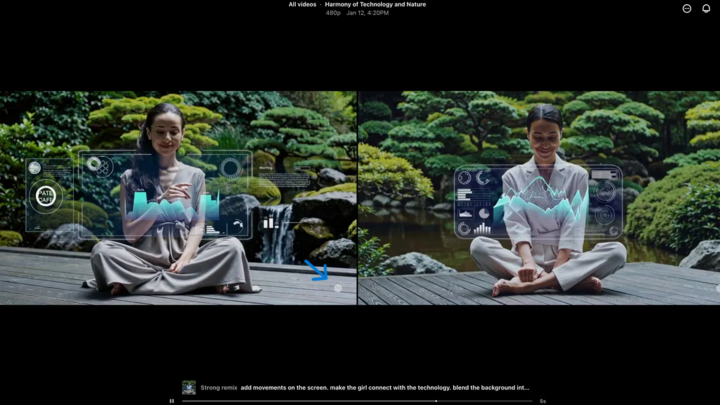

Soraウォーターマーク(青い矢印で表示)は、動画の作成に使用されたツールを識別するためのマーカーです。(出典:CNET)

Sora iOS アプリで作成されたすべてのビデオは、ダウンロード時に透かしが入ります。白い Sora ロゴ (クラウド アイコン) が、TikTok の透かしと同様に、ビデオの端を動き回ります。

これは、AI生成コンテンツを視覚的に識別する方法です。例えば、GoogleのGemini「ナノバナナ」モデルも画像に自動的に透かしを追加します。しかし、透かしは必ずしも信頼できるとは限りません。透かしが静的であれば、簡単に切り取ることができます。Soraのような動的な透かしであっても、専用のアプリケーションを使用すれば削除できます。

この件について質問されたOpenAIのCEO、サム・アルトマン氏は、誰でもフェイク動画を作成できるという現実に社会が適応する必要があると主張しました。Soraが登場する以前、これほど普及し、アクセスしやすく、スキルを必要とせずにフェイク動画を作成できるツールは存在しませんでした。アルトマン氏の見解は、代替的な検証方法に頼る必要性を浮き彫りにしています。

メタデータを確認する

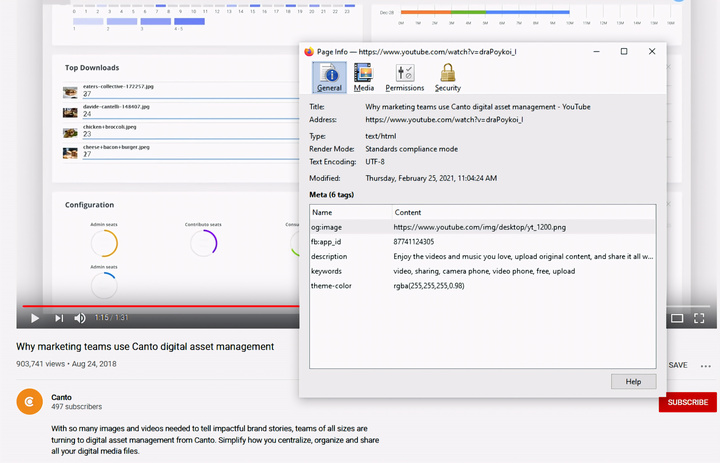

メタデータの確認は、動画がSoraのようなAIによって作成されたかどうかを判断するための重要なステップです。(出典:Canto)

メタデータのチェックは複雑すぎると思うかもしれませんが、実際には非常に簡単で効果的です。

メタデータとは、カメラの種類、場所、録画時間、ファイル名など、コンテンツの作成時に自動的に付加される一連の情報です。コンテンツが人間によって生成されたものでもAIによって生成されたものでも、メタデータは存在します。AIによって生成されたコンテンツの場合、メタデータには多くの場合、ソースの帰属情報が含まれます。

OpenAIはコンテンツの起源と真正性に関する連合(C2PA)のメンバーであるため、Soraの動画にはC2PAメタデータが含まれます。これは、コンテンツ真正性イニシアチブの検証ツールを使用して確認できます。

メタデータを確認する方法:

- verify.contentauthenticity.org にアクセスしてください

- チェックするファイルをアップロードします。

- 「開く」を押します

- 右側の表の情報を参照してください。

動画がAIによって作成された場合、概要にその旨が明記されます。Sora動画を確認すると、「OpenAIによって公開」という行と、動画がAIによって作成されたことを確認する情報が表示されます。すべてのSora動画には、その出所を証明するためにこの情報が記載されている必要があります。

出典: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

コメント (0)