GoogleマップがGemini 2.5モデルを統合

Gemini 2.5モデルの発売後も、Googleは最も馴染みのあるアプリケーションであるGoogleマップに人工知能(AI)の導入を進めています。今回初めて、マップは道順を表示するだけでなく、自然言語で人の話を聞き、理解し、応答できるようになりました。これは、ナビゲーションツールを真のコミュニケーションアシスタントへと進化させる大きな一歩です。

Googleマップがさらに賢くなる

Google DeepMindの公式ブログ(2025年11月)によると、ブラウザを操作し、現実世界のデータを処理できるAIモデル「Gemini 2.5」が、Googleマップへの統合テストを開始したとのことです。目標は、ユーザーが各場所や複雑なオプションを手動で入力するのではなく、 「自然に地図と対話」できるようにすることです。

ジェミニは、「近くの夜遅くまで営業しているレストランを探してほしい。ただし、道路工事を避けてほしい」や「家まで送ってほしい。ただし、途中で薬局に寄ってほしい」といったリクエストを理解できます。システムはリアルタイムの交通データを自動的に読み取り、話者の位置を特定し、最適なルートを提案します。

「Gemini は言葉だけでなく、現実空間におけるユーザーの意図も理解するようにトレーニングされています」と Google は「マップ内で Gemini に質問」機能を紹介する投稿で説明している。

Tuoi Tre Onlineの調査によると、最初のテストバージョンは米国、カナダ、英国で展開されており、2026年にはアジア諸国に拡大する予定だという。一部のAndroidユーザーは、「マップでGeminiに質問」という音声コマンドを起動して、直接指示を出したりチャットしたりできるようになっている。

特別なのは、Gemini が地図を検索するだけでなく、ストリートビュー画像、コミュニティのレビュー、旅行の習慣、天気データも分析するため、地図は「200 メートル先で右折してください」ではなく「この先のミセス ベイのコーヒー ショップで右折してください」のような自然な文章を表示できることです。

「聞く・理解する・応答する」技術とパーソナライゼーションの進歩

技術的には、マップの Gemini は、言語処理、画像、位置データを組み合わせて、人間が知覚するのと同じように世界を「理解」する、マルチモーダル モデルを適用します。

このシステムは、グラウンディング技術(言語を特定のオブジェクトや場所に関連付ける)を使用して、AIが「夕日に向かって進む」や「赤い標識のある交差点を通過する」などの自然な文章を理解できるようにしています。

Geminiは、PixelおよびハイエンドAndroidデバイスに搭載されたデバイス内AIのおかげで、以前のGoogleアシスタントと比較して約2倍の速度とクラウドデータの消費量を削減しました。これにより、ほぼ瞬時の応答が可能になるだけでなく、多くの音声コマンドがユーザーのデバイス上で処理されるため、プライバシー保護も強化されます。

技術観測者らは、マップにジェミニが搭載されることで、地図が真の会話型インターフェースに変わり、ユーザーがハンズフリーで質問したり、ルートを調整したり、場所について調べたりできるようになると述べている。

この傾向は新たな段階も開きます。AI は質問に答えるだけでなく、現実世界で人間に代わって行動し始めます。

Google はまだ正式なリリース日を発表していないが、専門家は 2026 年が道案内、車の予約から個人の旅行管理まで、Android エコシステムへの Gemini のより深い統合を拡大する節目になると予測している。

出典: https://tuoitre.vn/google-maps-nang-cap-biet-nghe-va-tro-chuyen-voi-nguoi-dung-20251107112218748.htm

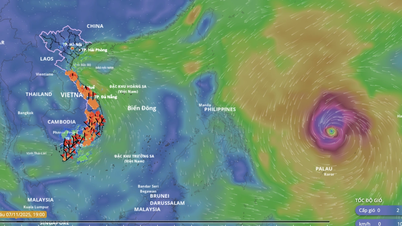

![[写真] ダナン:数百人が嵐13号後の重要な観光ルートの清掃に協力](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/07/1762491638903_image-3-1353-jpg.webp)

コメント (0)