アンスロピックのダリオ・アモデイ氏、グーグルのデミス・ハサビス氏、OpenAIのサム・アルトマン氏といった今日のトップテックCEOにとって、自社のAIが最高だと主張するだけでは不十分だ。3人とも最近、AIは非常に優れたものとなり、社会の構造を根本的に変えるだろうと公言している。

しかし、現代の AI を構築、研究、使用する研究者の間では、こうした主張に懐疑的な見方が増えています。

AIの推論は万能ではない

導入からわずか3年で、人工知能は学習や仕事など、日常生活の多くの場面に浸透し始めています。多くの人が、近い将来、人工知能が人間に取って代わるのではないかと懸念しています。

しかし、今日の新しいAIモデルは、実際には私たちが考えているほど賢くありません。 世界最大級のテクノロジー企業の一つであるAppleの発見が、それを証明しています。

具体的には、「幻想的な思考」と題された新たに公開された研究の中で、Apple の研究チームは、Claude、DeepSeek-R1、o3-mini などの推論モデルは、その名前が示すように実際には「脳主導」ではないと主張しています。

Apple の論文は、多くの同様のエンジニアによる過去の研究や、学界および Salesforce を含む他の大手テクノロジー企業による注目すべき研究に基づいています。

これらの実験は、自律型 AI エージェント、そして最終的にはスーパーインテリジェンスへの次のステップとして歓迎されている推論 AI が、場合によっては、これまでの基本的な AI チャットボットよりも問題解決能力が劣っていることを示しています。

|

Appleの大規模推論モデルに関する新たな研究は、AIモデルがそれほど「脳を集中的に使う」ものではないことを示している。写真: OpenAI。 |

また、この調査では、AIチャットボットや推論モデルを使用した場合でも、すべてのシステムはより複雑なタスクでは完全に失敗しました。

研究者たちは、「推論」という言葉を「模倣」に置き換えるべきだと提言している。研究チームは、これらのモデルはパターンを記憶し、繰り返すことには効率的だが、質問が変化したり、複雑さが増したりすると、ほぼ破綻してしまうと主張している。

もっと簡単に言えば、チャットボットはパターンを認識してマッチングできる場合はうまく機能しますが、タスクが複雑になりすぎると対応できなくなります。「最先端の大規模推論モデル(LRM)は、複雑さが一定の閾値を超えると、精度が完全に低下する」と研究は指摘しています。

これは、リソースが増えれば複雑性が改善されるという開発者の期待に反する。「AI推論の労力は複雑性が高まるにつれて増加するが、それはある程度までであり、それを処理するのに十分なトークンバジェット(計算能力)が残っていても、その後は減少する」と研究は付け加えている。

AIの真の未来

アメリカの心理学者で作家のゲイリー・マーカス氏は、アップルの研究結果は印象的だが、真に新しいものではなく、先行研究を補強するだけだと述べた。ニューヨーク大学心理学・神経科学の名誉教授である同氏は、1998年の研究を例に挙げた。

この論文の中で彼は、大規模言語モデルの先駆けであるニューラル ネットワークは、トレーニングに使用されたデータの分布内ではうまく一般化できるが、分布外のデータに直面すると機能しなくなることが多いと主張しています。

しかし、マーカス氏は、LLM モデルと LRM モデルはどちらも独自の用途があり、場合によっては有用であると考えています。

テクノロジーの世界では、スーパーインテリジェンスは AI 開発の次の段階と考えられており、システムは人間のように考える能力 (AGI) を実現するだけでなく、速度、精度、認識レベルにおいても優れています。

大きな制限があるにもかかわらず、AI 批評家でさえ、コンピューターの超知能への道のりは依然として完全に可能であるとすぐに付け加えます。

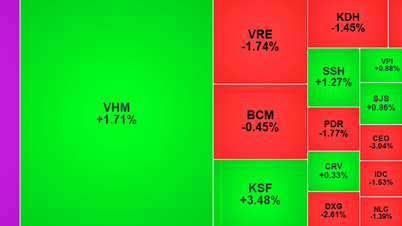

|

OpenAIのCEO、サム・アルトマン氏はかつて、AIは単なるGoogleの代替や宿題のヘルパーではなく、人類の進歩を変えるだろうと述べた。写真: AA Photo |

ラトガース大学研究所の工学准教授ホルヘ・オルティス氏は、現在の限界を明らかにすることで、AI企業がそれを克服する道が示される可能性があると述べている。

オルティス氏は、モデルのパフォーマンスに関する増分フィードバックの提供や、困難な問題に直面したときにリソースを追加するといった、AI がより大きな問題に取り組み、基盤となるソフトウェアをより有効に活用するのに役立つ新しいトレーニング手法の例を挙げた。

一方、ベンチャーキャピタル会社 Lux Capital の共同設立者である Josh Wolfe 氏は、ビジネスの観点から見ると、現在のシステムが推論できるかどうかに関わらず、ユーザーにとって価値を生み出すことになるだろうと述べています。

ペンシルバニア大学のイーサン・モリック教授も、AI モデルは近い将来にこれらの限界を克服するだろうとの確信を表明した。

「モデルはどんどん良くなってきており、AIへの新しいアプローチも絶えず開発されているので、近い将来にこれらの制限が克服されたとしても驚かないだろう」とモリック氏は語った。

出典: https://znews.vn/vi-sao-ai-chua-the-vuot-qua-tri-tue-con-nguoi-post1561163.html

コメント (0)