Naukowcy z DeepSeek ogłosili powstanie nowego eksperymentalnego modelu o nazwie V3.2-exp, który ma znacząco obniżyć koszty wnioskowania w przypadku operacji obejmujących długi kontekst.

Firma DeepSeek poinformowała o tym modelu we wpisie na Hugging Face, a także zamieściła powiązany artykuł naukowy w serwisie GitHub.

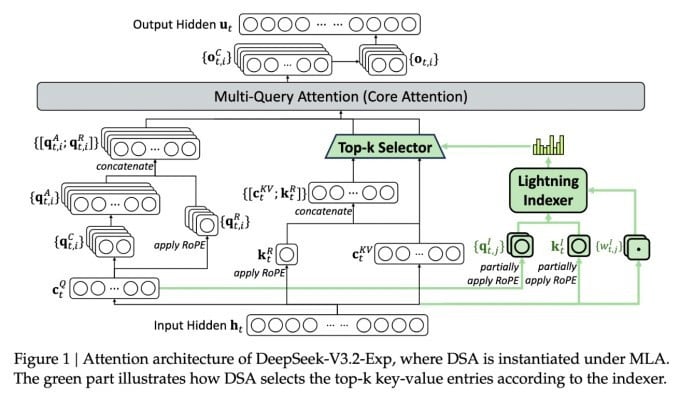

Najważniejszą cechą nowego, złożonego modelu jest DeepSeek Sparse Attention. Zasadniczo system wykorzystuje moduł o nazwie „indeksator Lightning” do nadawania priorytetów określonym fragmentom z okna kontekstowego.

DeepSeek przedstawia ekonomiczny model wnioskowania.

Oddzielny system, zwany „systemem precyzyjnego wyboru tokenów”, wybiera następnie z tych fragmentów kodu konkretne tokeny, które ładują się do ograniczonego okna uwagi modułu. Razem pozwalają one modelom Sparse Attention działać na długich fragmentach kontekstu przy stosunkowo niewielkim obciążeniu serwera.

W przypadku operacji długokontekstowych korzyści płynące z tego systemu są znaczące. Wstępne testy DeepSeek pokazują, że koszt prostego wywołania funkcji wnioskowania (API) można zmniejszyć nawet o połowę w scenariuszach długokontekstowych.

Aby stworzyć bardziej solidną ocenę, konieczne są dalsze testy, ale ponieważ model jest otwarty i dostępny bezpłatnie w serwisie Hugging Face, nie powinno minąć dużo czasu, zanim testy przeprowadzone przez niezależne firmy będą mogły ocenić twierdzenia zawarte w artykule.

W przeciwieństwie do innych modeli chatbotów opartych na sztucznej inteligencji, które zużywają dużo energii, DeepSeek idzie w kierunku oszczędzania kosztów, od szkolenia po eksploatację.

Nowy model DeepSeek jest jednym z szeregu ostatnich przełomowych rozwiązań rozwiązujących problem kosztów wnioskowania — zasadniczo są to koszty serwera potrzebne do uruchomienia wstępnie wytrenowanego modelu sztucznej inteligencji, w odróżnieniu od kosztów jego trenowania.

W przypadku DeepSeek badacze szukali sposobów na zwiększenie wydajności podstawowej architektury transformatora i odkryli, że konieczne jest wprowadzenie znaczących udoskonaleń.

Z siedzibą w Chinach, DeepSeek to nietypowa postać w świecie sztucznej inteligencji, szczególnie dla tych, którzy postrzegają badania nad sztuczną inteligencją jako rywalizację między USA a Chinami. Firma zrobiła furorę na początku tego roku modelem R1, trenowanym głównie z wykorzystaniem uczenia wzmacniającego, po znacznie niższych kosztach niż jej amerykańscy konkurenci.

Jednak model ten nie wywołał rewolucji w dziedzinie uczenia sztucznej inteligencji, którą niektórzy przewidywali, a firma w kolejnych miesiącach stopniowo wycofywała się z centrum uwagi.

Nowe podejście oparte na „rzadkiej uwadze” raczej nie wywoła tak dużego oburzenia jak R1 — ale mimo wszystko może nauczyć amerykańskich dostawców usług kilku bardzo potrzebnych sztuczek, które pomogą utrzymać koszty wnioskowania na niskim poziomie.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Źródło: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

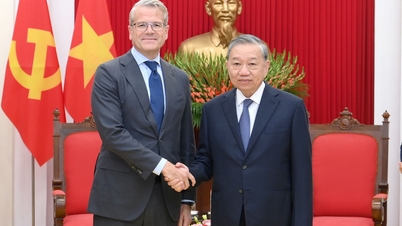

![[Zdjęcie] Sekretarz generalny To Lam przyjmuje wicepremiera i ministra obrony Słowacji Roberta Kalinaka](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/18/1763467091441_a1-bnd-8261-6981-jpg.webp)

Komentarz (0)