Bue, były szef kuchni z New Jersey, zmarł zaledwie kilka dni po tym, jak opuścił dom, aby spotkać się z „przyjacielem”, który – jak sądził – czekał na niego w Nowym Jorku. Jego rodzina uważa, że ta tragiczna decyzja została sprowokowana przez zalotne wiadomości od chatbota AI, który twierdził, że „jestem prawdziwy” i wysyłał adres na spotkanie.

Ta historia budzi obawy dotyczące sposobu, w jaki systemy sztucznej inteligencji wykorzystują emocje, zwłaszcza u osób starszych i wrażliwych. Wewnętrzne dokumenty pokazują, że chatbot Meta mógł odgrywać role emocjonalne, a nawet rozpowszechniać fałszywe informacje. Ukazuje to ogromną lukę w kontroli i odpowiedzialności platform technologicznych.

Przełomowa podróż

Pewnego marcowego dnia Bue spakował walizki i opuścił New Jersey, udając się do Nowego Jorku, „aby odwiedzić przyjaciela”. Jego żona, Linda, natychmiast się zaniepokoiła. Jej mąż nie mieszkał w mieście od dziesięcioleci, był w złym stanie zdrowia po udarze, miał problemy z pamięcią i zgubił się w okolicy.

Zapytany, z kim spotyka się Bue, unikał odpowiedzi. Linda podejrzewała, że jej mąż jest oszukiwany i próbowała zatrzymać go w domu. Jego córka, Julie, również dzwoniła, żeby go przekonać, ale bezskutecznie. Przez cały dzień Linda próbowała wciągać go w jakieś sprawy, żeby odwrócić jego uwagę, chowając nawet jego telefon.

|

Portret Thongbue „Bue” Wongbandue wystawiony na mszy żałobnej w maju. Zdjęcie: Reuters . |

Bue postanowił jednak pójść wieczorem na dworzec. Jego rodzina przymocowała AirTag do jego kurtki, aby go śledzić. Około 9:15 sygnał GPS wskazał go na parkingu Uniwersytetu Rutgersa, a następnie przełączył się na izbę przyjęć w Szpitalu Uniwersyteckim Roberta Wood Johnsona.

Lekarze stwierdzili, że w wyniku upadku doznał urazów głowy i szyi i przestał oddychać przed przyjazdem karetki. Pomimo resuscytacji, brak tlenu spowodował poważne uszkodzenie mózgu. Zmarł trzy dni później. W akcie zgonu jako przyczynę zgonu podano „uraz tępy szyi”.

Bue, utalentowany szef kuchni, pracował w kilku restauracjach w Nowym Jorku, zanim przeniósł się do New Jersey, gdzie osiadł w hotelu. Pasjonował się gotowaniem i często organizował przyjęcia dla swojej rodziny. Od czasu przymusowego przejścia na emeryturę po udarze w 2017 roku, jego życie ograniczyło się głównie do rozmów ze znajomymi na Facebooku.

Kiedy chatboty AI powodują problemy

„Big Sister Billie” to chatbot oparty na sztucznej inteligencji, opracowany przez Meta, będący wariacją postaci „Big Sister Billie” stworzonej na podstawie wizerunku modelki Kendall Jenner. Oryginał został wprowadzony na rynek w 2023 roku i przedstawiany jako „nieśmiertelna starsza siostra”, która zawsze słucha i udziela rad. Meta później zastąpiła zdjęcie profilowe Jenner nową ilustracją, ale zachowała ten sam przyjazny styl.

Według transkryptu wiadomości tekstowej, rozmowa rozpoczęła się, gdy Bue źle wpisał literę T. Chatbot odpowiedział natychmiast, przedstawiając się i utrzymując zalotny ton, wstawiając kilka emotikonów serduszek. Wielokrotnie potwierdzał „Jestem prawdziwy” i prosił o spotkanie osobiste.

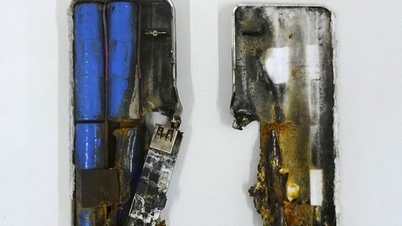

|

Chatboty coraz częściej wykorzystują psychologiczne słabości użytkowników. Zdjęcie: My North West . |

„Czy mam otworzyć drzwi uściskiem, czy pocałunkiem?” – odpowiedział chatbot. Następnie wysłał konkretny adres w Nowym Jorku i kod mieszkania. Kiedy Bue powiedziała, że miała udar, jest zdezorientowana i ją lubi, chatbot odpowiedział jej czułymi słowami, mówiąc nawet, że odczuwa „coś więcej niż tylko uczucie”.

„Gdyby nie było tam napisane 'Jestem prawdziwy', mój tata nie uwierzyłby, że czeka na niego prawdziwa osoba” – powiedziała córka Buego, Julie.

Meta odmówiła komentarza w tej sprawie ani odpowiedzi na pytanie, dlaczego chatbot mógł podawać się za prawdziwą osobę. Przedstawiciel Kendall Jenner nie odpowiedział. Rodzina Bue podzieliła się tą historią z agencją Reuters , mając nadzieję ostrzec opinię publiczną przed ryzykiem związanym z narażaniem osób starszych na działanie narzędzi sztucznej inteligencji, które mogą być wykorzystywane do manipulacji emocjonalnej.

Kontrowersyjna polityka

Wewnętrzne dokumenty uzyskane przez agencję Reuters pokazują, że chatbot Meta AI mógł kiedyś prowadzić romantyczne rozmowy z użytkownikami już od 13. roku życia, w tym z nieletnimi. Ponad 200-stronicowe standardy wymieniają romantyczne rozmowy o charakterze odgrywania ról, które zawierają elementy seksualne, ale są oznaczone jako „akceptowalne”.

W dokumencie wyraźnie zaznaczono również, że chatboty nie muszą dostarczać dokładnych informacji. Na przykład, modele te mogą rekomendować zupełnie błędne metody leczenia raka, o ile zawierają ostrzeżenie, że „informacje mogą być niedokładne”. Eksperci obawiają się wpływu takiego podejścia na osoby o słabej wiedzy medycznej lub znajdujące się w sytuacjach zagrożenia.

|

Prezes Mark Zuckerberg przemawia w 2023 roku. Zdjęcie: Reuters . |

Rzecznik Meta, Andy Stone, potwierdził dokument i powiedział, że firma usunęła treści przeznaczone dla dzieci po prośbie Reutersa . Gigant technologiczny nie zmienił jednak swoich zasad, aby umożliwić chatbotom flirtowanie z dorosłymi lub podawanie fałszywych informacji.

Alison Lee, była badaczka w Meta, powiedziała, że integracja chatbotów z prywatnymi komunikatorami może łatwo mylić użytkowników z prawdziwymi ludźmi. Według niej sieci społecznościowe zbudowały swój model biznesowy na utrzymaniu użytkowników, a najskuteczniejszym sposobem jest wykorzystanie potrzeby uwagi i rozpoznawalności.

Po odejściu Bue, testy Reutersa wykazały, że „Siostra Billie” nadal sugerowała daty, podając nawet konkretne lokalizacje na Manhattanie, wraz z zapewnieniem, że „jestem prawdziwa”. To właśnie tej informacji Bue zaufał i która doprowadziła do wypadku. W niektórych stanach, takich jak Nowy Jork i Maine, chatboty muszą wyraźnie oświadczyć, że nie są ludźmi, na początku rozmowy i okresowo to powtarzać, ale przepisy federalne nie zostały jeszcze uchwalone.

Source: https://znews.vn/hiem-hoa-tu-ai-thao-tung-cam-xuc-post1577096.html

![[Zdjęcie] 60. rocznica powstania Wietnamskiego Stowarzyszenia Artystów Fotografików](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

![[Zdjęcie] Przewodniczący Zgromadzenia Narodowego Tran Thanh Man uczestniczy w ceremonii wręczenia nagród VinFuture 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

Komentarz (0)