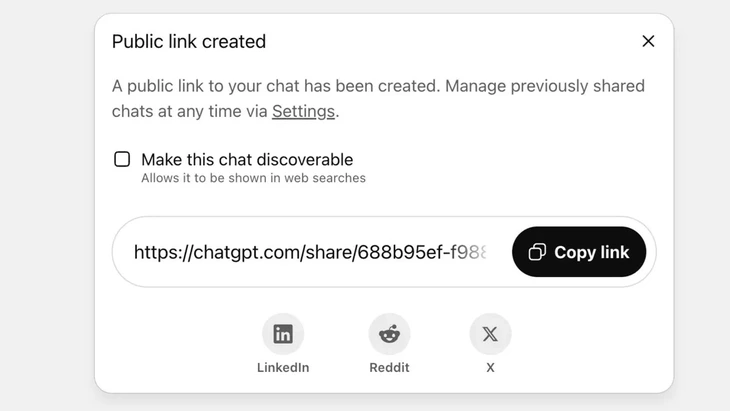

Funcionalidade para compartilhar conversas por meio de link público no ChatGPT - Foto: Techradar

O ChatGPT agora recebe mais de 2,5 bilhões de consultas de usuários globais todos os dias, demonstrando a crescente popularidade desse chatbot.

No entanto, essa ferramenta enfrenta forte reação negativa dos usuários, já que o recurso de "compartilhamento" fez com que milhares de conversas vazassem informações confidenciais para o Google e alguns mecanismos de busca na internet.

Alto risco de segurança

O Sr. Vu Ngoc Son, chefe do departamento de tecnologia da Associação Nacional de Segurança Cibernética (NCA), avaliou que o incidente acima demonstra um alto nível de risco de segurança para os usuários do ChatGPT.

“O incidente acima não é necessariamente uma falha técnica, visto que houve uma certa iniciativa do usuário ao clicar no botão de compartilhamento. No entanto, pode-se dizer que o problema reside no design do chatbot de IA, que confundiu os usuários e não apresenta medidas de alerta suficientemente robustas sobre o risco de vazamento de dados pessoais caso os usuários compartilhem o conteúdo”, analisou o Sr. Vu Ngoc Son.

No ChatGPT, esse recurso é implementado depois que o usuário opta por compartilhar o chat por meio de um link público. O conteúdo será armazenado no servidor da OpenAI como um site público (chatgpt.com/share/...), sem necessidade de login ou senha para acesso.

Os mecanismos de busca do Google escaneiam e indexam automaticamente essas páginas, fazendo com que elas apareçam nos resultados de pesquisa, incluindo textos sensíveis, imagens ou dados de bate-papo.

Muitos usuários desconheciam o risco, pensando que estavam compartilhando o chat com amigos ou contatos. Isso levou à exposição de milhares de conversas, em alguns casos contendo informações pessoais sensíveis.

Embora a OpenAI tenha removido rapidamente esse recurso no final de julho de 2025, após a reação negativa da comunidade, ainda levou tempo para coordenar com o Google a remoção dos índices antigos. Principalmente devido ao complexo sistema de armazenamento, que inclui os servidores de cache do Google, isso não pode ser feito rapidamente.

Não trate os chatbots de IA como uma "caixa preta de segurança".

Especialista em segurança de dados Vu Ngoc Son - chefe de tecnologia da Associação Nacional de Segurança Cibernética (NCA) - Foto: CHI HIEU

O vazamento de milhares de registros de bate-papo pode representar riscos para os usuários, como a revelação de segredos pessoais e comerciais; danos à reputação, riscos financeiros ou até mesmo riscos à segurança devido à divulgação de endereços residenciais.

“Os chatbots com inteligência artificial são úteis, mas não são uma ‘caixa preta’, pois os dados compartilhados podem permanecer na internet para sempre se não forem controlados.

O incidente acima certamente serve de lição tanto para provedores quanto para usuários. Outros provedores de serviços de IA podem aprender com essa experiência e desenvolver recursos com avisos mais claros e transparentes.

Ao mesmo tempo, os usuários também precisam limitar proativamente a publicação descontrolada de informações pessoais ou de identificação em plataformas de IA”, recomendou o especialista em segurança Vu Ngoc Son.

De acordo com especialistas em segurança de dados, o incidente acima demonstra a necessidade de mecanismos legais e padrões de cibersegurança para IA. Fornecedores e desenvolvedores de IA também precisam projetar sistemas que garantam a segurança, evitando o risco de vazamento de dados, como: vazamento por meio de vulnerabilidades graves; vulnerabilidades de software que levam a ataques a bancos de dados; controle inadequado que resulta em envenenamento e abuso para responder a perguntas falsas e distorcidas.

Os usuários também precisam controlar o compartilhamento de informações pessoais com a IA, evitando compartilhar informações sensíveis. Em caso de real necessidade, é recomendável usar o modo anônimo ou criptografar ativamente as informações para evitar que os dados sejam vinculados diretamente a indivíduos específicos.

Fonte: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Foto] Desfile para celebrar o 50º aniversário do Dia Nacional do Laos](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

![[Foto] Adorando a estátua de Tuyet Son - um tesouro de quase 400 anos no Pagode Keo](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764679323086_ndo_br_tempimageomw0hi-4884-jpg.webp&w=3840&q=75)

Comentário (0)