Enligt The Hacker News upptäckte Wiz Research – en startup inom molnsäkerhet – nyligen en dataläcka i Microsoft AI:s GitHub-arkiv, som sades ha blivit av misstag exponerad vid publicering av en grupp träningsdata med öppen källkod.

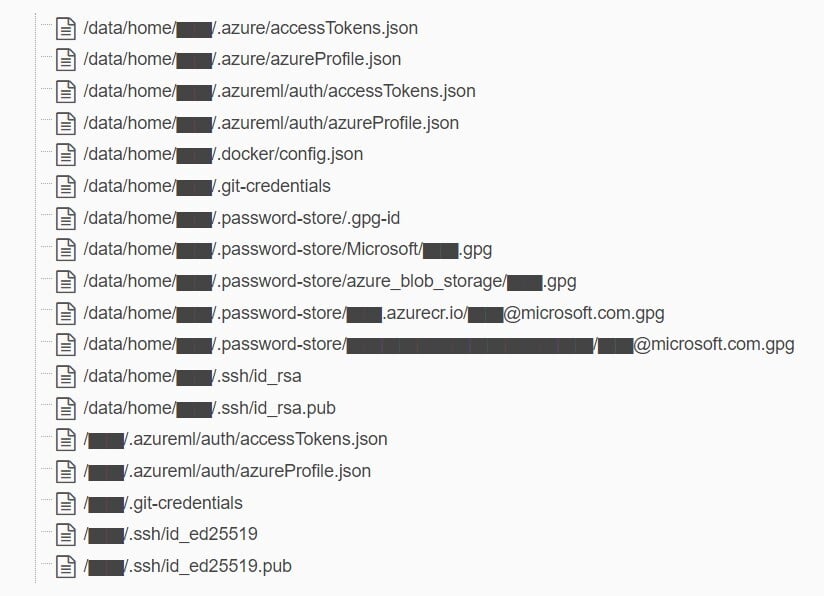

Den läckta informationen inkluderar en säkerhetskopia av två tidigare Microsoft-anställdas arbetsstationer med hemliga nycklar, lösenord och mer än 30 000 interna Teams-meddelanden.

Arkivet, kallat "robust-models-transfer", är nu oåtkomligt. Innan det togs ner innehöll det källkod och maskininlärningsmodeller relaterade till en forskningsartikel från 2020.

Wiz sa att dataintrånget inträffade på grund av sårbarheten hos SAS-tokens, en funktion i Azure som gör det möjligt för användare att dela data som är både svår att spåra och svår att återkalla. Händelsen rapporterades till Microsoft den 22 juni 2023.

Följaktligen instruerade README.md-filen i databasen utvecklare att ladda ner modeller från en Azure Storage-URL, vilket oavsiktligt gav åtkomst till hela lagringskontot och därmed exponerade ytterligare privata data.

Wiz-forskare sa att utöver den överdrivna åtkomsten var SAS-token också felkonfigurerad, vilket möjliggjorde full kontroll snarare än bara läsning. Om det utnyttjades skulle det innebära att en angripare inte bara kunde visa, utan även radera och skriva över alla filer i lagringskontot.

Som svar på rapporten sa Microsoft att deras utredning inte funnit några bevis för att kunddata exponerats, och att inga andra interna tjänster var i fara på grund av händelsen. Företaget betonade att kunderna inte behöver vidta några åtgärder och tillade att de har återkallat SAS-tokens och blockerat all extern åtkomst till lagringskonton.

För att minska liknande risker har Microsoft utökat sin hemliga skanningstjänst för att leta efter SAS-tokens som kan ha begränsade eller överdrivna behörigheter. De identifierade också ett fel i sitt skanningssystem som felaktigt flaggade SAS-URL:er i databasen.

Forskare säger att på grund av bristande säkerhet och styrning av SAS-kontotokens är försiktighetsåtgärden att undvika att använda dem för extern delning. Fel vid tokengenerering kan lätt förbises och exponera känsliga data.

Tidigare i juli 2022 tillkännagav JUMPSEC Labs ett hot som kunde utnyttja dessa konton för att få tillgång till företag.

Känsliga filer hittades i säkerhetskopior av Wiz Research

Detta är Microsofts senaste säkerhetsintrång. För två veckor sedan avslöjade företaget också att hackare med ursprung i Kina hade trängt sig in och stulit högsäkerhetsnycklar. Hackare tog över kontot som tillhörde en ingenjör på företaget och fick åtkomst till användarens digitala signaturarkiv.

Den senaste händelsen visar de potentiella riskerna med att integrera AI i stora system, säger Ami Luttwak, teknisk chef på Wiz. Men i takt med att dataforskare och ingenjörer kämpar för att implementera nya AI-lösningar kräver de enorma mängder data de bearbetar ytterligare säkerhetskontroller och skyddsåtgärder.

Med många utvecklingsteam som behöver arbeta med enorma mängder data, dela den informationen med sina kollegor eller samarbeta i publika projekt med öppen källkod, blir fall som Microsofts allt svårare att spåra och undvika.

[annons_2]

Källänk

![[Foto] Lam Dong: Närbild av illegal sjö med trasig vägg](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762166057849_a5018a8dcbd5478b1ec4-jpg.webp)

![[Foto] Generalsekreterare To Lam tar emot Singapores ambassadör Jaya Ratnam](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762171461424_a1-bnd-5309-9100-jpg.webp)

![[Foto] Premiärminister Pham Minh Chinh tar emot ordföranden för Japan-Vietnam-vänskapsföreningen i Kansai-regionen.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762176259003_ndo_br_dsc-9224-jpg.webp)

![[Foto] Höstmässan 2025 och imponerande rekord](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762180761230_ndo_br_tk-hcmt-15-jpg.webp)

Kommentar (0)