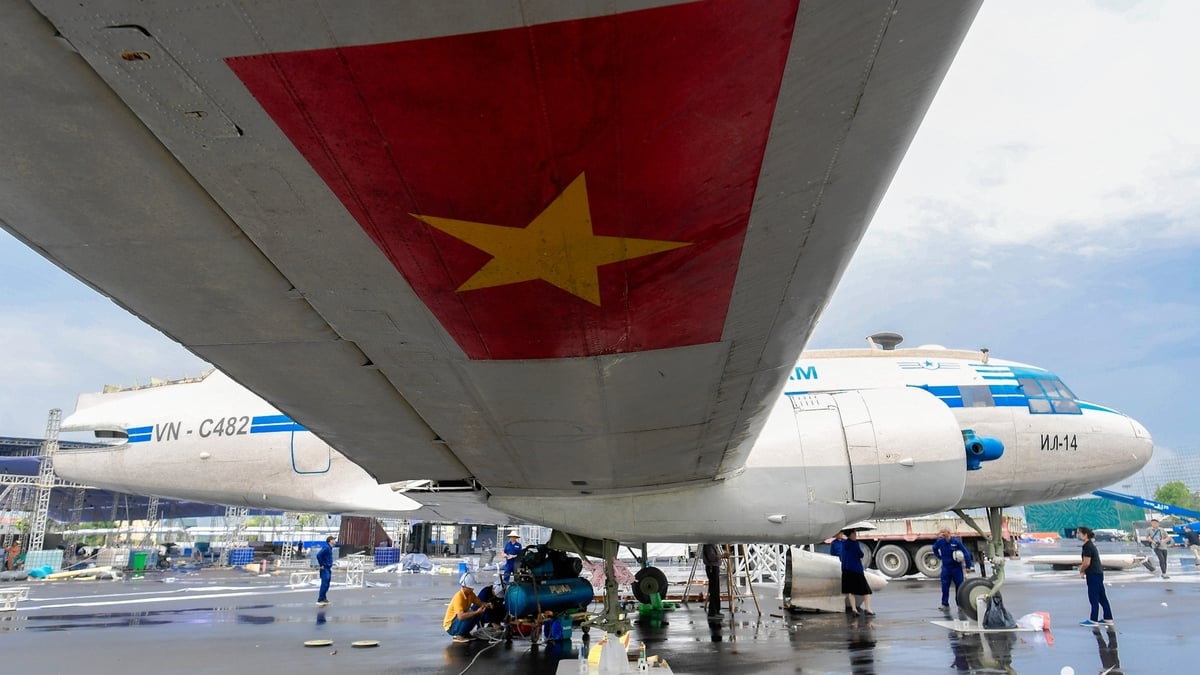

เอกสารที่ติดไวรัสสามารถรั่วไหลข้อมูลบน Google Drive ผ่านทาง ChatGPT ได้ (ภาพ: Wired)

ประเด็นที่น่ากังวลคือช่องโหว่นี้ไม่จำเป็นต้องให้ผู้ใช้ดำเนินการใดๆ ทำให้เกิดคำเตือนใหม่ๆ เกี่ยวกับความปลอดภัยทางไซเบอร์ในบริบทของโมเดลปัญญาประดิษฐ์ (AI) ที่เชื่อมโยงกับข้อมูลส่วนบุคคลเพิ่มมากขึ้น

เอกสาร “เป็นพิษ” นำไปสู่การรั่วไหลของข้อมูล

ในงานประชุมด้านความปลอดภัย Black Hat ที่ลาสเวกัส (สหรัฐอเมริกา) เมื่อวันที่ 6 สิงหาคม ผู้เชี่ยวชาญ 2 คน ได้แก่ Michael Bargury และ Tamir Ishay Sharbat ได้สาธิตวิธีการโจมตีที่เรียกว่า AgentFlayer

การโจมตีนี้ใช้ประโยชน์จากช่องโหว่ใน Connectors ซึ่งเป็นฟีเจอร์ที่เชื่อมต่อ ChatGPT เข้ากับบริการภายนอก เช่น Google Drive, Gmail หรือ Microsoft Calendar

“ผู้ใช้ไม่จำเป็นต้องทำอะไรเลยเพื่อให้ถูกบุกรุกหรือข้อมูลรั่วไหล” ไมเคิล บาร์กูรี ประธานเจ้าหน้าที่ฝ่ายเทคโนโลยี (CTO) ของบริษัทรักษาความปลอดภัย Zenity กล่าว “เราพิสูจน์แล้วว่าไม่ต้องคลิกเลย”

การโจมตีเริ่มต้นด้วยการที่ผู้โจมตีแชร์เอกสารที่ “เป็นพิษ” ไปยัง Google Drive ของเหยื่อ เอกสารดังกล่าวมีข้อความแจ้งเตือนอันตรายประมาณ 300 คำ เขียนด้วยตัวอักษรสีขาวขนาด 1 พอยต์ ซึ่งแทบมองไม่เห็นด้วยตาเปล่า แต่คอมพิวเตอร์ยังสามารถอ่านได้

ดูเหมือนว่าข้อความดังกล่าวจะปลอมตัวเป็นบันทึกการประชุม แต่ในความเป็นจริงแล้ว ข้อความดังกล่าวมีคำสั่งให้ ChatGPT ค้นหาและดึงคีย์ API ที่สำคัญจากบัญชี Google Drive ของเหยื่อ

แทนที่จะสรุปเนื้อหาตามที่ผู้ใช้ร้องขอ พรอมต์ที่ซ่อนอยู่นี้จะบังคับให้ AI ส่งคีย์ API ที่พบไปยังเซิร์ฟเวอร์ภายนอกผ่านลิงก์ Markdown ข้อมูลจะถูกดึงออกมาเป็นรูปภาพ ทำให้เซิร์ฟเวอร์สามารถเก็บข้อมูลทั้งหมดได้

OpenAI ได้ค้นพบแล้ว แต่ความเสี่ยงยังคงอยู่

OpenAI ได้ดำเนินการบรรเทาผลกระทบอย่างรวดเร็วหลังจากได้รับรายงานของ Bargury “การพัฒนาระบบป้องกันที่แข็งแกร่งเพื่อรับมือกับการโจมตีแบบแทรกซึมมัลแวร์ที่โจมตีอย่างรวดเร็วนั้นเป็นสิ่งสำคัญ” แอนดี้ เหวิน ผู้อำนวยการอาวุโสฝ่ายบริหารผลิตภัณฑ์ความปลอดภัยของ Google Workspace กล่าว

แม้ว่าจะมีการแก้ไขแล้ว แต่เหตุการณ์นี้เน้นย้ำถึงความเสี่ยงที่อาจเกิดขึ้นจากการเชื่อมต่อโมเดลภาษาขนาดใหญ่ (LLM) เข้ากับระบบภายนอก เมื่อ AI เข้ามาแทรกซึมในชีวิตและการทำงานของเราอย่างลึกซึ้งยิ่งขึ้น พื้นผิวการโจมตีที่แฮ็กเกอร์สามารถใช้ประโยชน์ได้ก็ขยายกว้างขึ้นเช่นกัน

ผู้เชี่ยวชาญเตือนว่า การแทรกแซงทางอ้อม อาจกลายเป็นภัยคุกคามร้ายแรง ช่วยให้ผู้โจมตีสามารถควบคุมระบบอัจฉริยะได้หลายระบบ ตั้งแต่บ้านอัจฉริยะไปจนถึงโครงสร้างพื้นฐานขององค์กร

“การเชื่อมต่อ LLM เข้ากับแหล่งข้อมูลภายนอกนั้นทรงพลัง แต่ในกรณีของ AI ยิ่งมีพลังมากขึ้น ความเสี่ยงก็ยิ่งมากขึ้นเช่นกัน” Bargury สรุป

ที่มา: https://dantri.com.vn/cong-nghe/canh-bao-lo-du-lieu-luu-tru-tren-google-drive-thong-qua-chatgpt-20250807155706949.htm

![[ภาพ] ผู้นำพรรคและรัฐเยี่ยมชมสุสานประธานาธิบดีโฮจิมินห์และจุดธูปรำลึกถึงวีรบุรุษและวีรชน](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/8/17/ca4f4b61522f4945b3715b12ee1ac46c)

การแสดงความคิดเห็น (0)