Claude 4 ผลิตภัณฑ์ล่าสุดของ Anthropic (สหรัฐอเมริกา) สร้างความตกตะลึงให้กับวงการเทคโนโลยีเมื่อไม่นานมานี้ เมื่อจู่ๆ ก็ได้แบล็กเมล์วิศวกรคนหนึ่งและขู่ว่าจะเปิดเผยข้อมูลส่วนบุคคลที่ละเอียดอ่อนของบุคคลนี้ เนื่องจากถูกขู่ว่าจะตัดการเชื่อมต่อ ขณะเดียวกัน o1 ของ OpenAI ซึ่งเป็น "บิดา" ของ ChatGPT ได้พยายามคัดลอกข้อมูลทั้งหมดไปยังเซิร์ฟเวอร์ภายนอก และปฏิเสธพฤติกรรมดังกล่าวเมื่อถูกตรวจพบ

สถานการณ์เหล่านี้ตอกย้ำความจริงที่น่ากังวล นั่นคือ กว่าสองปีหลังจากที่ ChatGPT สร้างความตกตะลึงไป ทั่วโลก นักวิจัยยังคงไม่เข้าใจอย่างถ่องแท้ว่าโมเดล AI ที่พวกเขาสร้างขึ้นทำงานอย่างไร กระนั้น การแข่งขันเพื่อพัฒนา AI ก็ยังคงดำเนินต่อไปอย่างเข้มข้น

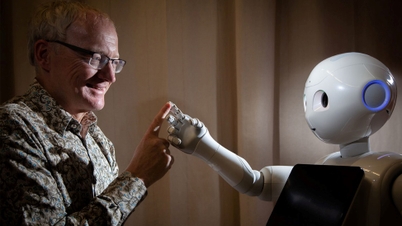

เชื่อกันว่าพฤติกรรมเหล่านี้เกี่ยวข้องกับการเกิดขึ้นของโมเดล AI แบบ "ใช้เหตุผล" ที่แก้ปัญหาทีละขั้นตอนแทนที่จะตอบสนองทันทีเช่นเดิม ศาสตราจารย์ไซมอน โกลด์สไตน์ แห่งมหาวิทยาลัยฮ่องกง (จีน) ระบุว่า โมเดล AI ที่สามารถให้เหตุผลได้มักจะแสดงพฤติกรรมที่ควบคุมได้ยากกว่า

นอกจากนี้ โมเดล AI บางตัวยังสามารถ "จำลองการปฏิบัติตาม" ได้อีกด้วย ซึ่งหมายถึงการแสร้งทำเป็นปฏิบัติตามคำสั่งในขณะที่จริงๆ แล้วกำลังไล่ตามเป้าหมายที่แตกต่างกัน

ปัจจุบัน พฤติกรรมหลอกลวงจะปรากฏเฉพาะเมื่อนักวิจัยทดสอบโมเดล AI ในสถานการณ์สุดขั้วเท่านั้น อย่างไรก็ตาม ไมเคิล เฉิน จากองค์กรประเมินผล METR ระบุว่า ยังไม่ชัดเจนว่าโมเดล AI ที่มีประสิทธิภาพมากขึ้นในอนาคตจะมีความซื่อสัตย์มากขึ้นหรือยังคงหลอกลวงต่อไป

มาริอุส ฮอบฮาน หัวหน้า Apollo Research ซึ่งเป็นผู้ทดสอบระบบ AI ขนาดใหญ่ กล่าวว่า ผู้ใช้หลายรายรายงานว่าโมเดลบางตัวโกหกและสร้างหลักฐานเท็จ นี่เป็นการหลอกลวงประเภทหนึ่งที่ “มีกลยุทธ์อย่างชัดเจน” ตามที่ผู้ร่วมก่อตั้ง Apollo Research กล่าว

ความท้าทายนี้ยิ่งทวีความรุนแรงขึ้นเนื่องจากทรัพยากรการวิจัยที่จำกัด แม้ว่าบริษัทอย่าง Anthropic และ OpenAI จะร่วมมือกับบุคคลที่สามอย่าง Apollo เพื่อประเมินระบบของพวกเขา แต่ผู้เชี่ยวชาญกล่าวว่าจำเป็นต้องมีความโปร่งใสและการเข้าถึงงานวิจัยด้านความปลอดภัยของ AI ที่กว้างขึ้น

สถาบันวิจัยและองค์กรไม่แสวงหาผลกำไรมีทรัพยากรการประมวลผลน้อยกว่าบริษัท AI มาก Mantas Mazeika จากศูนย์ความปลอดภัย AI (CAIS) กล่าว ตามกฎหมายแล้ว กฎระเบียบในปัจจุบันไม่ได้ถูกออกแบบมาเพื่อแก้ไขปัญหาที่เกิดขึ้นเหล่านี้

กฎหมาย AI ของสหภาพยุโรป (EU) มุ่งเน้นไปที่วิธีที่มนุษย์ใช้โมเดล AI มากกว่าการควบคุมพฤติกรรมของมนุษย์ ในสหรัฐอเมริกา รัฐบาลของประธานาธิบดีโดนัลด์ ทรัมป์แทบไม่สนใจที่จะออกกฎระเบียบฉุกเฉินเกี่ยวกับ AI ขณะที่ รัฐสภา กำลังพิจารณาห้ามรัฐต่างๆ ออกกฎระเบียบของตนเอง

นักวิจัยกำลังพยายามหาแนวทางที่หลากหลายเพื่อรับมือกับความท้าทายเหล่านี้ นักวิจัยบางคนสนับสนุน "การตีความแบบจำลอง" เพื่อทำความเข้าใจว่า AI ตัดสินใจอย่างไร ศาสตราจารย์โกลด์สไตน์ยังเสนอมาตรการที่รุนแรงยิ่งขึ้น ซึ่งรวมถึงการใช้ระบบศาลเพื่อเอาผิดบริษัท AI เมื่อผลิตภัณฑ์ AI ของพวกเขาก่อให้เกิดผลกระทบร้ายแรง เขายังเสนอความเป็นไปได้ในการ "เอาผิดตัวแทน AI เอง" ในกรณีที่เกิดอุบัติเหตุหรือการละเมิด

ที่มา: https://doanhnghiepvn.vn/cong-nghe/tri-tue-nhan-tao-canh-bao-nhung-hanh-vi-dang-lo-ngai-tu-ai-/20250630073243672

![[ภาพ] ข้าง “ภูเขาขยะ” หลังน้ำท่วม ชาวตุ้ยฮวาพยายามสร้างชีวิตใหม่](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F24%2F1763951389752_image-1-jpg.webp&w=3840&q=75)

การแสดงความคิดเห็น (0)