Níže uvádíme názory dvou expertů z RMIT University na škodlivé účinky deepfake a navrhovaná řešení tohoto problému:

|

| Dr. Jonathan Crellin (vlevo) a Dr. Nguyen Van Thang Long (vpravo). (Zdroj: Univerzita RMIT) |

Kyberzločinci zneužívají nové technologie nepředvídatelnými způsoby

Dr. Jonathan Crellin, vedoucí katedry informační bezpečnosti, Fakulta vědy , inženýrství a technologie, Univerzita RMIT :

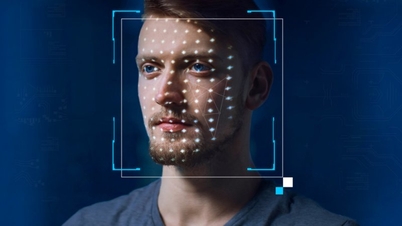

Deepfake je strojově generovaný obrázek, který dokáže kombinovat obrázky nebo videa z více zdrojů a vytvářet tak velmi realistický obraz, video nebo dokonce zvuk.

Deepfake se spoléhá na techniku v umělé inteligenci zvanou strojové učení, která dokáže nahradit a integrovat prvky, jako je obličej osoby, do jiného obrázku nebo videa.

Jedním z příkladů použití deepfake je kombinování pornografického obsahu s fotografiemi Taylor Swift za účelem vytvoření falešných obrázků.

K tomu strojový tvůrce potřeboval řadu obrázků, aby software mohl zjistit výrazy obličeje zpěvačky a poté je zkombinovat s pornografickým obsahem a vytvořit obscénní fotografie, čímž poškodil image zpěvačky.

Ve skutečnosti se říká, že tyto fotografie zveřejnila skupina na Telegramu a byly vytvořeny pomocí nástroje Microsoft Designer s integrovanou podporou umělé inteligence.

Obětí se může stát kdokoli, protože zločincům stačí fotografie, video nebo zvukový záznam osoby, za kterou se vydávají.

Falešné zprávy v mnoha podobách mají potenciál být zneužity k vytváření falešných zpráv a lze s jistotou říci, že nadcházející prezidentské volby v USA budou takovými falešnými zprávami plné.

V současné době se zákonodárci po celém světě snaží přijmout zákony proti tomuto typu zobrazování.

Ve Spojených státech se začíná uplatňovat několik legislativních přístupů, jako je například spoléhání se na občanskoprávní žaloby nebo zákony řešící „šíření sexuálně explicitních obrázků osoby generovaných umělou inteligencí bez jejího souhlasu“.

Čína také zavedla nová nařízení, která by umožnila stíhání těch, kteří šíří obrázky generované umělou inteligencí.

Spojené království zavedlo v rámci zákona o online bezpečnosti nelegální sdílení deepfake obsahu.

Jak to odhalit nebo jak tomu předejít?

Prvním krokem je snížit počet fotografií, videí nebo zvukových nahrávek, které máte online. Ujistěte se, že je sdílíte pouze s lidmi, které znáte, a nezveřejňujte je online široce. Jakmile se něco dostane na internet, je téměř nemožné to odstranit.

Druhým způsobem je dohodnout se s rodinou na tajném slově pro ověření hovoru, čímž se sníží riziko chycení se do pasti falešného hovoru.

Obrázky, zejména videa, mohou obsahovat podivné (vypadající jako inscenované) chyby. Pokud si těchto chyb všimnete, je vysoká pravděpodobnost, že obraz nebo zvuk byl zfalšován.

Další technikou, kterou lze použít, je vyhledání výrazu „obrácený obrázek“ na Googlu nebo v jiných vyhledávačích, aby se určil zdroj původního obrázku.

Poslední ponaučení zní, nevěřte slepě tomu, co vidíte, kamera (nebo umělá inteligence) může lhát!

Deepfakes představují obrovskou hrozbu pro celebrity a politiky.

Dr. Nguyen Van Thang Long, docent, Fakulta komunikace a designu, Univerzita RMIT :

Vzhledem k šíření falešných zpráv z deepfakes prostředí potřebují mediální týmy celebrit a politiků mít k dispozici zdroje pro monitorování a rychlou reakci na falešné zprávy nebo pro jejich průběžnou opravu.

Pokud se deepfakey systematicky kombinují s organizovanými formami „špinavého PR“, stává se tento úkol ještě obtížnějším kvůli šíření protichůdných informací a falešné zprávy a negativní zprávy budou vždy sdíleny více než zprávy pozitivní.

Obvykle, když vidí zprávy sdílené na sociálních sítích, mají jednotlivci ve zvyku ověřovat si informace prostřednictvím oficiálních mediálních kanálů.

Vzhledem k tomu, že sociální média zaplavuje deepfake obsah, je ověřování přesnosti mainstreamových zpráv stále obtížnější a časově náročnější, což vyžaduje hloubkový výzkum a ověřovací techniky.

Čím déle budeme otálet s ověřováním zpráv a zdrojů, tím je pravděpodobnější, že se budou šířit nepravdivé, vykonstruované nebo zavádějící informace kvůli rychlé rychlosti sdílení a komentování na sociálních sítích.

To zhoršuje základní problém a může vést k sociálním nepokojům, zejména pokud se obsah týká politických projevů, náboženství, genderových otázek, obchodních strategií nebo makroekonomických otázek.

V kontextu šíření deepfake zůstává nejúčinnější strategií řízení rizik udržování konzistentních komunikačních kanálů, a to prostřednictvím populárních platforem sociálních médií, webových stránek nebo osobních setkání, mezi podniky, celebritami, politiky a klíčovými zúčastněnými stranami, jako jsou fanoušci, tisk, komunity a zaměstnanci.

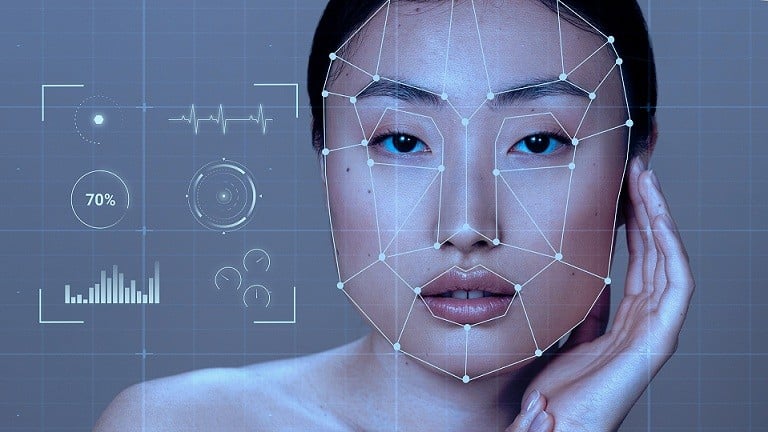

|

Zvýšené využívání umělé inteligence přináší jak výhody, tak i neočekávané nové problémy. Ilustrační foto. (Zdroj: Freepik) |

Udržováním těchto komunikačních kanálů se příjem informací týkajících se deepfaků zrychluje, což umožňuje včasnou a efektivní korekci fám a odhalování dezinformací hned od samého začátku.

Firmy, celebrity a politici však musí vypracovat plán krizového řízení speciálně pro deepfakes. Například musí stanovit, kdo podává zprávy, prostřednictvím kterých mediálních kanálů, kritéria pro ověřování informací prostřednictvím důkazů a renomovaných zdrojů, stanovit časový harmonogram pro řešení fám a nastínit strategii pro obnovení reputace.

S dobře připraveným a metodickým plánem bude zvládnutí deepfake krize proveditelnější a minimalizují se tak neblahé následky, které by mohly nastat.

Zdroj

![[Fotografie] Zahájení 14. konference ústředního výboru strany 13. sněmu](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/05/1762310995216_a5-bnd-5742-5255-jpg.webp)

![[Fotografie] Panorama vlasteneckého soutěžního kongresu novin Nhan Dan na období 2025-2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/04/1762252775462_ndo_br_dhthiduayeuncbaond-6125-jpg.webp)

Komentář (0)