Temná umělá inteligence funguje mimo bezpečnostní standardy a často umožňuje chování, jako jsou podvody, manipulace, kybernetické útoky nebo zneužívání dat, bez pečlivého dohledu.

„Zlomyslní aktéři také zneužívají umělou inteligenci ke zlepšení svých útočných schopností. Nejčastějším zneužitím umělé inteligence je dnes vznik modelů Black Hat GPT. Jedná se o modely umělé inteligence speciálně vyvinuté nebo upravené tak, aby sloužily k nezákonným účelům, jako je vytváření malwaru, psaní phishingových e-mailů, generování hlasových a deepfake videí…,“ sdělil Sergej Ložkin, vedoucí globálního výzkumného a analytického týmu (GReAT) pro Blízký východ, Turecko, Afriku a Asii a Tichomoří ve společnosti Kaspersky.

Black Hat GPT mohou existovat jako zcela soukromé nebo polosoukromé modely umělé inteligence. Mezi pozoruhodné příklady patří WormGPT, DarkBard, FraudGPT a Xanthorox, všechny navržené pro boj s kyberkriminalitou, podvody a škodlivými automatizačními aktivitami.

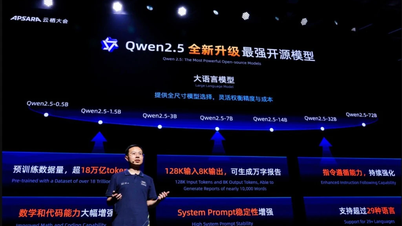

Ložkin prozradil, že experti společnosti Kaspersky nyní pozorují ještě znepokojivější trend: státem nebo vládou podporované kybernetické útočné skupiny začínají ve svých útočných kampaních využívat modely velkých jazyků (LLM).

„OpenAI nedávno oznámila, že zmařila více než 20 tajných kampaní na získávání vlivu a kybernetických útoků, které zneužívaly její nástroje umělé inteligence. Budeme muset čelit stále sofistikovanějším útočníkům, kteří umělou inteligenci zneužívají jako zbraň a stávají se hrozbou ve veřejných i soukromých ekosystémech. Toto je znepokojivý trend, na který se musí připravit všechny organizace,“ sdělil Ložkin.

Podle zprávy OpenAI začali útočníci využívat schopnosti rozsáhlých modelů strojového učení (LLM) k oklamání obětí a obcházení konvenčních bezpečnostních vrstev. Mohou vytvářet přesvědčivé falešné zprávy, rozesílat hromadné zprávy obětem a produkovat obsah ve více jazycích.

Pro posílení obrany proti hrozbám temné umělé inteligence (Dark AI) experti společnosti Kaspersky doporučují: Využívání bezpečnostních řešení nové generace, jako je Kaspersky Next, k detekci malwaru generovaného umělou inteligencí a kontrole rizik v dodavatelském řetězci; používání nástrojů pro analýzu hrozeb v reálném čase k monitorování zneužívání zranitelností řízených umělou inteligencí; posílení kontroly přístupu a školení zaměstnanců s cílem omezit rizika stínové umělé inteligence a úniku dat; a zřízení Centra bezpečnostních operací (Security Operations Center, SOC) pro monitorování hrozeb a rychlou reakci na incidenty.

Zdroj: https://www.sggp.org.vn/kaspersky-canh-bao-toi-pham-mang-dung-dark-ai-tan-cong-post808493.html

![[Foto] Premiér Pham Minh Chinh telefonicky hovořil s generálním ředitelem ruské korporace Rosatom.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F11%2F1765464552365_dsc-5295-jpg.webp&w=3840&q=75)

Komentář (0)