Microsoft hat nach eigenen Angaben keine Pläne, die KI-Chips zu kommerzialisieren. Stattdessen will der US-Technologieriese sie intern in seinen Softwareprodukten sowie als Teil seines Cloud-Computing-Dienstes Azure einsetzen.

|

| Die Eigenproduktion von Chips ist ein Trend, der Technologieunternehmen hilft, hohe KI-Kosten zu senken. |

Führungskräfte von Microsoft wollen den steigenden Kosten für KI begegnen, indem sie ein gemeinsames Plattformmodell nutzen, um KI tief in das gesamte Software-Ökosystem zu integrieren. Und genau dafür ist der Maia-Chip konzipiert.

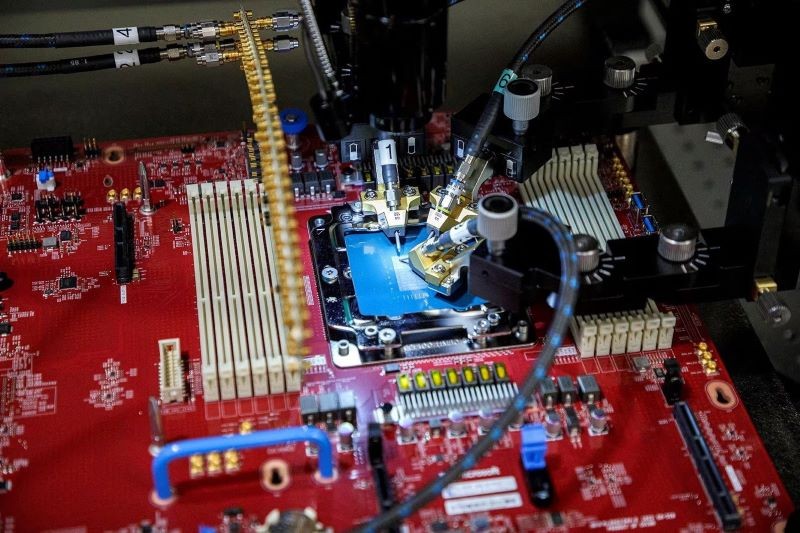

Der Maia-Chip wurde von Microsoft für die Ausführung großer Sprachmodelle (LLMs) entwickelt, der Grundlage für den Azure OpenAI-Dienst, einer Zusammenarbeit zwischen Microsoft und dem Unternehmen, dem ChatGPT gehört.

Microsoft kündigte außerdem an, Azure-Kunden im nächsten Jahr Cloud-Dienste anbieten zu können, die auf den neuesten Chips von Nvidia und Advanced Micro Devices (AMD) laufen. Derzeit testet das Unternehmen GPT-4 auf AMD-Chips.

Inzwischen wurde der zweite Chip mit dem Codenamen Cobalt von Microsoft auf den Markt gebracht, um interne Kosten zu sparen und mit dem AWS-Cloud-Dienst von Amazon zu konkurrieren, der seinen eigenen, selbst entwickelten Chip „Graviton“ verwendet.

Cobalt ist eine Arm-basierte Zentraleinheit (CPU), die derzeit für den Betrieb der Enterprise-Messaging-Software Teams getestet wird.

AWS sagt, dass sein Graviton-Chip derzeit etwa 50.000 Kunden hat und das Unternehmen später in diesem Monat eine Entwicklerkonferenz veranstalten wird.

Rani Borkar, Corporate Vice President für Azure-Hardware und -Infrastruktur, sagte, beide neuen KI-Chips würden im 5-nm-Prozess von TSMC hergestellt.

Der Maia-Chip ist mit Standard-Ethernet-Kabeln gekoppelt, anstatt die teurere kundenspezifische Nvidia-Netzwerktechnologie zu verwenden, die Microsoft in den für OpenAI gebauten Supercomputern verwendet hat.

[Anzeige_2]

Quelle

Kommentar (0)