Das komplexe Bild des Einsatzes von KI-gesteuerten Killerrobotern.

Die Steuerung von Waffensystemen durch KI könnte bedeuten, dass Ziele ohne menschliches Eingreifen identifiziert, angegriffen und zerstört werden. Dies wirft ernsthafte rechtliche und ethische Fragen auf.

Der österreichische Außenminister Alexander Schallenberg unterstrich die Ernsthaftigkeit der Lage mit den Worten: „Dies ist der Oppenheimer-Moment unserer Generation.“

Roboter und Waffensysteme mit künstlicher Intelligenz finden in den Streitkräften vieler Länder zunehmend breite Anwendung. Foto: Forbes

In der Tat ist die Frage, inwieweit der „Geist aus dem Glas entkommen ist“, angesichts des weit verbreiteten Einsatzes von Drohnen und künstlicher Intelligenz (KI) durch das Militär auf der ganzen Welt zu einer drängenden Frage geworden.

Der Verteidigungsanalyst Wilson Jones von GlobalData erklärte: „Der Einsatz von Drohnen durch Russland und die Ukraine in modernen Konflikten, der Einsatz von Drohnen durch die USA bei gezielten Angriffsoperationen in Afghanistan und Pakistan sowie, wie erst letzten Monat bekannt wurde, im Rahmen des israelischen Lavender-Programms, zeigen, wie die Informationsverarbeitungsfähigkeiten der KI aktiv von den Streitkräften der Welt genutzt werden, um ihre Offensivkraft zu steigern.“

Untersuchungen des in London ansässigen Office of War Investigations ergaben, dass das KI-System „Lavender“ des israelischen Militärs in 90 % der Fälle Personen mit Verbindungen zur Hamas korrekt identifizierte; 10 % wurden also nicht erkannt. Dies führte aufgrund der Identifizierungs- und Entscheidungsfähigkeiten der KI zu zivilen Opfern.

Eine Bedrohung für die globale Sicherheit.

Der Einsatz von KI in dieser Weise unterstreicht die Notwendigkeit eines Technologiemanagements in Waffensystemen.

Dr. Alexander Blanchard, leitender Wissenschaftler im Programm für die Steuerung künstlicher Intelligenz am Stockholmer Internationalen Friedensforschungsinstitut (SIPRI), einer unabhängigen Forschungsgruppe mit Schwerpunkt auf globaler Sicherheit, erklärte gegenüber Army Technology: „Der Einsatz von KI in Waffensystemen, insbesondere bei der Zielerfassung, wirft grundlegende Fragen darüber auf, wer wir – Menschen – sind und wie unser Verhältnis zum Krieg aussieht, und insbesondere über unsere Annahmen darüber, wie wir Gewalt in bewaffneten Konflikten einsetzen könnten.“

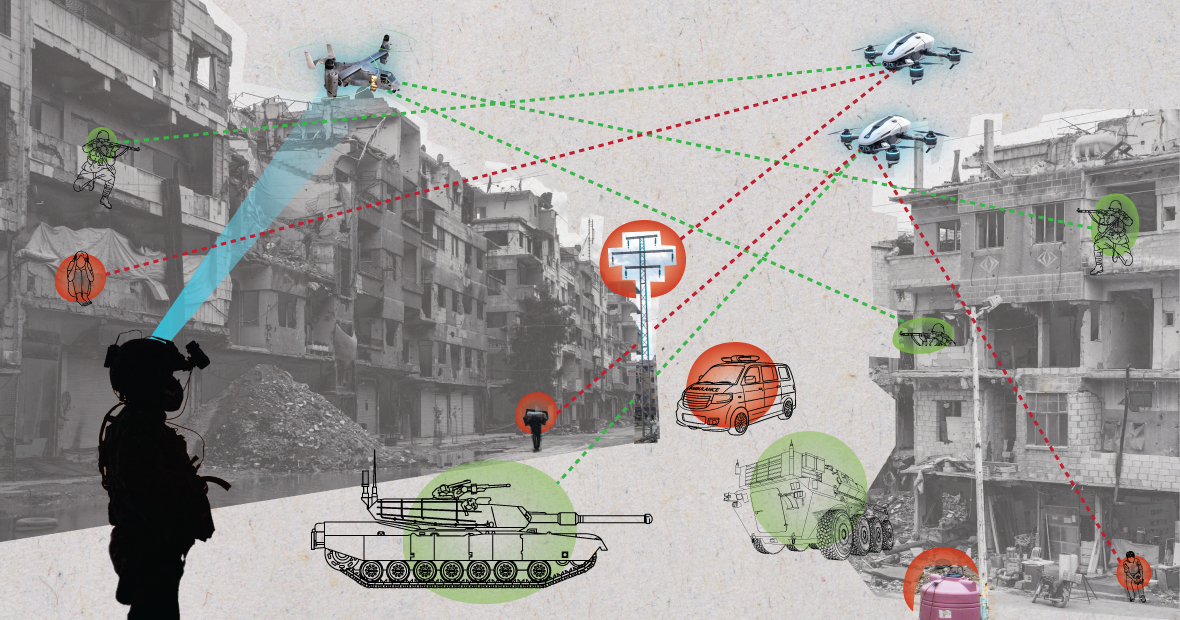

In chaotischen Umgebungen können KI-Systeme unvorhersehbar agieren und Ziele möglicherweise nicht präzise identifizieren. (Bild: MES)

„Wird KI die Art und Weise verändern, wie Militärs Ziele auswählen und Gewalt anwenden? Diese Veränderungen werfen wiederum eine Reihe rechtlicher, ethischer und operativer Fragen auf. Die größte Sorge ist humanitärer Natur“, fügte Dr. Blanchard hinzu.

Der SIPRI-Experte erklärte: „Viele Menschen befürchten, dass automatisierte Systeme, je nach ihrer Gestaltung und Anwendung, Zivilisten und andere durch internationales Recht geschützte Personen einem größeren Schadensrisiko aussetzen könnten. Dies liegt daran, dass KI-Systeme, insbesondere in chaotischen Umgebungen, unvorhersehbar agieren und Ziele möglicherweise nicht präzise identifizieren und Zivilisten angreifen oder Kämpfer außerhalb der Schusslinie nicht erkennen können.“

Der Verteidigungsanalyst Wilson Jones von GlobalData geht näher auf dieses Thema ein und merkt an, dass die Frage, wie Schuld definiert wird, in Frage gestellt werden könnte.

„Nach geltendem Kriegsrecht gibt es das Prinzip der Befehlsverantwortung“, sagte Jones. „Das bedeutet, dass ein Offizier, General oder anderer Vorgesetzter rechtlich für die Handlungen der ihm unterstellten Truppen verantwortlich ist. Begehen die Truppen Kriegsverbrechen, wird der Offizier zur Rechenschaft gezogen, selbst wenn er den Befehl nicht erteilt hat; die Beweislast liegt bei ihm; er muss nachweisen, dass er alles Mögliche getan hat, um die Kriegsverbrechen zu verhindern.“

„Bei KI-Systemen wird die Sache komplizierter. Ist ein IT-Techniker verantwortlich? Ein Systementwickler? Das ist unklar. Und wenn es unklar ist, entsteht ein moralisches Risiko, wenn Akteure glauben, ihre Handlungen seien nicht durch geltende Gesetze geschützt“, betonte Jones.

Ein US-Soldat patrouilliert mit einem Roboterhund. Foto: Forbes

Rüstungskontrollübereinkommen: Mehrere wichtige internationale Abkommen beschränken und regeln den Einsatz bestimmter Waffen. Dazu gehören das Chemiewaffenverbot, die Atomwaffensperrverträge und das Übereinkommen über bestimmte konventionelle Waffen, welche den Einsatz bestimmter Waffen verbieten oder einschränken, wenn diese als Ursache für unnötiges oder ungerechtfertigtes Leid von Kombattanten oder für wahllos auftretende Schäden an der Zivilbevölkerung angesehen werden.

„Die nukleare Rüstungskontrolle erfordert jahrzehntelange internationale Zusammenarbeit und entsprechende Verträge, um durchsetzbar zu sein“, erklärt der Verteidigungsanalyst Wilson Jones. „Selbst dann führten wir bis in die 1990er-Jahre hinein Atomtests in der Atmosphäre durch. Ein wesentlicher Grund für den Erfolg der nuklearen Nichtverbreitung war die Zusammenarbeit zwischen den Vereinigten Staaten und der Sowjetunion in der bipolaren Weltordnung. Diese existiert nicht mehr, und KI-Technologie ist für mehr Länder zugänglich als Atomenergie.“

„Ein verbindlicher Vertrag müsste alle beteiligten Parteien an einen Tisch bringen, damit sie sich darauf einigen, kein Instrument einzusetzen, das ihre militärische Macht stärkt. Das dürfte kaum effektiv sein, da KI die militärische Effektivität mit minimalem finanziellen und materiellen Aufwand verbessern kann.“

Aktuelle geopolitische Perspektive

Obwohl die Staaten der Vereinten Nationen die Notwendigkeit eines verantwortungsvollen Einsatzes von KI durch das Militär anerkannt haben, bleibt noch viel zu tun.

Laura Petrone, leitende Analystin bei GlobalData, sagte gegenüber Army Technology: „Aufgrund des Fehlens eines klaren Steuerungsrahmens bleiben diese Aussagen größtenteils ambitioniert. Es ist nicht verwunderlich, dass einige Länder ihre Souveränität bei Entscheidungen über die innere Verteidigung und die nationale Sicherheit wahren wollen, insbesondere im Kontext der aktuellen geopolitischen Spannungen.“

Frau Petrone fügte hinzu, dass der EU-AI-Act zwar einige Anforderungen an KI-Systeme festlegt, sich aber nicht mit KI-Systemen für militärische Zwecke befasst.

„Ich denke, dass das KI-Gesetz trotz dieses Ausschlusses ein wichtiger Schritt zur Schaffung eines längst überfälligen Rahmens für KI-Anwendungen ist, der künftig zu einer gewissen Harmonisierung relevanter Standards führen könnte“, kommentierte sie. „Diese Harmonisierung wird auch für KI im militärischen Bereich von entscheidender Bedeutung sein.“

Nguyen Khanh

Quelle: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

Kommentar (0)