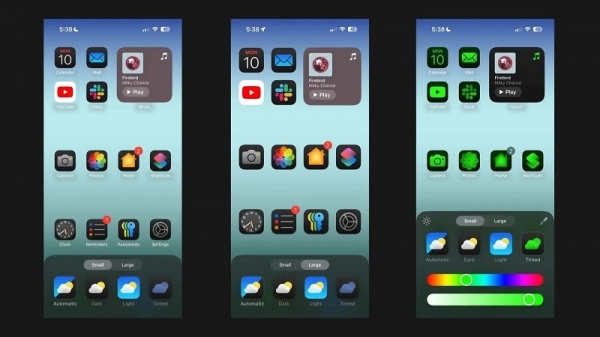

Según Android Authority , el artículo de investigación de Apple detalla una solución para ejecutar modelos de lenguaje grandes (LLM) en dispositivos con RAM limitada. El artículo revela cómo la compañía puede almacenar "parámetros del modelo" y cargar una parte de ellos en la RAM del dispositivo cuando sea necesario, en lugar de cargar el modelo completo en la RAM.

Apple busca ayudar a los iPhones más antiguos con menos RAM a ejecutar IA general

El documento afirma que este método permite ejecutar modelos que requieren el doble de RAM que un iPhone y al mismo tiempo garantizar velocidades de inferencia de 4-5x y de 20-25x en comparación con los métodos de carga simples en la CPU y la GPU respectivamente.

Implementar IA sintética en un dispositivo con más RAM sería una gran ventaja, ya que permitiría velocidades de lectura y escritura más rápidas. La velocidad es importante para la IA integrada en el dispositivo, ya que permite tiempos de inferencia mucho más rápidos, ya que los usuarios no necesariamente tienen que esperar decenas de segundos (o más) para obtener una respuesta o un resultado final. Todo esto significa que un asistente de IA integrado en el dispositivo podría potencialmente funcionar a velocidades de conversación, generar imágenes y texto mucho más rápido, resumir artículos con mayor rapidez, etc. Sin embargo, la solución de Apple implica que los usuarios no necesitan necesariamente mucha RAM para acelerar la capacidad de respuesta de la IA integrada en el dispositivo.

El enfoque de Apple podría permitir que los iPhones, tanto antiguos como nuevos, ofrezcan funciones de IA sintética directamente en sus dispositivos. Esto es importante porque los iPhones de Apple suelen ofrecer menos RAM que los teléfonos Android de gama alta. La serie iPhone 11, por ejemplo, solo ofrece 4 GB de RAM, mientras que incluso el iPhone 15 estándar tiene solo 6 GB.

Apple no es la única compañía de telefonía móvil que trabaja en la reducción de LLM. Los chips insignia recientes de Qualcomm y MediaTek admiten la precisión INT4 para reducir estos modelos. En cualquier caso, las compañías buscan nuevas maneras de reducir los requisitos del sistema para la IA en el dispositivo, permitiendo que incluso los teléfonos de gama baja ofrezcan esta función.

[anuncio_2]

Enlace de origen

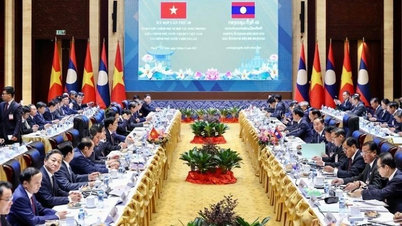

![[Foto] Desfile para celebrar el 50 aniversario del Día Nacional de Laos](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

Kommentar (0)