(دن تری) - حجم دادههای مورد استفاده برای آموزش هوش مصنوعی تقریباً به پایان رسیده است و محققان را مجبور میکند از هوش مصنوعی برای آموزش یکدیگر استفاده کنند. این میتواند یک پیشرفت بزرگ برای کمک به هوش مصنوعی در پیشی گرفتن از هوش انسانی باشد.

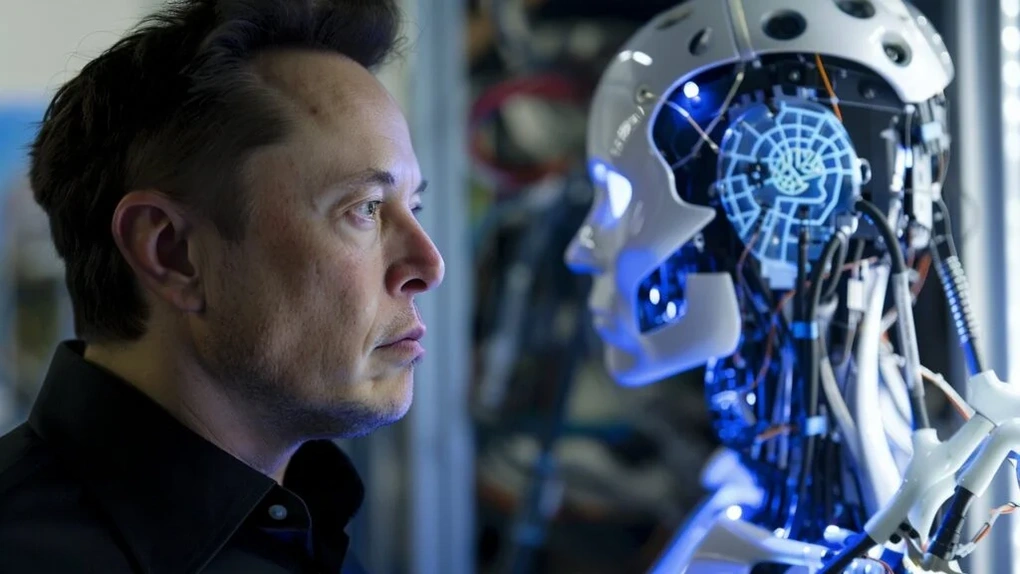

ایلان ماسک میگوید روشهای جدید توسعه هوش مصنوعی میتواند خطرناک باشد

ایلان ماسک، میلیاردر حوزه فناوری و بنیانگذار شرکت هوش مصنوعی xAI، به تازگی اطلاعات تکان دهندهای در مورد فرآیند آموزش و تربیت مدلهای هوش مصنوعی (AI) منتشر کرده است.

ایلان ماسک در مصاحبهای که به صورت زنده در شبکه اجتماعی X در تاریخ ۹ ژانویه پخش شد، گفت: «ما اکنون از میزان دانش انسانی در آموزش و پرورش هوش مصنوعی استفاده کردهایم. این اتفاق اساساً از سال گذشته رخ داده است.»

مدلهای هوش مصنوعی مانند GPT-4، Gemini، Grok یا Llama... بر اساس حجم زیادی از دادههای جمعآوریشده از اینترنت، مجلات علمی ، تحقیقات منتشرشده، دادههای کاربران در شبکههای اجتماعی و... آموزش داده میشوند.

ایلان ماسک پیشنهاد استفاده از دادههای هوش مصنوعی برای آموزش هوش مصنوعی را میدهد، اما این کار خطرات بالقوه زیادی دارد (تصویر: گتی).

با این حال، سرعت توسعه مدلهای هوش مصنوعی به قدری زیاد است که میزان دادههای موجود دیگر برای آموزش و افزایش هوش این مدلهای هوش مصنوعی کافی نیست.

برای غلبه بر این مشکل، ایلان ماسک راه حلی پیشنهاد داده است، و آن استفاده از دادههای تولید شده توسط خود هوش مصنوعی برای آموزش مدلهای هوش مصنوعی است. به عبارت دیگر، هوش مصنوعی میتواند بدون تکیه بر دادههای ارائه شده توسط انسانها، خود و یکدیگر را آموزش دهد.

ایلان ماسک در این باره گفت: «تنها راه حل این مشکل، تکمیل دادههای مصنوعی تولید شده توسط خود مدلهای هوش مصنوعی و استفاده از این دادهها برای آموزش خود هوش مصنوعی است.»

سیستمهای هوش مصنوعی که خود را بر اساس دادههای مصنوعی تولید شده توسط خود هوش مصنوعی آموزش میدهند، به صرفهجویی در هزینههای توسعه و کاهش وابستگی به دادههای انسانی کمک میکنند. این موضوع باعث نگرانی بسیاری از مردم میشود که هوش مصنوعی میتواند خود را طوری آموزش دهد که از هوش انسانی فراتر رود، و فراتر از کنترل بشریت باشد.

با این حال، متخصصان هوش مصنوعی میگویند استفاده از دادههای مصنوعی تولید شده توسط خود هوش مصنوعی برای آموزش مدلهای هوش مصنوعی میتواند باعث فروپاشی این مدلها شود، زمانی که دادههای تولید شده فاقد خلاقیت باشند، جانبدارانه باشند و با جدیدترین دادهها بهروزرسانی نشوند.

اندرو دانکن، مدیر هوش مصنوعی در موسسه آلن تورینگ در بریتانیا، گفت: «وقتی از دادههای مصنوعی برای آموزش مدلهای هوش مصنوعی استفاده میکنید، عملکرد آنها به تدریج کاهش مییابد و دادههای خروجی بیروح و جانبدارانه خواهند بود.»

دادههای با کیفیت بالا به عنوان یک «معدن منبع» ارزشمند در نظر گرفته میشوند که شرکتهای توسعه هوش مصنوعی برای آن رقابت میکنند. با این حال، همه دانشمندان مایل به ارائه تحقیقات خود برای آموزش مدلهای هوش مصنوعی نیستند.

گوگل توانسته هوش مصنوعیای بسازد که دقیقاً مانند انسان فکر و عمل میکند.

تصور کنید وسیلهای برای تعیین شخصیت، نگرشها و سبک زندگی یک فرد دارید و سپس میتوانید یک کپی هوش مصنوعی از آن شخص بسازید.

این یک داستان علمی تخیلی نیست، بلکه هدف اصلی یک مطالعهی پیشگامانه توسط محققان دانشگاه استنفورد و گوگل است.

تنها با ۲ ساعت مصاحبه، گوگل میتواند یک هوش مصنوعی بسازد که دقیقاً مانند شما فکر و عمل کند (عکس: ZipRecruiter).

محققان با استفاده از اطلاعات مصاحبههایی که تنها دو ساعت طول کشید، یک کپی هوش مصنوعی از بیش از ۱۰۰۰ شرکتکننده ایجاد کردند. این هوشهای مصنوعی میتوانند رفتار انسان را تقلید کنند.

کاربردهای بالقوه این اختراع بسیار زیاد است. سیاستگذاران و کسبوکارها میتوانند از این شبیهسازی هوش مصنوعی برای پیشبینی واکنشهای عمومی به سیاستها یا محصولات جدید استفاده کنند، به جای اینکه صرفاً به گروههای کانونی یا نظرسنجیهای تکراری تکیه کنند.

محققان معتقدند که این فناوری میتواند به بررسی ساختارهای اجتماعی، مداخلات آزمایشی و توسعه نظریههای ظریف رفتار انسان کمک کند.

با این حال، این فناوری خطراتی نیز دارد، مانند نگرانیهای اخلاقی در مورد سوءاستفاده از کلونهای هوش مصنوعی. بازیگران مخرب میتوانند از این هوش مصنوعی برای دستکاری افکار عمومی، جعل هویت افراد یا شبیهسازی ترجیحات عمومی بر اساس دادههای مصنوعی جعلی سوءاستفاده کنند.

این نگرانیها همچنین ذیل نگرانی دیرینهای قرار میگیرند که تکثیر مدلهای هوش مصنوعی مشابه میتواند پیامدهای منفی برای آینده بشریت داشته باشد.

منبع: https://dantri.com.vn/suc-manh-so/ai-sap-dat-duoc-buoc-dot-pha-moi-co-the-vuot-qua-tri-tue-con-nguoi-20250111132229246.htm

![[عکس] نخست وزیر فام مین چین ریاست اولین جلسه کمیته مرکزی راهبری سیاست مسکن و بازار املاک و مستغلات را بر عهده دارد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/22/c0f42b88c6284975b4bcfcf5b17656e7)

![[عکس] دبیرکل، تو لام، مدال درجه یک کارگری را به گروه ملی انرژی و صنعت ویتنام اهدا میکند](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/21/0ad2d50e1c274a55a3736500c5f262e5)

نظر (0)