|

Wielu kandydatów stwierdziło, że test z matematyki był długi i trudny do rozwiązania w 90 minut. Nie stanowi to jednak przeszkody dla AI. Zdjęcie: Duy Hieu . |

Po południu 26 czerwca kandydaci przystąpili do 90-minutowego testu z matematyki w ramach egzaminu maturalnego w 2025 roku. Był to pierwszy test po wprowadzeniu przez Ministerstwo Edukacji i Szkolenia nowego formatu, który podobno jest trudniejszy niż w latach ubiegłych.

Chociaż tegoroczne zadania matematyczne mogą być trudne dla kandydatów ze względu na swoją długość i czasochłonność, przetwarzanie ich przez chatboty oparte na sztucznej inteligencji nie zajmuje dużo czasu. Aby przetestować skuteczność sztucznej inteligencji, Tri Thuc - Znews wykorzystał 4 chatboty, w tym ChatGPT, Google Gemini, Claude AI i Grok AI, do rozwiązania kilku pytań esejowych z tegorocznego egzaminu maturalnego.

Szybkie przetwarzanie, wyniki „trafione lub chybione”

Chatboty zostały użyte do odpowiedzi na krótkie pytania kodu testowego 0109. Spośród nich ChatGPT i Gemini udzieliły najwięcej poprawnych odpowiedzi z najmniejszym opóźnieniem. Oba chatboty odpowiedziały na 6 pytań w czasie 7-15 sekund na każde. Gemini był jednak w stanie rozwiązać powyższe problemy dzięki modelowi Flash 2.5 (bez wnioskowania), co pozwala na szybkie i kompleksowe przetwarzanie.

Tymczasem Claude całkowicie zawiódł w swoich obliczeniach, ciągle podając błędne wyniki. Pomimo prośby o ponowne obliczenie, chatbot Anthropica nadal udzielał tej samej odpowiedzi. Grok odpowiedział poprawnie na około połowę pytań, ale z długim czasem reakcji (ponad 2 minuty na każde pytanie).

W przypadku ChatGPT i Grok rozwiązanie tych pytań wymaga wersji wnioskowania, która zajmuje znacznie więcej czasu. Gemini jest bardzo szybki, rozwiązanie najszybszego pytania zajmuje około 5 sekund i korzysta tylko z modelu Flash 2.5.

|

ChatGPT bardzo obrazowo prezentuje proces myślowy. |

Pod względem szybkości, Gemini miał najszybszy czas przetwarzania, średnio poniżej 10 sekund na problem, ale oferował bardziej złożone, rozwlekłe i trudne do zrozumienia rozwiązania. Następny był model wnioskowania ChatGPT, którego średni czas przetwarzania wyniósł 25 sekund. Tymczasem, mimo że Grok nadal otrzymywał poprawne wyniki, rozumowanie zajęło mu dużo czasu – 148 sekund w przypadku pytania o średnim stopniu trudności.

Chociaż pytania zadawano po wietnamsku, wszystkie trzy modele przedstawiły swój proces rozumowania po angielsku. ChatGPT przedstawił najkrótszy opis, z wieloma ilustracjami, wykresami i łatwą do zrozumienia analizą. Gemini również wyjaśnił i przedstawił tok rozumowania modelu w odpowiedniej kolejności.

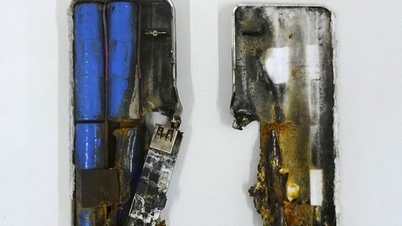

W szczególności Grok charakteryzuje się najbardziej ludzkim procesem myślowym. Model nieustannie zadaje sobie pytanie: „ale, czekaj, wręcz przeciwnie”, podobnie jak uczeń rozwiązujący zadanie matematyczne. Może to powodować, że chatbot będzie się nadmiernie rozwodził nad problemem i wydłuży czas reakcji.

|

Grokowi zajęło 148 sekund przedstawienie wyników. |

Sztuczna inteligencja rozwiązuje zadania matematyczne inaczej niż ludzie

Badanie przeprowadzone przez Apple wykazało, że modele wnioskowania w rzeczywistości nie wykorzystują mózgu, lecz uczą się na pamięć z istniejących danych. Badanie sugeruje również, że sztuczna inteligencja ma zupełnie inny proces myślowy niż ludzie, dlatego stara się naśladować nasz sposób rozwiązywania problemu. Możliwe jednak, że proces rozumowania jest po prostu wymyślony przez model.

W kontekście coraz trudniejszego egzaminu maturalnego, wymagającego wysokiego poziomu analitycznego, wykorzystanie sztucznej inteligencji do celów referencyjnych i nauki nie jest już obce uczniom. Spośród wymienionych chatbotów, ChatGPT i Gemini to dwie odpowiednie opcje dla osób uczących się samodzielnie, które mogą korzystać z rozwiązań trudnych problemów.

|

Uczniowie Hanoi na egzaminie maturalnym w 2025 roku. Zdjęcie: Viet Ha . |

Jednak, chociaż sztuczna inteligencja generuje wyniki szybko i łatwo, jej proces rozumowania nie jest jeszcze w pełni zrozumiały dla programistów. W środowisku akademickim kluczowa pozostaje zdolność ludzkiego myślenia. Pan Tuan Nguyen, wykładowca na międzynarodowym uniwersytecie w Ho Chi Minh, powiedział, że korzystanie ze sztucznej inteligencji jest normalne, ale studenci muszą zrozumieć lekcję, ćwiczyć krytyczne myślenie i opanować inteligentne narzędzia, aby uczyć się efektywniej.

Pan Tran Manh Tung, kierownik Wydziału Matematyki w Newton Secondary School, skomentował, że format egzaminu był podobny do przykładowego egzaminu opublikowanego wcześniej przez Ministerstwo Edukacji i Szkolenia. „Jednak, jeśli spojrzeć na to z szerszej perspektywy, prawdziwy egzamin był trudniejszy i bardziej zróżnicowany niż egzamin próbny” – skomentował.

Tegoroczny egzamin składa się z trzech części odpowiadających trzem cyfrom rzymskim. Pierwsze dwie części to pytania wielokrotnego wyboru, które nie są zbyt trudne dla kandydatów, aby łatwo zdobyć punkty, powiedział pan Tung. Pozostałe części to krótkie pytania, podobne do formatu eseju sprzed wielu lat, z tą różnicą, że kandydaci muszą jedynie wpisać wyniki i nie muszą ich prezentować.

Source: https://znews.vn/ai-chi-mat-10-giay-de-giai-bai-toan-thi-tot-nghiep-thpt-post1563990.html

![[Zdjęcie] Przewodniczący Zgromadzenia Narodowego Tran Thanh Man uczestniczy w ceremonii wręczenia nagród VinFuture 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

![[Zdjęcie] 60. rocznica powstania Wietnamskiego Stowarzyszenia Artystów Fotografików](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

Komentarz (0)