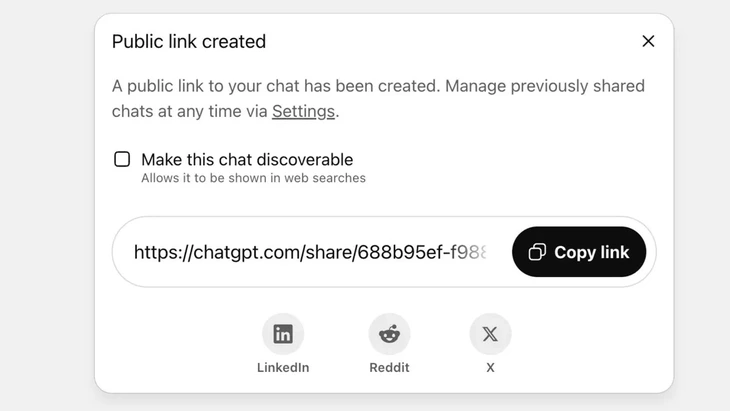

Funkcja udostępniania czatów za pośrednictwem łącza publicznego w ChatGPT – Zdjęcie: Techradar

Obecnie ChatGPT otrzymuje ponad 2,5 miliarda zapytań od użytkowników z całego świata każdego dnia, co pokazuje rosnącą popularność tego chatbota.

Narzędzie to spotyka się jednak z silną krytyką ze strony użytkowników, gdyż funkcja „udostępniania” spowodowała wyciek poufnych informacji z tysięcy konwersacji do Google i niektórych wyszukiwarek w Internecie.

Wysokie ryzyko bezpieczeństwa

Pan Vu Ngoc Son – szef działu technologii w National Cyber Security Association (NCA) – ocenił, że powyższy incydent świadczy o wysokim poziomie zagrożenia bezpieczeństwa dla użytkowników ChatGPT.

„Powyższy incydent niekoniecznie oznacza wadę techniczną, ponieważ kliknięcie przycisku udostępniania jest inicjatywą użytkownika. Można jednak stwierdzić, że problem leży w konstrukcji chatbota opartego na sztucznej inteligencji, który wprowadza użytkowników w błąd i nie zapewnia wystarczająco silnych środków ostrzegawczych przed ryzykiem wycieku danych osobowych w przypadku udostępnienia treści przez użytkowników” – analizuje Vu Ngoc Son.

W ChatGPT funkcja ta jest wdrażana po tym, jak użytkownik zdecyduje się udostępnić czat za pomocą publicznego łącza. Zawartość czatu zostanie zapisana na serwerze OpenAI w formie publicznej witryny internetowej (chatgpt.com/share/...). Aby uzyskać dostęp, nie jest wymagane logowanie ani hasło.

Roboty Google automatycznie skanują i indeksują te strony, dzięki czemu pojawiają się one w wynikach wyszukiwania wraz z poufnymi tekstami, obrazami i danymi czatów.

Wielu użytkowników nie zdawało sobie sprawy z zagrożenia, myśląc, że udostępnia czat znajomym lub kontaktom. Doprowadziło to do ujawnienia tysięcy rozmów, w niektórych przypadkach zawierających poufne dane osobowe.

Chociaż OpenAI szybko usunął tę funkcję pod koniec lipca 2025 roku po fali krytyki ze strony społeczności, koordynacja działań z Google w celu usunięcia starych indeksów zajęła trochę czasu. Zwłaszcza w przypadku złożonego systemu przechowywania danych, który obejmuje serwery pamięci podręcznej Google, nie jest to możliwe.

Nie traktuj chatbotów AI jako „czarnej skrzynki bezpieczeństwa”

Ekspert ds. bezpieczeństwa danych Vu Ngoc Son – szef działu technologii w National Cyber Security Association (NCA) – zdjęcie: CHI HIEU

Wyciek tysięcy logów czatów może narazić użytkowników na ryzyko, np. ujawnienie tajemnic osobistych i biznesowych, utratę reputacji, ryzyko finansowe, a nawet zagrożenie bezpieczeństwa w związku z ujawnieniem adresów domowych.

„Czatboty oparte na sztucznej inteligencji są przydatne, ale nie są „czarną skrzynką”, ponieważ udostępniane dane mogą pozostać w sieci na zawsze, jeśli nie zostaną sprawdzone.

Powyższy incydent jest z pewnością lekcją zarówno dla dostawców, jak i użytkowników. Inni dostawcy usług AI mogą wyciągnąć wnioski z tego doświadczenia i zaprojektować funkcje z jaśniejszymi i bardziej przejrzystymi ostrzeżeniami.

Jednocześnie użytkownicy muszą proaktywnie ograniczać niekontrolowane publikowanie danych identyfikacyjnych lub osobowych na platformach AI — zaleca ekspert ds. bezpieczeństwa Vu Ngoc Son.

Według ekspertów ds. bezpieczeństwa danych, powyższy incydent wskazuje na potrzebę wprowadzenia prawnych korytarzy i standardów cyberbezpieczeństwa dla sztucznej inteligencji. Dostawcy i deweloperzy rozwiązań AI muszą również projektować systemy zapewniające bezpieczeństwo, unikając ryzyka wycieku danych, takiego jak: wyciek poprzez luki w zabezpieczeniach; luki w oprogramowaniu prowadzące do ataków na bazy danych; słaba kontrola prowadząca do zatruwania danych, nadużyć w celu udzielania odpowiedzi na fałszywe i zniekształcone pytania.

Użytkownicy muszą również kontrolować udostępnianie danych osobowych sztucznej inteligencji, a nie udostępnianie informacji poufnych. W razie realnej potrzeby zaleca się korzystanie z trybu anonimowego lub aktywne szyfrowanie informacji, aby uniknąć bezpośredniego powiązania danych z konkretnymi osobami.

Source: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Zdjęcie] „Cmentarzysko statków” w zatoce Xuan Dai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Wideo] Pomniki w Hue ponownie otwarte dla zwiedzających](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Komentarz (0)