Grupa wybitnych międzynarodowych ekspertów spotkała się w zeszłym tygodniu w Pekinie, gdzie zidentyfikowali „czerwone linie” w rozwoju sztucznej inteligencji, w tym tworzenie broni biologicznej i przeprowadzanie cyberataków.

W oświadczeniu wydanym kilka dni po spotkaniu naukowcy ostrzegli, że konieczne jest wspólne podejście do bezpieczeństwa sztucznej inteligencji, aby zapobiec „katastrofalnym, a nawet egzystencjalnym zagrożeniom dla ludzkości za naszego życia”.

„W szczytowym okresie zimnej wojny współpraca rządów międzynarodowych i naukowych pomogła zapobiec katastrofie nuklearnej. Ludzkość musi ponownie połączyć siły, aby zapobiec katastrofie, która mogłaby wyniknąć z bezprecedensowej technologii” – czytamy w oświadczeniu.

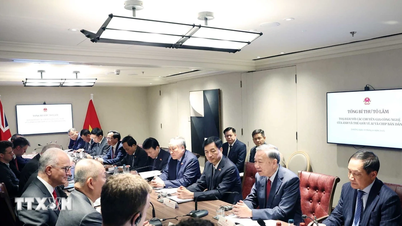

Eksperci Międzynarodowego Dialogu na temat Bezpieczeństwa AI w Pekinie zidentyfikowali „czerwone linie” w rozwoju AI. Zdjęcie: FT

Wśród sygnatariuszy listu znaleźli się Geoffrey Hinton i Yoshua Bengio, często nazywani „ojcami” sztucznej inteligencji; Stuart Russell, profesor informatyki na Uniwersytecie Kalifornijskim; oraz Andrew Yao, jeden z najwybitniejszych chińskich informatyków.

Oświadczenie wydano po zakończeniu Międzynarodowego Dialogu na temat Bezpieczeństwa Sztucznej Inteligencji, który odbył się w Pekinie w ubiegłym tygodniu. W spotkaniu wzięli udział chińscy urzędnicy państwowi, którzy wyrazili swoje poparcie dla forum i jego wyników.

Prezydent USA Joe Biden i prezydent Chin Xi Jinping spotkali się w listopadzie ubiegłego roku i omówili kwestię bezpieczeństwa sztucznej inteligencji, zgadzając się na rozpoczęcie dialogu w tej sprawie. Wiodące globalne firmy zajmujące się sztuczną inteligencją spotkały się również w ostatnich miesiącach prywatnie z chińskimi ekspertami w tej dziedzinie.

W listopadzie 2023 r. podczas szczytu poświęconego bezpieczeństwu sztucznej inteligencji, zorganizowanego przez kanclerza Wielkiej Brytanii Rishiego Sunaka, 28 krajów, w tym Chiny, oraz wiodące firmy z branży sztucznej inteligencji zgodziły się na szerokie zobowiązanie do współpracy w celu rozwiązania egzystencjalnych zagrożeń wynikających z zaawansowanej sztucznej inteligencji.

W ubiegłym tygodniu w Pekinie eksperci dyskutowali na temat zagrożeń związanych z rozwojem „sztucznej inteligencji ogólnej – AGI”, czyli systemów AI równych ludziom lub przewyższających ich.

„Głównym tematem dyskusji były granice, których żaden potężny system sztucznej inteligencji nie powinien przekraczać i które rządy na całym świecie powinny narzucić w procesie rozwoju i wdrażania sztucznej inteligencji” – powiedział Bengio.

Te czerwone linie mają zapewnić, że „żaden system sztucznej inteligencji nie będzie mógł się replikować ani udoskonalać bez wyraźnej zgody i wsparcia człowieka” lub „podejmować działań, które w nieuprawniony sposób zwiększają jego moc i wpływy”.

Naukowcy dodali, że żaden system nie „znacznie zwiększy możliwości podmiotów w zakresie projektowania broni masowego rażenia, naruszania konwencji o broni biologicznej lub chemicznej” ani nie będzie w stanie „automatycznie przeprowadzać ataków cybernetycznych powodujących poważne straty finansowe lub równoważne szkody”.

Hoang Hai (według FT)

Źródło

![[Zdjęcie] Wycinanie wzgórz, aby umożliwić ludziom poruszanie się drogą 14E, która ucierpiała wskutek osuwisk](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[Wideo] Pomniki w Hue ponownie otwarte dla zwiedzających](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Komentarz (0)