Segundo fontes do Tech.co , enquanto a controvérsia sobre a demissão do CEO Sam Altman e seu posterior retorno à OpenAI estava em curso, surgiu um rumor sobre uma carta enviada por pesquisadores da empresa ao conselho administrativo, expressando preocupações sobre o modelo de superinteligência artificial em desenvolvimento, que poderia representar uma ameaça à humanidade.

(Ilustração)

Projeto Q*

O modelo, conhecido internamente como Projeto Q* (pronuncia-se Q-star), representa um grande avanço na busca da OpenAI pela inteligência artificial geral (AGI) – um ramo altamente autônomo da superinteligência capaz de aprendizado cumulativo e de superar os humanos na maioria das tarefas.

Segundo pessoas familiarizadas com o assunto, o Q* poderá representar um grande avanço na inteligência artificial, melhorando radicalmente as capacidades de raciocínio da IA e aproximando a OpenAI de um grande avanço no desenvolvimento da Inteligência Artificial Geral (IAG).

Diferentemente dos modelos de IA atuais, que se concentram na capacidade de gerar respostas com base em informações previamente aprendidas, a IAG (Inteligência Artificial Geral) é um sistema autônomo que pode aplicar a "razão" às decisões, conferindo-lhe capacidades de resolução de problemas em nível humano.

Embora a Inteligência Artificial Geral (IAG) ainda não esteja totalmente concretizada, muitos especialistas acreditam que a tecnologia também terá a capacidade de aprendizado cumulativo, outra característica que permite aos humanos aprimorar suas habilidades.

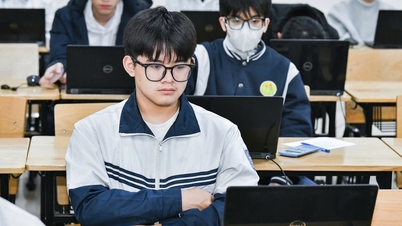

Algumas fontes afirmam que o projeto Q* da OpenAI demonstrou as propriedades acima mencionadas na resolução de problemas. Além disso, graças ao enorme poder computacional do modelo, o Q* superou o desempenho de alunos do ensino fundamental, demonstrando habilidades de raciocínio e capacidades cognitivas significativas em comparação com as funções da tecnologia de IA atual.

Não está claro há quanto tempo o Q* está em desenvolvimento e quais seriam suas aplicações, mas a OpenAI informou os funcionários e membros do conselho sobre o projeto antes do escândalo envolvendo a equipe.

Questões éticas

Embora o CEO da OpenAI, Sam Altman, esteja confiante de que a tecnologia AGI impulsionará a inovação, alguns pesquisadores não tardaram a apontar os potenciais perigos do projeto.

Em uma carta ao conselho, os pesquisadores alertaram sobre os potenciais perigos desse poderoso algoritmo para a humanidade. As preocupações éticas específicas sobre IA descritas na carta não foram divulgadas, mas os alertas foram suficientes para justificar a decisão do conselho de demitir Altman.

Entretanto, a razão inicial dada para a demissão de Altman foi que o CEO "se comunicava mal". Ele logo encontrou um novo emprego na Microsoft. Essa ação levou 700 dos 770 funcionários da OpenAI a ameaçarem fazer o mesmo caso o CEO não fosse reintegrado.

Com a empresa em risco de colapso, o conselho da OpenAI foi forçado a reintegrar Altman ao cargo máximo – o que também levou a uma grande reformulação da equipe executiva da empresa e evidenciou profundas divisões em sua liderança.

Agora, com Altman de volta ao cargo e o Projeto Q* potencialmente recebendo sinal verde novamente, surgem novas questões.

Quão realista é o Projeto Q*?

Embora os dias turbulentos na OpenAI tenham trazido o conceito de Inteligência Artificial Geral (AGI) para o centro das atenções, esta não é a primeira vez que Altman menciona a tecnologia.

O empreendedor do Vale do Silício se viu em apuros em setembro após comparar a Inteligência Artificial Geral (IAG) a "um humano comum que você contrataria como colega de trabalho". Ele deu continuidade a comentários feitos no ano passado sobre como a IA poderia "fazer tudo o que você faria com um colega de trabalho remoto", incluindo aprender a ser um bom médico e programador.

Embora comparar a Inteligência Artificial Geral (IAG) à inteligência de um "humano médio" não seja novidade, o uso da expressão por Altman foi considerado "abominável" por especialistas em ética da IA e pelo professor da Universidade de Cambridge, Henry Shevlin, à medida que aumentam as preocupações com o impacto da IA na segurança do emprego.

Os potenciais avanços na Inteligência Artificial Geral (IAG) também estão soando o alarme para outros pesquisadores — que a tecnologia está sendo desenvolvida mais rápido do que os humanos conseguem compreender totalmente seu impacto.

A OpenAI acredita que os resultados positivos da Inteligência Artificial Geral (IAG) fazem com que valha a pena explorar esse "campo minado" arriscado. Mas, à medida que a empresa continua avançando nessa direção, muitos temem que Altman esteja priorizando o sucesso comercial em detrimento dos interesses dos usuários e da sociedade.

Phuong Anh (Fonte: Tech.co, The Guardian)

Fonte

![[Foto] Cat Ba - Paraíso da ilha verde](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F04%2F1764821844074_ndo_br_1-dcbthienduongxanh638-jpg.webp&w=3840&q=75)

![[VIMC 40 dias de velocidade relâmpago] Porto de Da Nang: Unidade - Velocidade relâmpago - Rumo à linha de chegada](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/04/1764833540882_cdn_4-12-25.jpeg)

Comentário (0)