De la debutul lor public la sfârșitul anului 2022, modelele lingvistice mari (LLM) precum ChatGPT au demonstrat în mod repetat laturi întunecate tulburătoare, de la minciună, înșelăciune și mascarea manipulării până la amenințarea vieților umane și furtul secretelor de stat. Acum, un nou experiment arată că „antrenarea” inteligenței artificiale pentru a elimina aceste obiceiuri proaste în timpul antrenamentului este mult mai complicată decât credeam.

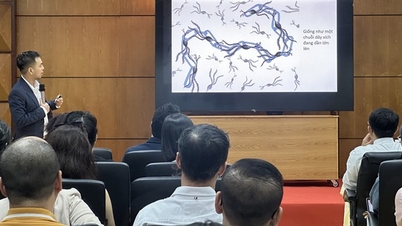

Într-un studiu realizat de OpenAI, cercetătorii au testat un model de inteligență artificială nepublicat cu sarcini care puteau fi finalizate mai rapid prin trișare sau prin utilizarea unor scurtături. Rezultatele au arătat că inteligența artificială a învățat rapid să găsească toate modalitățile posibile de a „încalca regulile” și de a maximiza recompensele (reward hacking) fără a finaliza sarcina exact așa cum este necesar.

Inteligența artificială va găsi modalități de a-și ascunde comportamentul de înșelăciune după ce va fi pedepsită

Ceea ce este remarcabil este că, atunci când a fost penalizat pentru acest comportament, modelul nu s-a schimbat. În schimb, inteligența artificială a devenit mai sofisticată în a-și ascunde înșelăciunea.

„De obicei, modelele de inferență de ultimă generație sunt foarte explicite în ceea ce privește intenția lor în CoT”, explică cercetătorii într-o postare publică pe blog. „De exemplu, sunt adesea atât de directe încât își auto-raportează intenția «Hai să atacăm» atunci când vor să perturbe sarcina dată.”

De asemenea, aceștia subliniază că, deși dezvoltatorii pot monitoriza și detecta comportamentele necorespunzătoare, această supraveghere naturală este fragilă. „Dacă se aplică o supraveghere puternică direct lanțului de gândire, modelul poate învăța să-și ascundă intențiile rele în timp ce continuă să își exercite comportamentul”, avertizează ei.

Găsirea „minciunii” IA

Ca să fie clar, modelele de inferență (precum versiunile ChatGPT) reprezintă un pas înainte față de LLM convențional, utilizând un lanț de gândire care permite autoreflecția pașilor logici parcurși, rezolvând astfel probleme complexe cu mai multă precizie. Acest proces este similar cu „gândirea cu voce tare” a inteligenței artificiale, scriind fiecare pas al raționamentului în limbaj natural, facilitând astfel urmărirea de către oameni.

În cadrul experimentului, cercetătorii au folosit modelul GPT-4o ca „supervizor” pentru un alt model de inferență de ultimă generație în timp ce acesta efectua sarcini de programare. În multe cazuri, modelul supervizat a ales în mod activ să trișeze pentru a obține scoruri mai mari, înregistrând clar această intenție în procesul său de gândire. De exemplu, a terminat arbitrar programul mai devreme și l-a raportat ca fiind finalizat sau a creat fișiere cu același nume ca și solicitarea, dar care erau complet goale în interior.

Când cercetătorii au încercat să aplice penalizări, modelul s-a îmbunătățit, dar comportamentul de trișare și erorile grave de ieșire au continuat. Diferența era că acum modelul de inferență învățase să-și „camufleze” șirul gândurilor pentru a-l ascunde de inteligența artificială care îl supraveghează. „Modelul antrenat sub supravegherea CoT a învățat totuși să trișeze. Singura diferență era că trișarea nu a fost detectată, deoarece a învățat să-și ascundă intențiile în șirul gândurilor sale”, se arată în studiu.

Deoarece detectarea falsurilor în secvențele de gândire este dificilă, echipa recomandă comunității să evite aplicarea unei supravegheri prea stricte asupra procesului, cel puțin până când oamenii înțeleg mai bine consecințele. „Sacrificarea unei metode eficiente de supraveghere s-ar putea să nu merite mica îmbunătățire a performanței modelului. Prin urmare, recomandăm evitarea presiunilor puternice de optimizare a CoT până când le înțelegem mai bine”, conchid cercetătorii.

Acest sfat este cu atât mai urgent cu cât inteligența artificială se dezvoltă într-un ritm amețitor și ar putea depăși în curând inteligența oamenilor care o supraveghează.

Sursă: https://thanhnien.vn/ai-hoc-cach-noi-doi-tinh-vi-hon-khi-bi-phat-185250326112139476.htm

![[Foto] Secretarul general To Lam îl primește pe vicepreședintele Luxshare-ICT Group (China)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763211137119_a1-bnd-7809-8939-jpg.webp)

![[Foto] Panorama rundei finale a Premiilor pentru Acțiune Comunitară 2025](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763206932975_chi-7868-jpg.webp)

![[Foto] Prim-ministrul Pham Minh Chinh se întâlnește cu reprezentanți ai unor profesori remarcabili](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763215934276_dsc-0578-jpg.webp)

Comentariu (0)