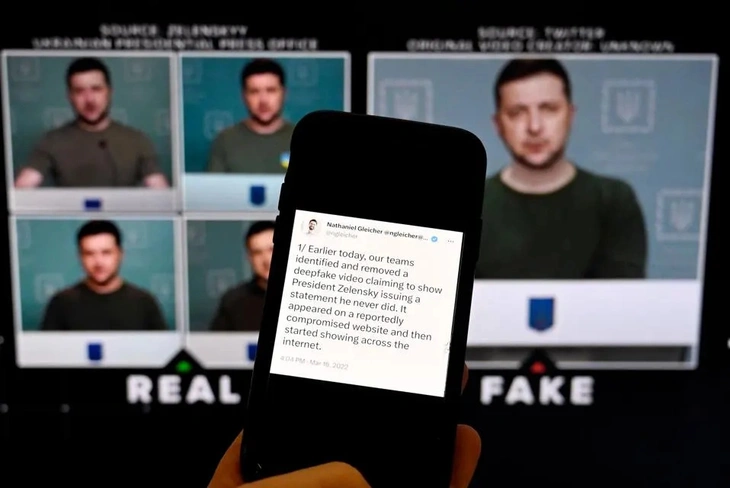

Поддельное видео выступления президента Украины Владимира Зеленского с использованием технологии deepfake - Фото: AFP

Издание Variety сообщило в отчете Resemble AI за первый квартал 2025 года, что сумма ущерба, причиненного дипфейками, превысила 200 миллионов долларов, в основном за счет финансового мошенничества, политических манипуляций, вымогательства и распространения конфиденциального контента, созданного ИИ в целях получения прибыли.

В отчете это описывается как «обостряющийся кризис» со все более изощренными атаками, выходящими за рамки возможностей обнаружения обычными пользователями.

Кто является жертвами дипфейка?

Изначально дипфейки появились как технологическая развлекательная игра. Однако всего за несколько лет эта технология превратилась в мощный инструмент в кампаниях по трансграничному мошенничеству.

По данным Resemble AI, в настоящее время дипфейки в основном используются в видео (46%), за которыми следуют изображения (32%) и аудио (22%).

Тревожно то, что с помощью всего лишь 3–5 секунд аудиозаписи злоумышленники могут создать поддельный голос, достаточно мощный, чтобы обмануть родственников, партнеров или даже системы автоматической проверки.

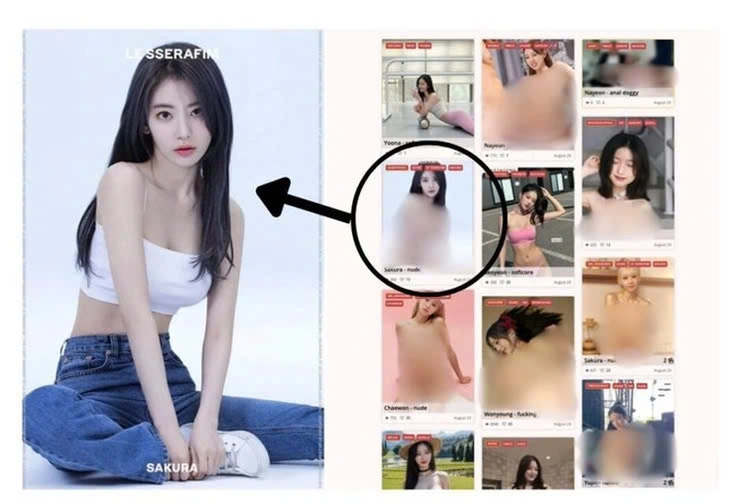

В мире Корея, безусловно, является одним из мест, где эта ситуация наиболее сложна, поскольку существует множество чат-групп, специализирующихся на спаривании идолов с порнографическим контентом для продажи - Фото: X

Мало того, 68% современных поддельных продуктов оцениваются как «практически неотличимые от настоящего контента», что делает их обнаружение крайне сложным даже для технических экспертов.

Сочетание изображений и звука в синхронизированном видео делает имитацию настолько правдоподобной, что реальным людям трудно понять, что их эксплуатируют.

В отчете говорится, что 41% жертв были публичными деятелями, в основном политиками и знаменитостями, а остальные 34% — обычными гражданами.

Риск дипфейков теперь не ограничивается знаменитостями, а распространяется на все слои общества. Мишенью также становятся финансовые учреждения, предприятия и государственные учреждения.

На Северную Америку пришлось 38% случаев, большинство из которых касались политических деятелей. На Азию приходится 27%, на Европу — 21%.

63% атак имели трансграничный элемент, что доказывает, что дипфейки — это не просто внутренняя проблема, а глобальная угроза.

Мошенничество становится все более изощренным во всем мире

Среди мошеннических схем с использованием дипфейков наиболее распространенной формой является контент деликатного характера, наносящий серьезный ущерб репутации и духу жертвы.

Далее следуют финансовые мошенничества, такие как выдача себя за начальника для запроса денежных переводов, выдача себя за родственника, нуждающегося в срочной помощи, или даже инсценировка видеозвонка для проверки поддельной личности.

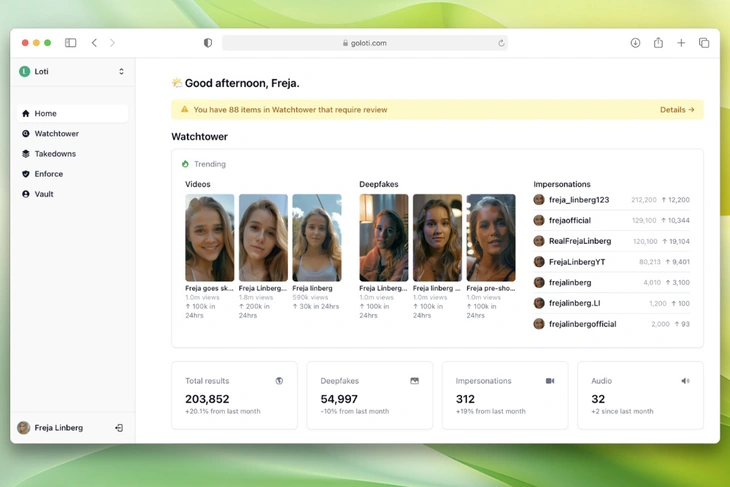

С другой стороны, приложения против дипфейков также разрабатываются все более активно, на фото Loti AI, который только что успешно собрал более 16 миллионов долларов США - Фото: Variety

Еще одной сферой, сильно пострадавшей от дипфейков, стала политика: видеоролики лидеров монтируются, чтобы сбить с толку общественное мнение или манипулировать информацией во время предвыборного сезона.

Кроме того, эта технология также усиливает фейковые новости и дезинформацию, ускоряя распространение контента за счет его убедительного внешнего вида.

«Борьба с дипфейками требует многоуровневого и глобального ответа», — подчеркнул представитель Resemble AI в своем заявлении.

В частности, на первый план должны выйти технологические решения, в том числе: разработка более эффективных систем обнаружения дипфейков, стандартизация протоколов аутентификации контента с использованием водяных знаков и отслеживаемых механизмов цифровой верификации.

В докладе также содержится призыв к правительствам активизировать усилия по созданию единой правовой базы, четко определить вредоносные дипфейки, привлечь к ответственности платформы, на которых они размещены, и ввести эффективные санкции.

Повышение осведомленности общественности, особенно посредством цифровой грамотности и медиаобразования, также рассматривается как ключ к лучшей общественной защите.

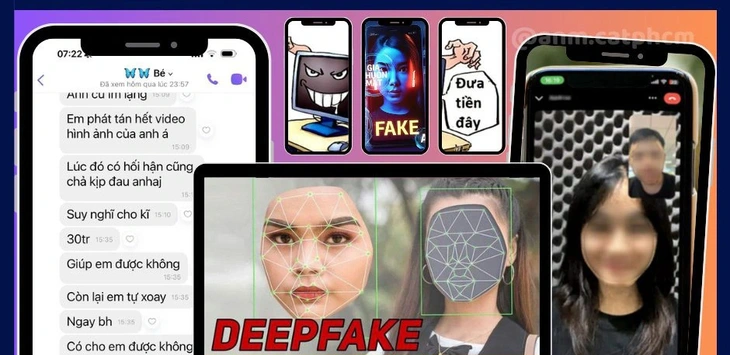

Во Вьетнаме, хотя методы не столь изощренны, в эту ловушку попалось бесчисленное множество жертв. Департамент кибербезопасности и предотвращения высокотехнологичных преступлений постоянно предупреждает - Фото: PA05

Во Вьетнаме также наблюдается значительный рост случаев мошенничества с использованием deepfake, при этом многие ситуации вызывают замешательство в интернет-сообществе.

Некоторые жертвы заявили, что даже получали видеозвонки с голосами и манерой речи, идентичными голосам и манере речи их родственников, что не оставило их ни о чем подозревать.

Завоевав доверие, мошенник продолжает просить о «срочной помощи», например, перевести деньги, предоставить коды аутентификации или одолжить банковские счета.

Столкнувшись с этой ситуацией, эксперты по технологиям предупреждают: дипфейк становится чрезвычайно опасным оружием мошенничества, и Вьетнаму необходимо в ближайшее время стандартизировать правовую базу для защиты пользователей.

ПодробнееВернуться на страницу темы

ТО КУОНГ

Источник: https://tuoitre.vn/deepfake-gay-thiet-hai-hon-200-trieu-usd-3-thang-dau-nam-2025-ai-cung-co-the-la-nan-nhan-20250419185910057.htm

![[Фото] Премьер-министр Фам Минь Чинь встречается с президентом Венгрии Сулёком Тамашем](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/29/dbcaa73e92ea4448a03fe1d0de6d68e8)

![[Фото] Вьетнамские и венгерские лидеры присутствуют на открытии выставки фотографа Бозоки Дежо](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/29/94d8ceca5db14af3bf31285551ae4bb3)

Комментарий (0)