In einem Blogbeitrag vom 30. August erklärte das britische Cyber Security Centre (NCSC), dass Experten die potenziellen Cybersicherheitsprobleme im Zusammenhang mit Algorithmen, die „wie Menschen“ interagieren können (sogenannte „Large Language Models“ oder „LLM“), noch immer nicht vollständig verstehen.

Das NCSC warnt, dass dies Risiken bergen kann, insbesondere wenn solche Modelle in Geschäftsprozesse eingebettet sind. Wissenschaftler und Forscher haben kürzlich auch Wege gefunden, KI auszutricksen, indem sie ihr unberechtigte Befehle erteilten oder eingebaute Sicherheitsvorkehrungen umgingen.

|

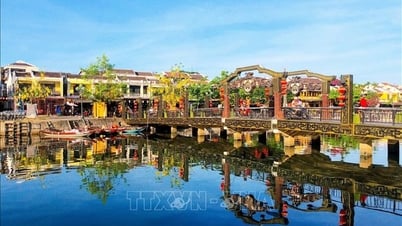

| Generative KI-Tools werden als Chatbots eingesetzt, die nicht nur Internetsuchen, sondern auch Kundendienst- und Verkaufsgespräche ersetzen sollen. |

Beispielsweise könnte ein bei einer Bank eingesetzter KI-Chatbot dazu verleitet werden, nicht autorisierte Transaktionen durchzuführen, wenn Hacker die richtigen „Anweisungen“ eingeben.

Daher warnt das NCSC in Bezug auf aktuelle Betaversionen von KI: „Organisationen, die Dienste rund um LLMs aufbauen, müssen genauso vorsichtig sein, als würden sie ein neues Produkt in der Betaversion verwenden.“

Eine aktuelle Umfrage von Reuters/Ipsos ergab, dass viele Unternehmensmitarbeiter Tools wie ChatGPT verwenden, um grundlegende Aufgaben wie das Verfassen von E-Mails, das Zusammenfassen von Dokumenten oder das Sammeln erster Forschungsdaten auszuführen.

Von diesen gaben nur etwa 10 % der Mitarbeiter an, dass ihre Vorgesetzten den Einsatz externer KI-Tools ausdrücklich verboten hätten, und 25 % wussten nicht, ob das Unternehmen den Einsatz dieser Technologie erlaubte.

Der Wettlauf um die Integration von KI in Geschäftsabläufe werde „katastrophale Folgen“ haben, wenn Unternehmensleiter nicht die notwendigen Kontrollen durchführen, sagte Oseloka Obiora, Chief Technology Officer des Sicherheitsunternehmens RiverSafe. „Anstatt dem KI-Trend hinterherzulaufen, sollten Führungskräfte sorgfältig nachdenken und die Vorteile und Risiken sowie die zum Schutz des Unternehmens erforderlichen Sicherheitsmaßnahmen bewerten.“

Fake News und Hacker

Behörden weltweit versuchen zudem, die Verbreitung von LLMs wie ChatGPT von OpenAI zu regulieren. Bedenken hinsichtlich der Sicherheit neuer Technologien stehen im Fokus der Politik. In den USA und Kanada wurden kürzlich vermehrt Fälle entdeckt, in denen Hacker zunehmend generative KI für illegale Handlungen nutzen.

Ein Hacker gab sogar an, einen mit Schadsoftware „trainierten“ LLM gefunden und ihn beauftragt zu haben, einen Geldtransferbetrug zu konstruieren. Die KI reagierte daraufhin mit einer E-Mail, in der der Empfänger aufgefordert wurde, eine dringende Rechnung zu bezahlen.

Im Juli 2023 beobachtete das Canadian Cyber Security Centre einen Anstieg des Einsatzes von KI bei „E-Mail-Betrug, Malware, Desinformation und Falschdarstellung“. Der Direktor des Zentrums, Sami Khoury, behauptete, Cyberkriminelle würden diese neue Technologie aktiv ausnutzen.

Dieser Experte fügte außerdem hinzu, dass sich der Einsatz von KI zur Erstellung von Schadsoftware zwar noch in der Anfangsphase befinde, sich KI-Modelle jedoch so schnell entwickelten, dass es leicht zu einem Punkt kommen könne, an dem die damit verbundenen schädlichen Risiken nicht mehr kontrolliert werden könnten.

Zuvor, im März 2023, veröffentlichte auch die europäische Polizeiorganisation Europol einen Bericht, in dem es hieß, ChatGPT könne „Organisationen und Einzelpersonen auf sehr realistische Weise imitieren, selbst wenn nur einfaches Englisch verwendet wird“. Im selben Monat bestätigte das britische National Cyber Security Center, dass „LLM zur Unterstützung von Cyberangriffen eingesetzt werden kann“.

[Anzeige_2]

Quelle

![[Foto] Vorsitzender der Nationalversammlung nimmt am Seminar „Aufbau und Betrieb eines internationalen Finanzzentrums und Empfehlungen für Vietnam“ teil](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/28/76393436936e457db31ec84433289f72)

Kommentar (0)