Wie funktionieren gefälschte KI-Bilder?

Künstliche Intelligenz ist heutzutage allgegenwärtig – sogar im Krieg. Die Anwendungen künstlicher Intelligenz haben sich in diesem Jahr so stark verbessert, dass fast jeder KI-Generatoren nutzen kann, um Bilder zu erzeugen, die zumindest auf den ersten Blick realistisch aussehen.

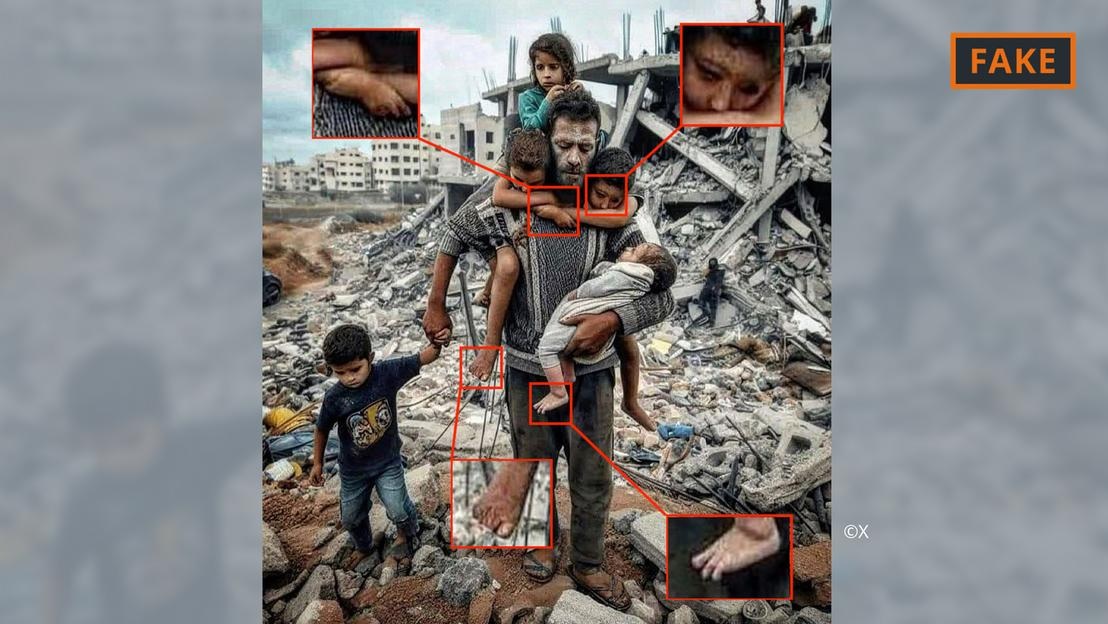

Ein KI-generiertes gefälschtes Foto des Krieges in Gaza.

Nutzer geben Tools wie Midjourney oder Dall-E einfach einige Vorgaben, darunter Spezifikationen und Informationen, an. Die KI-Tools wandeln die Text- oder sogar Spracheingaben dann in Bilder um.

Dieser Bildgenerierungsprozess basiert auf dem sogenannten maschinellen Lernen. Wenn ein Urheber beispielsweise einen 70-jährigen Mann auf einem Fahrrad darstellen möchte, durchsucht er seine Datenbank nach passenden Begriffen und Bildern.

Anhand der verfügbaren Informationen generiert der KI-Algorithmus ein Bild des älteren Radfahrers. Durch stetig wachsende Datenmengen und technische Weiterentwicklungen haben sich diese Tools erheblich verbessert und lernen kontinuierlich dazu.

All dies wird auf Bilder im Zusammenhang mit dem Nahostkonflikt angewendet. In einem Konflikt, in dem die Emotionen hochkochen, hat Fehlinformation, auch durch KI-generierte Bilder verbreitet, enorme Auswirkungen, so der KI-Experte Hany Farid.

Farid, Professor für digitale Analytik an der University of California in Berkeley, sagte, heftige Auseinandersetzungen seien der perfekte Nährboden für die Erstellung und Verbreitung von Falschmeldungen sowie für die Anheizung von Emotionen.

Arten von KI-Bildern des Israel-Hamas-Krieges

Mithilfe künstlicher Intelligenz erstellte Bilder und Videos haben Desinformationen im Zusammenhang mit dem Krieg in der Ukraine angeheizt, und das geschieht auch weiterhin im Krieg zwischen Israel und der Hamas.

Experten zufolge lassen sich KI-generierte Bilder zum Thema Krieg, die in sozialen Medien kursieren, häufig in zwei Kategorien einteilen. Die eine Kategorie konzentriert sich auf das Leid der Menschen und weckt Mitgefühl. Die andere Kategorie umfasst gefälschte KI-Bilder, die Ereignisse übertreiben und dadurch Konflikte schüren und die Gewalt eskalieren lassen.

KI-generiertes gefälschtes Foto von Vater und Kind in den Trümmern von Gaza.

Die erste Kategorie umfasst beispielsweise das obige Foto eines Vaters mit seinen fünf Kindern vor einem Schutthaufen. Es wurde mehrfach auf X (ehemals Twitter) und Instagram geteilt und hunderttausendfach angesehen.

Dieses Bild wurde von der Community, zumindest auf X, als Fälschung gemeldet. Es ist an verschiedenen Fehlern und Unstimmigkeiten erkennbar, die typisch für KI-Bilder sind (siehe Abbildung oben).

Ähnliche Anomalien sind auch in dem gefälschten KI-Bild zu sehen, das auf X unten viral ging und angeblich eine palästinensische Familie zeigt, die gemeinsam auf den Ruinen isst.

KI-generiertes gefälschtes Foto einer palästinensischen Partei.

Ein anderes Bild, das Truppen beim Durchqueren einer Siedlung voller zerbombter Häuser mit israelischen Flaggen zeigt, fällt derweil in die zweite Kategorie und dient dazu, Hass und Gewalt zu schüren.

Woher stammen solche KI-Bilder?

Die meisten KI-generierten Bilder von Konflikten werden auf Social-Media-Plattformen veröffentlicht, sind aber auch auf einer Reihe anderer Plattformen und Organisationen sowie sogar auf einigen Nachrichtenseiten verfügbar.

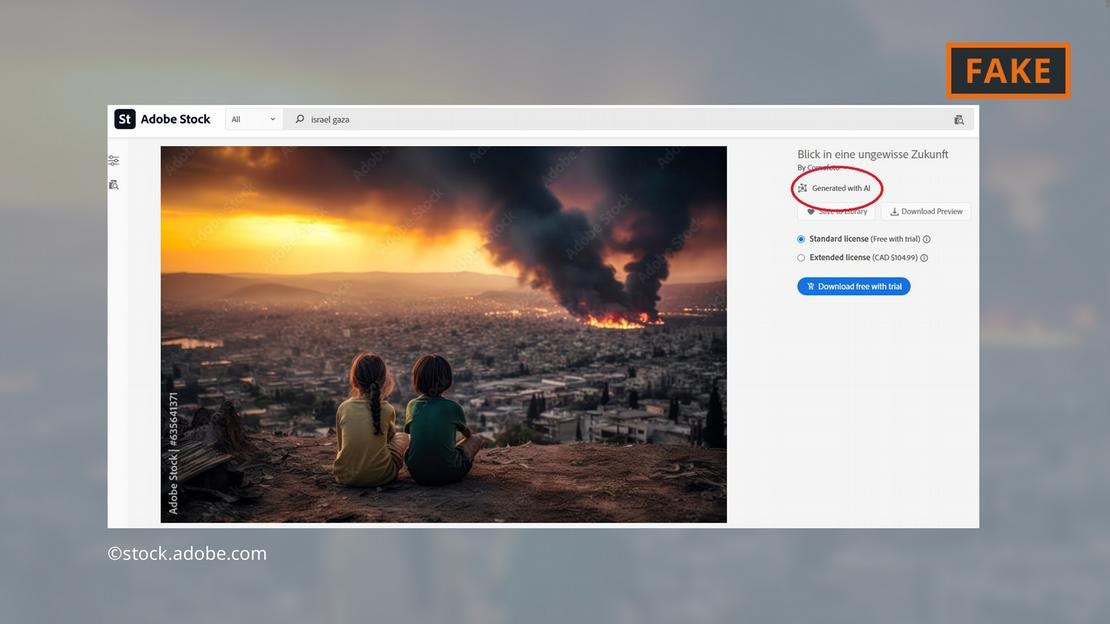

Das Softwareunternehmen Adobe sorgte für Schlagzeilen, indem es bis Ende 2022 KI-generierte Bilder in sein Stockfoto-Angebot aufnahm. Diese werden in der Datenbank entsprechend gekennzeichnet.

Adobe bietet nun auch KI-generierte Bilder des Nahostkriegs zum Verkauf an – wie Explosionen, protestierende Menschen oder Rauchwolken hinter der Al-Aqsa-Moschee.

Adobe bietet KI-generierte Bilder der Kämpfe im Gazastreifen an.

Kritiker sehen darin ein Problem, da einige Websites die Bilder weiterhin verwenden, ohne sie als KI-generiert zu kennzeichnen. Das fragliche Bild erschien beispielsweise auf der Seite „Newsbreak“ ohne jeglichen Hinweis darauf, dass es KI-generiert war.

Sogar der Forschungsdienst des Europäischen Parlaments, der wissenschaftliche Arm des Europäischen Parlaments, illustrierte einen Online-Text über den Nahostkonflikt mit einem KI-Bild aus der Adobe-Datenbank – ohne es als KI-generiert zu kennzeichnen.

Das Europäische Observatorium für digitale Medien mahnt Journalisten und Medienschaffende zu äußerster Vorsicht im Umgang mit KI-Bildern und rät von deren Verwendung ab, insbesondere bei der Berichterstattung über reale Ereignisse wie den Krieg in Gaza.

Wie gefährlich sind KI-Bilder?

Die viralen KI-Inhalte und -Bilder werden zwangsläufig dazu führen, dass Nutzer allem, was sie online sehen, mit Argwohn begegnen. „Wenn wir uns in einer Welt bewegen, in der Bilder, Audio und Video manipuliert werden können , wird alles verdächtig“, erklärt Farid, Forscher an der UC Berkeley. „Man verliert also das Vertrauen in alles, sogar in die Wahrheit.“

Genau das ist im folgenden Fall passiert: Ein Bild, das vermutlich die verkohlte Leiche eines israelischen Babys zeigt, wurde von Israels Premierminister Benjamin Netanjahu und mehreren anderen Politikern in den sozialen Medien geteilt.

Der israelkritische Influencer Jackson Hinkle behauptete später, das Bild sei mithilfe künstlicher Intelligenz erstellt worden. Hinkles Aussage wurde in den sozialen Medien über 20 Millionen Mal aufgerufen und löste dort eine hitzige Debatte aus.

Letztendlich bestätigten zahlreiche Organisationen und Prüftools die Echtheit des Bildes und widerlegten Hinkles Behauptung. Dennoch ist klar, dass kein Tool den Nutzern ihr verlorenes Vertrauen so einfach zurückgeben kann!

Hoang Hai (laut DW)

Quelle

Kommentar (0)