Les chercheurs de DeepSeek ont annoncé un nouveau modèle expérimental appelé V3.2-exp, conçu pour réduire considérablement le coût de l'inférence lorsqu'il est utilisé dans des opérations à contexte long.

DeepSeek a annoncé le modèle dans un article publié sur Hugging Face et a également partagé un article universitaire associé sur GitHub.

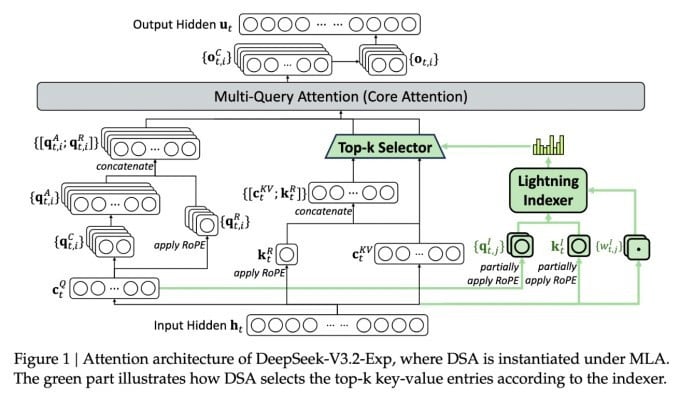

La principale caractéristique de ce nouveau modèle complexe est appelée DeepSeek Sparse Attention. Concrètement, le système utilise un module appelé « indexeur éclair » pour prioriser des extraits spécifiques de la fenêtre de contexte.

DeepSeek annonce un modèle d'inférence économique.

Un système distinct, appelé « système de sélection fine de jetons », sélectionne ensuite des jetons spécifiques parmi ces extraits pour les charger dans la fenêtre d’attention limitée du module. Combinés, ces systèmes permettent aux modèles d’attention parcimonieuse de fonctionner sur de longs segments de contexte avec une charge serveur relativement faible.

Pour les opérations à contexte long, les avantages du système sont considérables. Les tests préliminaires de DeepSeek montrent que le coût d'un simple appel à une fonction d'inférence (API) peut être réduit de moitié dans les scénarios à contexte long.

Des tests supplémentaires sont nécessaires pour établir une évaluation plus robuste, mais comme le modèle est ouvert et disponible gratuitement sur Hugging Face, il ne devrait pas falloir longtemps avant que des tests tiers puissent évaluer les affirmations contenues dans l'article.

Contrairement à d'autres modèles de chatbots IA qui consomment beaucoup d'énergie, DeepSeek s'oriente vers la réduction des coûts, de la formation à l'exploitation.

Le nouveau modèle de DeepSeek fait partie d'une série de percées récentes qui s'attaquent au problème du coût d'inférence, c'est-à-dire essentiellement le coût du serveur pour exécuter un modèle d'IA pré-entraîné, par opposition au coût de son entraînement.

Dans le cas de DeepSeek, les chercheurs cherchaient des moyens de rendre l'architecture de base du transformateur plus efficace et ont constaté que des améliorations importantes devaient être apportées.

Basée en Chine, DeepSeek est une figure atypique dans le monde de l'IA, notamment pour ceux qui perçoivent la recherche en IA comme une compétition sino-américaine. L'entreprise a fait sensation en début d'année avec son modèle R1, entraîné principalement par apprentissage par renforcement à un coût bien inférieur à celui de ses concurrents américains.

Cependant, le modèle n'a pas réussi à déclencher la révolution à grande échelle dans la formation en IA que certains avaient prédite, et l'entreprise s'est progressivement retirée des projecteurs au cours des mois suivants.

La nouvelle approche de « l’attention parcimonieuse » a peu de chances de susciter autant d’indignation que R1, mais elle pourrait tout de même apprendre aux fournisseurs de services américains quelques astuces indispensables pour maintenir les coûts d’inférence à un niveau bas.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Source : https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Photo] Le Premier ministre Pham Minh Chinh préside la 15e réunion du Conseil central d'émulation et de récompense](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F27%2F1764245150205_dsc-1922-jpg.webp&w=3840&q=75)

![[Photo] Le président Luong Cuong assiste aux célébrations du 50e anniversaire de la fête nationale du Laos](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F27%2F1764225638930_ndo_br_1-jpg.webp&w=3840&q=75)

Comment (0)