Selon Dylan Patel, analyste principal chez SemiAnalysis , société d'analyse de semi-conducteurs, les coûts d'exploitation élevés de ChatGPT s'expliquent par une infrastructure coûteuse. ChatGPT requiert une puissance de calcul colossale pour calculer les réponses aux invites des utilisateurs. M. Patel base ses estimations de coûts sur les serveurs coûteux nécessaires à son fonctionnement.

Dans une interview accordée à BI , l'expert a suggéré que le coût actuel était encore plus élevé, car son estimation initiale était basée sur le modèle GPT-3 d'OpenAI. Le dernier modèle, GPT-4, sera plus cher.

Si l'entraînement du grand modèle linguistique (LLM) de ChatGPT coûte des dizaines de millions de dollars, les coûts d'exploitation et d'inférence sont bien plus élevés. Pendant des années, les entreprises utilisant les modèles linguistiques d'OpenAI ont dû débourser des sommes considérables. Par exemple, Nick Walton, PDG de la startup Latitude, a révélé que le coût d'exploitation du modèle sur les serveurs Amazon Web Services s'élevait à environ 200 000 dollars par mois en 2021. Il a donc changé de fournisseur de logiciels linguistiques pour réduire ce coût de moitié.

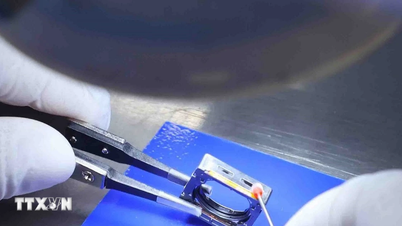

Afin de réduire les coûts d'exécution des modèles d'IA génératifs, Microsoft développe une puce d'IA appelée Athena. Selon The Information , le projet a débuté en 2019, quelques années après la signature d'un contrat d'un milliard de dollars avec OpenAI, autorisant la start-up à utiliser exclusivement des serveurs cloud Azure.

Microsoft poursuit deux objectifs : conscient de son retard sur Google et Amazon dans le domaine des puces, il recherche une alternative moins coûteuse aux puces Nvidia. Plus de 300 employés de Microsoft travaillent sur cette puce, qui pourrait être disponible en interne dès l'année prochaine.

(Selon BI)

Source

Comment (0)