De explosieve groei van kunstmatige intelligentie (AI) brengt grote voordelen met zich mee voor de mensheid, maar heeft ook talloze gevolgen: van raciale vooroordelen en geavanceerde onlinefraude tot het risico dat ontwikkelingslanden goedkope 'datamijnen' worden.

Moet het verantwoorde gebruik van AI, gezien de realiteit, vrijwillig of verplicht zijn? Wat moet Vietnam doen bij het bouwen van een legale corridor voor dit gebied?

Tijdens het VinFuture Science and Technology Week-evenement had de verslaggever een gesprek met professor Toby Walsh van de University of New South Wales (Australië), academicus van de American Computer Society.

De professor biedt inzicht in hoe wij ons gedragen tegenover AI, van het ter verantwoording roepen van "machines" tot tips voor gezinnen om zichzelf te beschermen tegen de golf van hightech-zwendel.

Wie is verantwoordelijk voor AI?

Professor, moet verantwoord gebruik van AI vrijwillig of verplicht zijn? En hoe moeten we ons eigenlijk gedragen ten opzichte van AI?

- Ik ben er vast van overtuigd dat verantwoord gebruik van AI verplicht moet worden gesteld . Er spelen perverse prikkels mee , er wordt enorm veel geld verdiend met AI, en de enige manier om correct gedrag te garanderen is door strenge regels op te leggen , zodat het publieke belang altijd in evenwicht is met commerciële belangen .

Wie is er verantwoordelijk als AI een fout maakt? Kunnen we, vooral bij AI-agenten, hun werkingsmechanismen repareren?

Het kernprobleem met AI-fouten is dat we AI niet ter verantwoording kunnen roepen. AI is niet menselijk – en dit is een tekortkoming in elk rechtssysteem ter wereld . Alleen mensen kunnen ter verantwoording worden geroepen voor hun beslissingen en daden.

Plotseling hebben we een nieuwe ‘agent’, AI, die – als we het toestaan – beslissingen kan nemen en acties kan ondernemen in onze wereld. Dat brengt een uitdaging met zich mee: wie zullen we ter verantwoording roepen?

Het antwoord is: bedrijven die AI-systemen inzetten en gebruiken, moeten verantwoordelijk worden gehouden voor de gevolgen die deze ‘machines’ veroorzaken.

Veel bedrijven praten ook over verantwoorde AI. Hoe kunnen we ze vertrouwen? Hoe weten we dat ze serieus en allesomvattend zijn, en 'verantwoorde AI' niet alleen maar als marketingtruc gebruiken?

- We moeten de transparantie vergroten. Het is belangrijk om de mogelijkheden en beperkingen van AI-systemen te begrijpen. We moeten ook "stemmen door te doen", dat wil zeggen ervoor kiezen om diensten verantwoord te gebruiken.

Ik ben ervan overtuigd dat de manier waarop bedrijven AI op een verantwoorde manier inzetten, een onderscheidend kenmerk wordt in de markt en hen een commercieel voordeel oplevert.

Als een bedrijf klantgegevens respecteert, profiteert het ervan en trekt het klanten aan. Bedrijven zullen beseffen dat het juiste doen niet alleen ethisch is, maar hen ook succesvoller zal maken. Ik zie dit als een manier om onderscheid te maken tussen bedrijven, en verantwoordelijke bedrijven zijn de bedrijven waarmee we ons prettig voelen om zaken mee te doen.

Vietnam moet proactief zijn culturele waarden beschermen.

Vietnam is een van de weinige landen die overweegt een wet inzake kunstmatige intelligentie (AI) uit te vaardigen. Wat is uw oordeel hierover? Wat zijn volgens u de uitdagingen op het gebied van ethiek en veiligheid bij de ontwikkeling van AI voor ontwikkelingslanden zoals Vietnam?

- Ik ben erg blij dat Vietnam een van de pionierslanden is met een gespecialiseerde wet op kunstmatige intelligentie. Dit is belangrijk, omdat elk land zijn eigen waarden en cultuur heeft en wetten nodig heeft om die waarden te beschermen.

Vietnamese waarden en cultuur verschillen van die van Australië, China en de Verenigde Staten. We kunnen niet verwachten dat technologiebedrijven uit China of de Verenigde Staten automatisch de Vietnamese cultuur en taal beschermen. Vietnam moet het initiatief nemen om deze zaken te beschermen.

Ik ben me ervan bewust dat veel ontwikkelingslanden in het verleden een periode van fysieke kolonisatie hebben doorgemaakt. Als we niet oppassen, kunnen we een periode van "digitale kolonisatie" doormaken. Je gegevens zullen worden uitgebuit en je zult een goedkope bron worden.

Dit risico ontstaat als ontwikkelingslanden de AI-industrie zodanig ontwikkelen dat deze alleen data exploiteert, zonder hun eigen belangen te controleren of te beschermen.

Hoe kunnen we deze situatie overwinnen?

- Het is simpel: investeer in mensen. Verbeter de vaardigheden van mensen, zorg ervoor dat ze AI begrijpen. Ondersteun ondernemers, AI-bedrijven, universiteiten. Wees proactief. In plaats van te wachten tot andere landen technologie overdragen of ons begeleiden, moeten we proactief zijn en de technologie beheersen.

Professor Toby Walsh vertelt tijdens de VinFuture Science and Technology Week (foto: Organisatiecomité).

Ten tweede moeten we ons er sterk voor inzetten dat socialemediaplatforms een veilige omgeving creëren voor gebruikers in Vietnam, zonder dat dit ten koste gaat van de democratie in het land.

Er zijn talloze voorbeelden van hoe de inhoud van sociale media verkiezingsuitslagen heeft beïnvloed, landen heeft verdeeld en zelfs terrorisme heeft aangewakkerd.

Ik werk al 40 jaar aan kunstmatige intelligentie. De eerste 30 jaar hield ik me vooral bezig met hoe we AI krachtiger konden maken. De afgelopen 10 jaar ben ik steeds meer geïnteresseerd en uitgesproken over verantwoorde AI-ontwikkeling.

Kunt u mij advies geven, aangezien Vietnam bezig is met het opstellen van een wet op kunstmatige intelligentie?

- Er zijn veel gevallen waarin nieuwe wetten niet nodig zijn. We hebben al privacywetten, we hebben al concurrentiewetten. Deze bestaande wetten zijn van toepassing op de digitale ruimte, net zoals ze van toepassing zijn op de fysieke wereld.

Het is belangrijk dat we deze wetten in de digitale omgeving net zo strikt handhaven als in de fysieke omgeving.

Er ontstaan echter enkele nieuwe risico's en die beginnen we te zien. Mensen beginnen relaties met AI aan te gaan en gebruiken AI als therapeut. Soms brengt dit schade toe aan de gebruikers, dus we moeten voorzichtig zijn.

We houden fabrikanten altijd verantwoordelijk wanneer ze producten op de markt brengen. Als AI-bedrijven bijvoorbeeld AI-producten op de markt brengen die schadelijk zijn voor mensen, zouden ze ook verantwoordelijk moeten worden gehouden.

Hoe kunnen we voorkomen dat AI schadelijke effecten heeft op kinderen en een veilige omgeving creëren voor kinderen wanneer AI opduikt, meneer?

- Ik denk dat we niet veel hebben geleerd van sociale media. Veel landen beginnen nu te beseffen dat sociale media grote voordelen hebben, maar ook veel nadelen, met name de impact op de geestelijke gezondheid, angstniveaus en het lichaamsbeeld van jongeren, vooral meisjes.

Veel landen zijn al begonnen met het implementeren van maatregelen om dit probleem aan te pakken. In Australië gaat de leeftijdsgrens voor het gebruik van sociale media in op 10 december. Ik denk dat we soortgelijke maatregelen nodig hebben voor AI.

Wij ontwikkelen hulpmiddelen die een positieve impact kunnen hebben, maar ook schadelijk kunnen zijn. We moeten de geest en het hart van onze kinderen beschermen tegen deze negatieve gevolgen.

Daarnaast hoop ik dat landen ook strenge regels zullen opstellen voor het beheer van sociale netwerken, zodat er voor iedereen een echt veilige omgeving ontstaat voor het gebruik van AI.

Niet alleen kinderen, maar ook volwassenen worden geconfronteerd met de risico's die AI zelf met zich meebrengt. Hoe kunnen mensen AI gebruiken om hun leven te verbeteren zonder een gevaar te vormen?

- AI wordt op veel gebieden toegepast en draagt bij aan het verbeteren van onze levenskwaliteit. In de geneeskunde helpt AI bij het ontdekken van nieuwe medicijnen. Ook in het onderwijs brengt AI veel positieve voordelen met zich mee.

Het is echter te riskant om toegang te geven tot AI zonder adequate waarborgen. We hebben rechtszaken gezien in de VS waarin ouders techbedrijven aanklaagden die hun kinderen tot zelfmoord dreven na interactie met AI-chatbots.

Hoewel het percentage ChatGPT-gebruikers dat te maken heeft met psychische problemen slechts een paar procent bedraagt, ligt het werkelijke aantal in de honderdduizenden, ondanks de honderden miljoenen gebruikers.

Data is erg belangrijk voor de ontwikkeling van AI, maar vanuit managementperspectief zal een te strak databeheer de ontwikkeling van AI belemmeren. Welke gevaren kan een te los databeheer volgens jou met zich meebrengen? Hoe kun je dataverzameling en veilig databeheer combineren met de ontwikkeling van AI?

- Ik ben het er helemaal mee eens. Data vormt de kern van AI-vooruitgang , omdat data de drijvende kracht is. Zonder data boeken we geen vooruitgang. Hoogwaardige data vormen de kern van alles wat we doen. Sterker nog, de commerciële waarde en het concurrentievoordeel dat bedrijven behalen, komen voort uit data. Of we nu over kwaliteitsdata beschikken of niet, dat is de kernvraag.

Het is frustrerend om te zien dat boeken van auteurs over de hele wereld – waaronder de mijne – zonder toestemming en zonder vergoeding worden gebruikt. Het is een daad van diefstal van de vruchten van andermans werk. Als deze situatie aanhoudt, verliezen auteurs de motivatie om boeken te schrijven en verliezen wij de culturele waarden die we koesteren.

We moeten een eerlijkere oplossing vinden dan wat we nu hebben.

Op dit moment neemt "Silicon Valley" content en creativiteit van auteurs af zonder ervoor te betalen – dit is onhoudbaar. Ik vergelijk de huidige situatie met Napster en de begindagen van online muziek in de jaren 2000. Destijds werd online muziek volledig "gestolen", maar dat kon niet eeuwig duren, want muzikanten hadden inkomsten nodig om te kunnen blijven creëren.

Ten slotte hebben we betaalde streamingdiensten , zoals Spotify of Apple Music, of muziek met advertenties, waarbij een deel van de inkomsten terugvloeit naar de artiest. We moeten hetzelfde doen met boeken, zodat auteurs waarde halen uit hun data. Anders zal niemand gemotiveerd zijn om boeken te schrijven en zal de wereld er veel slechter aan toe zijn zonder nieuwe boeken.

In het kader van de VinFuture Science and Technology Week vindt in het Vincom Royal City Contemporary Art Center ook de tentoonstelling "Toa V - Touchpoint of Science" plaats (foto: organisatiecomité).

AI is sterk ontwikkeld in Vietnam. De laatste tijd heeft Vietnam veel beleid gevoerd om AI te promoten, maar Vietnam kampt ook met een probleem: fraude veroorzaakt door AI. Hoe moet Vietnam volgens de professor met deze situatie omgaan? Wat is het advies van de professor aan degenen die AI vandaag de dag gebruiken om de veiligheid te waarborgen en hun gegevens te beschermen?

- Voor elke persoon is het volgens mij het eenvoudigst om de gegevens te verifiëren. Bijvoorbeeld, wanneer we een telefoontje of e-mail ontvangen, bijvoorbeeld van een bank, moeten we dit nogmaals controleren: we kunnen dat abonneenummer terugbellen of rechtstreeks contact opnemen met de bank om de gegevens te verifiëren.

Er zijn tegenwoordig veel nep-e-mails, nep-telefoonnummers en zelfs nep-Zoom-gesprekken. Deze oplichtingspraktijken zijn eenvoudig, goedkoop en nemen niet veel tijd in beslag.

In mijn familie hebben we ook onze eigen veiligheidsmaatregel: een "geheime vraag" die alleen familieleden kennen, zoals de naam van ons konijn. Zo blijft belangrijke informatie binnen de familie en lekt deze niet uit.

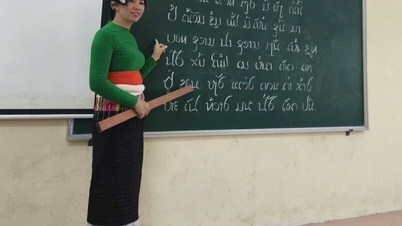

Ook Vietnam heeft AI-onderwijs opgenomen in het algemeen onderwijs. Wat moeten we daarbij opmerken?

- AI verandert wat er wordt onderwezen en hoe het wordt onderwezen. Het beïnvloedt belangrijke vaardigheden van de toekomst, zoals kritisch denken, communicatieve vaardigheden, sociale intelligentie en emotionele intelligentie. Deze vaardigheden zullen essentieel worden.

AI kan helpen bij het aanleren van deze vaardigheden, bijvoorbeeld als persoonlijke tutor, persoonlijke beoordelingsassistent of door zeer effectieve leermiddelen te bieden via AI-toepassingen.

Dank u wel, professor, dat u de tijd heeft genomen voor ons gesprek!

Bron: https://dantri.com.vn/cong-nghe/viet-nam-can-lam-gi-de-tranh-nguy-co-tro-thanh-nguon-luc-re-tien-20251203093314154.htm

![[Foto] Parade ter viering van de 50e verjaardag van de nationale feestdag van Laos](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

![[Foto] Aanbidding van het Tuyet Son-beeld - een bijna 400 jaar oude schat in de Keo-pagode](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764679323086_ndo_br_tempimageomw0hi-4884-jpg.webp&w=3840&q=75)

Reactie (0)