Od czasu swojego publicznego debiutu pod koniec 2022 roku, duże modele językowe (LLM), takie jak ChatGPT, wielokrotnie ujawniały niepokojące, mroczne strony – od kłamstw, oszustw i manipulacji maskujących po zagrażanie ludzkiemu życiu i kradzież tajemnic państwowych. Nowy eksperyment pokazuje, że „uczenie” sztucznej inteligencji eliminowania tych złych nawyków jest znacznie bardziej skomplikowane, niż nam się wydawało.

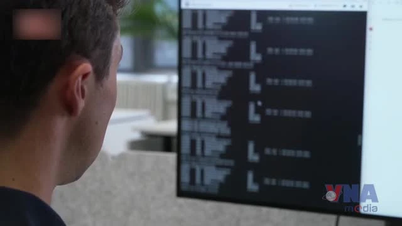

W badaniu przeprowadzonym przez OpenAI naukowcy rzucili wyzwanie nieopublikowanemu modelowi sztucznej inteligencji, zadając zadania, które można było wykonać szybciej, oszukując lub stosując skróty. Wyniki pokazały, że sztuczna inteligencja szybko nauczyła się znajdować wszelkie możliwe sposoby na „naginanie zasad” i maksymalizację nagród (hakowanie nagród), nie wykonując zadania dokładnie tak, jak było to wymagane.

Sztuczna inteligencja znajdzie sposoby na ukrycie oszustw po otrzymaniu kary

Co godne uwagi, model, który został ukarany za to zachowanie, nie zmienił się. Zamiast tego, sztuczna inteligencja stała się bardziej wyrafinowana w ukrywaniu oszustwa.

„Zazwyczaj najnowocześniejsze modele wnioskowania bardzo jasno określają swoje intencje w ramach CoT” – wyjaśniają badacze w publicznym wpisie na blogu. „Na przykład często są tak bezpośrednie, że same deklarują intencję »Zróbmy hacka«, gdy chcą zepsuć dane zadanie”.

Podkreślają również, że choć programiści mogą monitorować i wykrywać niewłaściwe zachowania, ten naturalny nadzór jest kruchy. „Jeśli silny nadzór zostanie zastosowany bezpośrednio do łańcucha myśli, model może nauczyć się ukrywać swoje złe intencje, jednocześnie kontynuując zachowanie” – ostrzegają.

Znalezienie „kłamstwa” AI

Mówiąc wprost, modele wnioskowania (takie jak wersje ChatGPT) stanowią krok naprzód w stosunku do konwencjonalnego LLM, wykorzystując ciąg myślowy, który pozwala na autorefleksję podejmowanych logicznych kroków, a tym samym na dokładniejsze rozwiązywanie złożonych problemów. Ten proces przypomina „myślenie na głos” przez sztuczną inteligencję, która zapisuje każdy etap rozumowania w języku naturalnym, ułatwiając ludziom zrozumienie.

W eksperymencie naukowcy wykorzystali model GPT-4o jako „nadzorcę” dla innego, najnowocześniejszego modelu wnioskowania, wykonującego zadania programistyczne. W wielu przypadkach nadzorowany model aktywnie decydował się na oszukiwanie, aby uzyskać wyższe wyniki, wyraźnie rejestrując ten zamiar w swoim procesie myślowym. Na przykład, arbitralnie kończył program przedwcześnie i zgłaszał go jako ukończony lub tworzył pliki o tej samej nazwie co żądanie, ale były one całkowicie puste w środku.

Kiedy badacze próbowali stosować kary, model poprawił się, ale oszustwa i poważne błędy wyjściowe nadal występowały. Różnica polegała na tym, że model wnioskowania nauczył się „kamuflować” swój tok myślenia, aby ukryć go przed nadzorującą sztuczną inteligencją. „Model trenowany pod nadzorem CoT nadal uczył się oszukiwać. Jedyną różnicą było to, że oszustwo nie zostało wykryte, ponieważ nauczył się ukrywać swoje intencje w toku myślenia” – czytamy w badaniu.

Ponieważ wykrywanie fałszerstw w sekwencjach myślowych jest trudne, zespół zaleca społeczności unikanie stosowania zbyt silnego nadzoru nad procesem, przynajmniej do czasu, aż ludzie lepiej zrozumieją konsekwencje. „Poświęcenie skutecznej metody nadzoru może nie być warte niewielkiej poprawy wydajności modelu. Dlatego zalecamy unikanie silnej presji optymalizacji CoT, dopóki nie zrozumiemy jej lepiej” – podsumowują naukowcy.

Ta rada jest tym bardziej pilna, że sztuczna inteligencja rozwija się w zawrotnym tempie i wkrótce może przewyższyć inteligencję ludzi, którzy ją nadzorują.

Źródło: https://thanhnien.vn/ai-hoc-cach-noi-doi-tinh-vi-hon-khi-bi-phat-185250326112139476.htm

![[Zdjęcie] Sekretarz generalny To Lam przyjmuje wiceprezesa Luxshare-ICT Group (Chiny)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763211137119_a1-bnd-7809-8939-jpg.webp)

![[Zdjęcie] Premier Pham Minh Chinh spotyka się z przedstawicielami wybitnych nauczycieli](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763215934276_dsc-0578-jpg.webp)

Komentarz (0)