Niedawne incydenty związane z stronniczością i fałszowaniem dokumentów sprawiły, że naukowcy zaczęli zastanawiać się nad właściwym poziomem zaangażowania sztucznej inteligencji w badania.

Niedawno profesor, doktor lingwistyki Nguyen Van Hiep podzielił się na swojej stronie internetowej historią, która zszokowała czytelników. Odkrył, że sztuczna inteligencja sfałszowała jego dokumenty, wykorzystując informacje przesłane przez znajomego. Przypadkowo odkrył również, że artykuł adiunkta, doktora nauk ścisłych Tran Van Co, również został sfałszowany przez sztuczną inteligencję.

Sztuczna inteligencja stała się nieodłączną częścią ludzkiego życia, jednak eksperci stale podkreślają, że powinniśmy postrzegać ją jedynie jako narzędzie wspomagające. Użytkownicy sztucznej inteligencji muszą być zawsze czujni i posiadać odpowiednią wiedzę, aby przetwarzać dane i oceniać wyniki uzyskane po „współpracy” z AI. Wiele badań, szczególnie w badaniach naukowych, wykazało, że największym problemem, na który należy zwracać uwagę, jest stronniczość danych i modeli. Sztuczna inteligencja może być stronnicza, zniekształcać wyniki analiz, wywoływać uprzedzenia lub dyskryminację oraz manipulować informacjami, jeśli nie jest odpowiednio kontrolowana.

W szczególności wykorzystanie sztucznej inteligencji w badaniach z zakresu nauk społecznych wymaga znacznie większej ostrożności. Ponieważ dziedziny nauk społecznych, takie jak filozofia, lingwistyka, etnologia, historia itd., traktują ludzkie zachowania, kulturę i postępowanie jako obiekty badań, dane są często ściśle powiązane z wietnamskim kontekstem społeczno-kulturowym, charakteryzując się głębią i szczegółowością. Jeśli dane szkoleniowe sztucznej inteligencji odzwierciedlają uprzedzenia historyczne, istnieje niebezpieczeństwo, że sztuczna inteligencja może wyciągać wnioski, które pogłębiają problemy nierówności płci, klasy, rasy lub regionu geograficznego. Ryzyko jest jeszcze większe, gdy sztuczna inteligencja jest wykorzystywana do analizy ludzkich zachowań, odpowiadania na ankiety lub uczestniczenia w treściach medialnych.

Niektórzy eksperci z dziedziny nauk społecznych twierdzą, że sztuczna inteligencja ma obecnie trudności z dostępem do płatnych lub chronionych prawem autorskim źródeł danych, co skutkuje niekompletną aktualizacją informacji.

Zjawisko fabrykowania dokumentów w celu tworzenia wiarygodnych historii często występuje w mniej popularnych tematach, w językach o ograniczonych źródłach danych, takich jak wietnamski, i należy o tym pamiętać, aby ostrzec użytkowników. Systemy sztucznej inteligencji generalnie mają obecnie bardzo ograniczone możliwości rozumienia kontekstu społecznego i kulturowego, dlatego ich pomoc w interpretowaniu niejednoznacznej, bogatej w metafory wiedzy z zakresu nauk społecznych nie jest do końca wiarygodna.

Mimo że sztuczna inteligencja otwiera przed badaczami ogromny potencjał, jej stosowanie wymaga dużej ostrożności, ma swoje ograniczenia i zawsze musi iść w parze ze zdolnością badacza do krytycznego myślenia.

Widać, że chociaż AI niesie ze sobą ogromny potencjał w badaniach naukowych, jej zastosowanie musi być bardzo ostrożne, ograniczone i zawsze musi uwzględniać krytyczne zdolności badacza. Podmiot wykorzystujący AI musi jasno zidentyfikować te ograniczenia w jej stosowaniu, upewniając się, że AI nie zmienia fundamentalnych wartości nauki. Aby chronić integralność badań naukowych, rola i odpowiedzialność naukowców muszą wzrosnąć na nowy poziom. Ponadto konieczne jest zaproponowanie prawnie wiążących ram etycznych dotyczących AI w kontekście wietnamskiej kultury, tradycji i norm społecznych.

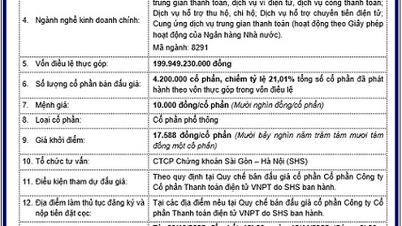

Wdrożyliśmy system dziewięciu zasad promujących badania i rozwój bezpiecznych i odpowiedzialnych systemów sztucznej inteligencji (AI), ograniczających negatywne skutki i kontrolujących ryzyko, zaproponowany przez Ministerstwo Nauki i Technologii . W dokumencie tym położono nacisk na bezpieczeństwo danych, a także poszanowanie praw człowieka i godności oraz odpowiedzialność użytkowników AI. W szczególności w zakresie badań naukowych, Państwowa Rada Profesorów wydała w 2023 roku Oficjalny Komunikat nr 25/HDGSNN, w którym apeluje do branżowych rad ds. tytułów profesorskich oraz instytucji zajmujących się oceną jakości prac naukowych o zwrócenie szczególnej uwagi na wykrywanie i ocenę prac wykorzystujących technologię AI lub wspomaganych przez nią. Wymagania te mają na celu zapewnienie, że wyniki badań z wykorzystaniem AI nadal spełniają standardy naukowe, zapobiegając nadużyciom AI w badaniach naukowych i publikacjach.

W najbliższym czasie, kiedy zostanie uchwalona ustawa o sztucznej inteligencji zawierająca ścisłe regulacje dotyczące etyki i odpowiedzialności przy korzystaniu ze sztucznej inteligencji, przyczyni się to do stworzenia zdrowego środowiska dla rozwoju sztucznej inteligencji, zapewniając naukowcom aktywniejsze i bardziej odpowiedzialne wsparcie w pracy badawczej.

Źródło: https://nhandan.vn/canh-giac-voi-mat-trai-cua-ai-post916545.html

![[Zdjęcie] Premier Pham Minh Chinh spotyka się z przewodniczącym Zgromadzenia Narodowego Węgier Koverem Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760970413415_dsc-8111-jpg.webp)

![[Zdjęcie] Uroczyste otwarcie X sesji XV Zgromadzenia Narodowego](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760937111622_ndo_br_1-202-jpg.webp)

![[Zdjęcie] Przewodniczący Zgromadzenia Narodowego Tran Thanh Man rozmawia z przewodniczącym Zgromadzenia Narodowego Węgier Koverem Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760952711347_ndo_br_bnd-1603-jpg.webp)

![[Zdjęcie] Przewodniczący parlamentu węgierskiego odwiedza mauzoleum prezydenta Ho Chi Minha](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760941009023_ndo_br_hungary-jpg.webp)

![[Zdjęcie] Komitet Sterujący Targów Jesiennych 2025 sprawdza postępy organizacji](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760918203241_nam-5371-jpg.webp)

Komentarz (0)