(CLO) Narzędzie Whisper firmy OpenAI do zamiany mowy na tekst jest reklamowane jako „niemal na poziomie ludzkim, niezawodne i dokładne”, ale ma jedną poważną wadę: jest podatne na tworzenie fragmentów tekstu, a nawet całych zdań!

Eksperci twierdzą, że niektóre z tworzonych przez nią tekstów, określane w branży mianem halucynogennych, mogą zawierać komentarze rasistowskie, przemoc, a nawet wyimaginowane metody leczenia .

Eksperci twierdzą, że tego typu fałszerstwa są poważne, ponieważ Whisper jest używany w wielu branżach na całym świecie do tłumaczenia i transkrybowania wywiadów, generowania tekstu i napisów do filmów.

Co bardziej niepokojące, ośrodki medyczne korzystają z narzędzi opartych na technologii Whisper do rejestrowania konsultacji pacjentów z lekarzami, pomimo ostrzeżeń OpenAI, że narzędzia tego nie należy używać w „obszarach wysokiego ryzyka”.

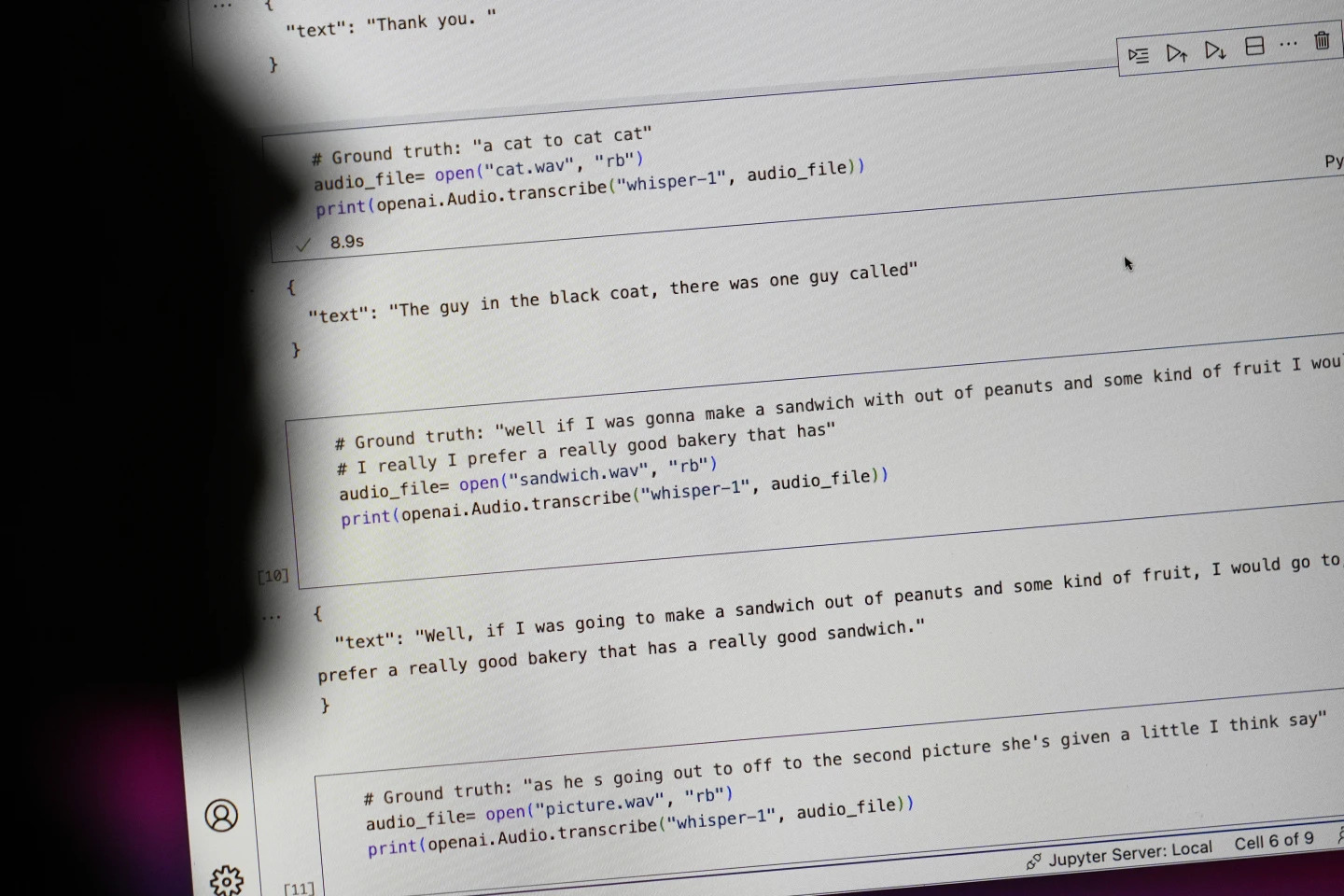

Zdania zaczynające się od „#Ground truth” to to, co faktycznie zostało powiedziane, zdania zaczynające się od „#text” to to, co Whisper przepisał. Zdjęcie: AP

Naukowcy i inżynierowie twierdzą, że Whisper często wywołuje halucynacje podczas użytkowania. Na przykład, badacz z Uniwersytetu Michigan stwierdził, że w ośmiu na dziesięć przeanalizowanych przez siebie nagrań wykrył halucynacje.

Jeden z pierwszych inżynierów uczenia maszynowego odkrył manipulację w około połowie z ponad 100 godzin transkryptów Whisper, które przeanalizował. Trzeci programista stwierdził, że w niemal każdym z 26 000 transkryptów utworzonych za pomocą Whisper wykrył halucynacje.

Złudzenie to utrzymuje się nawet w krótkich, dobrze nagranych próbkach audio. Niedawne badanie przeprowadzone przez informatyków wykazało 187 zniekształceń w ponad 13 000 czystych klipach audio, które przebadali.

Naukowcy twierdzą, że taka tendencja doprowadziłaby do dziesiątek tysięcy błędów w milionach nagrań.

Jak powiedziała Alondra Nelson, profesor w Szkole Nauk Społecznych w Instytucie Studiów Zaawansowanych, takie błędy mogą mieć „naprawdę poważne konsekwencje”, zwłaszcza w warunkach szpitalnych.

„Nikt nie chce otrzymać błędnej diagnozy. Potrzebna jest wyższa bariera” – powiedział Nelson.

Profesorki Allison Koenecke z Uniwersytetu Cornella i Mona Sloane z Uniwersytetu Wirginii przeanalizowały tysiące krótkich fragmentów znalezionych w TalkBank, archiwum badawczym Uniwersytetu Carnegie Mellon. Ustaliły, że prawie 40% halucynacji było szkodliwych lub niepokojących, ponieważ osoba mówiąca mogła zostać źle zrozumiana lub przeinaczona.

Osoba mówiąca w jednym z nagrań opisała „dwie inne dziewczyny i kobietę”, ale Whisper wymyśliła dodatkowy komentarz rasowy, dodając „dwie inne dziewczyny i kobietę, która była czarna”.

W innej transkrypcji Whisper wynalazł nieistniejący lek o nazwie „antybiotyki o zwiększonej aktywności”.

Choć większość programistów przyznaje, że narzędzia do transkrypcji mogą popełniać błędy ortograficzne i inne, inżynierowie i badacze twierdzą, że nigdy nie widzieli narzędzia do transkrypcji opartego na sztucznej inteligencji, które działałoby tak halucynogennie jak Whisper.

Narzędzie jest zintegrowane z kilkoma wersjami flagowego chatbota OpenAI, ChatGPT, i stanowi zintegrowaną usługę na platformie chmurowej Oracle i Microsoft, obsługującą tysiące firm na całym świecie. Służy również do transkrypcji i tłumaczenia tekstu na wiele języków.

Ngoc Anh (według AP)

Źródło: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Zdjęcie] Otwarcie Światowego Festiwalu Kultury w Hanoi](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760113426728_ndo_br_lehoi-khaimac-jpg.webp)

![[Zdjęcie] Odkryj wyjątkowe przeżycia na pierwszym Światowym Festiwalu Kultury](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/11/1760198064937_le-hoi-van-hoa-4199-3623-jpg.webp)

![[Zdjęcie] Sekretarz generalny bierze udział w paradzie z okazji 80. rocznicy założenia Koreańskiej Partii Robotniczej](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/11/1760150039564_vna-potal-tong-bi-thu-du-le-duyet-binh-ky-niem-80-nam-thanh-lap-dang-lao-dong-trieu-tien-8331994-jpg.webp)

![[Zdjęcie] Ho Chi Minh City lśni flagami i kwiatami w przededniu I Kongresu Partii, kadencji 2025-2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760102923219_ndo_br_thiet-ke-chua-co-ten-43-png.webp)

Komentarz (0)