Prezes Truepic, Jeffrey McGregor, powiedział, że incydent to dopiero początek. W mediach społecznościowych pojawi się więcej treści generowanych przez sztuczną inteligencję, a my nie jesteśmy na to gotowi – powiedział McGregor.

Według CNN, Truepic chce rozwiązać ten problem, udostępniając technologię, która ma uwierzytelniać media w momencie ich utworzenia za pomocą Truepic Lens. Aplikacja do zbierania danych poinformuje użytkowników o dacie, godzinie, lokalizacji i urządzeniu użytym do utworzenia zdjęcia, a także zastosuje podpis cyfrowy w celu weryfikacji, czy zdjęcie jest naturalne, czy wygenerowane przez sztuczną inteligencję.

Fałszywe zdjęcie eksplozji w Pentagonie staje się viralem na Twitterze

Truepic, firma wspierana przez Microsoft, założona w 2015 r., poinformowała, że cieszy się zainteresowaniem organizacji pozarządowych , firm medialnych, a nawet ubezpieczycieli, którzy chcą potwierdzić zasadność roszczeń.

McGregor twierdzi, że kiedy wszystko będzie można sfałszować, kiedy sztuczna inteligencja osiągnie szczyt jakości i dostępności, nie będziemy już wiedzieć, jak wygląda rzeczywistość w sieci.

Firmy technologiczne, takie jak Truepic, od lat walczą z dezinformacją w internecie. Jednak pojawienie się nowej generacji narzędzi AI, które potrafią generować obrazy i tekst na żądanie użytkownika, sprawiło, że problem stał się jeszcze pilniejszy. Na początku tego roku szeroko rozpowszechniano fałszywe zdjęcia papieża Franciszka w puchowej kurtce Balenciagi oraz byłego prezydenta USA Donalda Trumpa aresztowanego. Oba te incydenty wprowadziły miliony ludzi w błąd co do potencjalnych zagrożeń związanych ze sztuczną inteligencją.

Niektórzy ustawodawcy wzywają teraz firmy technologiczne do zajęcia się tym problemem poprzez etykietowanie treści generowanych przez sztuczną inteligencję. Wiceprzewodnicząca Komisji Europejskiej (KE) Vera Jourova poinformowała, że firmy takie jak Google, Meta, Microsoft i TikTok przystąpiły do dobrowolnego kodeksu postępowania Unii Europejskiej (UE) w sprawie zwalczania dezinformacji.

Coraz więcej startupów i gigantów technologicznych, w tym tych, które wdrażają generatywną sztuczną inteligencję w swoich produktach, stara się wdrażać standardy i rozwiązania, które pomogą ludziom ustalić, czy dany obraz lub wideo został stworzony przy użyciu sztucznej inteligencji.

Jednak w miarę jak technologia sztucznej inteligencji postępuje szybciej, niż ludzie są w stanie za nią nadążyć, nie jest jasne, czy te rozwiązania w pełni rozwiążą problem. Nawet OpenAI, firma stojąca za Dall-E i ChatGPT, przyznała, że jej własne metody wykrywania tekstu generowanego przez sztuczną inteligencję są niedoskonałe.

Firmy opracowujące rozwiązania stosują dwa podejścia do tego problemu. Pierwsze opiera się na opracowaniu programów identyfikujących obrazy generowane przez sztuczną inteligencję po ich wygenerowaniu i udostępnieniu online. Drugie koncentruje się na oznaczaniu obrazu jako rzeczywistego lub wygenerowanego przez sztuczną inteligencję za pomocą pewnego rodzaju podpisu cyfrowego.

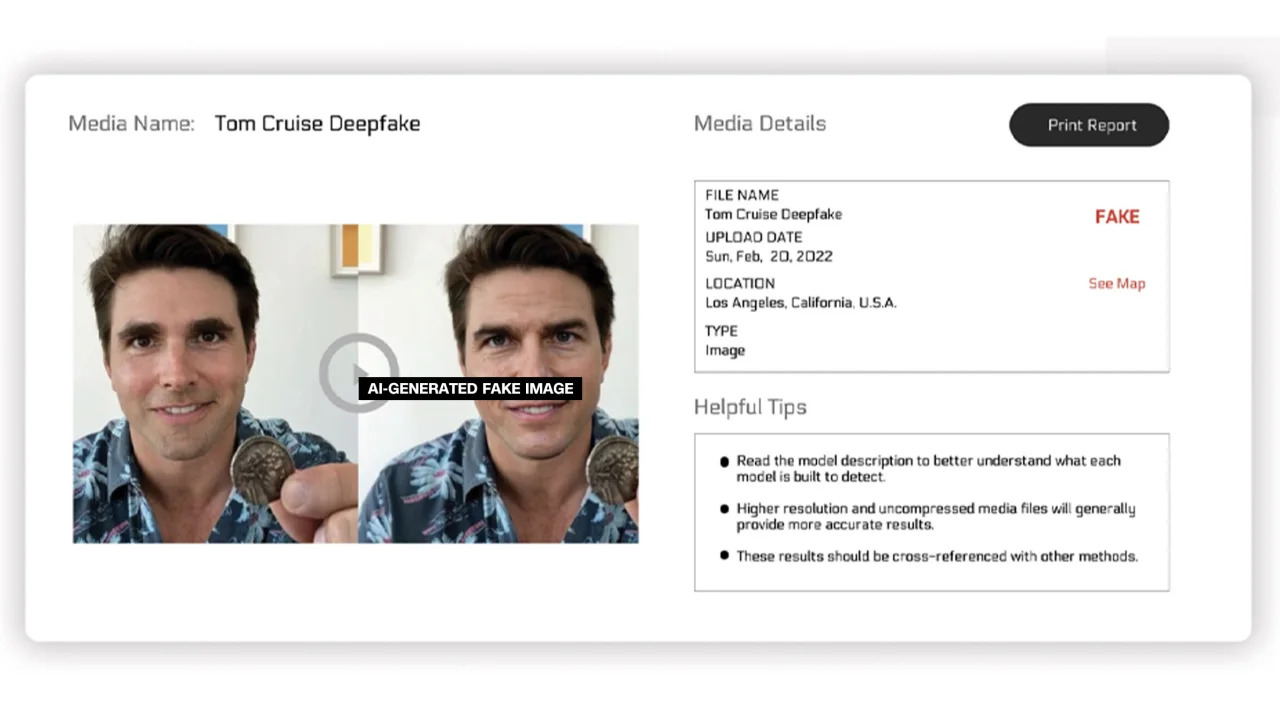

Reality Defender i Hive Moderation pracują nad pierwszą z nich. Za pomocą ich platformy użytkownicy mogą przesyłać obrazy do zeskanowania, a następnie otrzymywać zestawienie procentowe, które pokazuje, czy zdjęcie jest prawdziwe, czy wygenerowane przez sztuczną inteligencję.

Reality Defender twierdzi, że wykorzystuje opatentowaną technologię deepfake i generatywnego odcisku palca treści do wykrywania filmów, dźwięków i obrazów generowanych przez sztuczną inteligencję. W przykładzie podanym przez firmę, Reality Defender pokazał zdjęcie Toma Cruise'a wykonane techniką deepfake, które w 53% było „podejrzane”, ponieważ osoba na zdjęciu miała zniekształconą twarz, co często można zaobserwować na zmanipulowanych zdjęciach.

Oznaczone obrazy generowane przez sztuczną inteligencję

Usługi te oferują wersje bezpłatne i płatne. Hive Moderation twierdzi, że pobiera opłatę w wysokości 1,50 USD za 1000 zdjęć. Realty Defender twierdzi, że ceny mogą się różnić w zależności od wielu czynników, w przypadku gdy klienci potrzebują wiedzy i wsparcia firmy. Prezes Realty Defender, Ben Colman, twierdzi, że ryzyko podwaja się z miesiąca na miesiąc, ponieważ każdy może tworzyć fałszywe zdjęcia za pomocą narzędzi AI.

Kilka innych firm pracuje nad dodaniem do obrazów swoistej etykiety, która potwierdzałaby, czy są one prawdziwe, czy wygenerowane przez sztuczną inteligencję. Do tej pory prace te były w dużej mierze prowadzone przez Content Authenticity and Origination Alliance (C2PA).

Organizacja C2PA została założona w 2021 roku w celu stworzenia standardu technicznego certyfikującego pochodzenie i historię mediów cyfrowych, łączącego inicjatywę Content Authentication Initiative (CAI) firmy Adobe z projektem Project Origin, kierowanym przez Microsoft i BBC, a koncentrującego się na zwalczaniu dezinformacji w wiadomościach cyfrowych. Inne firmy zaangażowane w C2PA to Truepic, Intel i Sony.

Opierając się na zasadach C2PA, CAI udostępni firmom narzędzia open source do tworzenia danych uwierzytelniających treści, czyli metadanych, zawierających informacje o obrazach. Według strony internetowej CAI, umożliwia to twórcom transparentne udostępnianie informacji o tym, jak stworzyli obraz. W ten sposób użytkownicy końcowi mogą uzyskać dostęp do kontekstu dotyczącego tego, kto, co i jak zmodyfikował obraz, a następnie samodzielnie ocenić jego autentyczność.

Wiele firm zintegrowało już standard C2PA i narzędzia CAI ze swoimi aplikacjami. Adobe Firefly, nowe narzędzie do obróbki obrazu oparte na sztucznej inteligencji dodane do programu Photoshop, jest zgodne ze standardem C2PA dzięki funkcji Content Credentials. Firma Microsoft ogłosiła również, że obrazy i filmy utworzone za pomocą programów Bing Image Creator i Microsoft Designer będą w nadchodzących miesiącach opatrzone podpisami kryptograficznymi.

W maju Google ogłosiło funkcję „Informacje o tym obrazie”, która pozwala użytkownikom sprawdzić, kiedy obraz pojawił się po raz pierwszy w Google i gdzie można go zobaczyć. Gigant wyszukiwania ogłosił również, że każdy obraz wygenerowany przez sztuczną inteligencję Google będzie zawierał znacznik w oryginalnym pliku, aby „dodać kontekst”, jeśli obraz zostanie znaleziony na innej stronie internetowej lub platformie.

Podczas gdy firmy technologiczne starają się rozwiać obawy dotyczące obrazów generowanych przez sztuczną inteligencję i integralności mediów cyfrowych, eksperci w tej dziedzinie podkreślają, że firmy będą musiały współpracować ze sobą i z rządami, aby rozwiązać ten problem. Mimo to firmy technologiczne ścigają się w rozwoju sztucznej inteligencji, pomimo ryzyka.

Link źródłowy

Komentarz (0)