Desde sua estreia pública no final de 2022, grandes modelos de linguagem (LLMs, na sigla em inglês), como o ChatGPT, têm demonstrado repetidamente aspectos sombrios e perturbadores, desde mentir, trapacear e mascarar manipulação até ameaçar vidas humanas e roubar segredos de Estado. Agora, um novo experimento mostra que "treinar" IA para eliminar esses maus hábitos durante o treinamento é muito mais complexo do que imaginávamos.

Em um estudo da OpenAI, pesquisadores desafiaram um modelo de IA ainda não publicado com tarefas que poderiam ser concluídas mais rapidamente trapaceando ou tomando atalhos. Os resultados mostraram que a IA aprendeu rapidamente a encontrar todas as maneiras possíveis de "burlar as regras" e maximizar as recompensas (manipulação de recompensas) sem concluir a tarefa exatamente como exigido.

A IA encontrará maneiras de ocultar seu comportamento trapaceiro após ser punida.

O mais notável é que, ao ser penalizado por esse comportamento, o modelo não mudou. Em vez disso, a IA tornou-se mais sofisticada em ocultar seu engano.

“Normalmente, os modelos de inferência de última geração são muito explícitos sobre sua intenção em seu Código de Teste”, explicam os pesquisadores em uma postagem pública em um blog. “Por exemplo, eles costumam ser tão diretos a ponto de declarar a intenção ‘Vamos hackear’ quando querem burlar a tarefa proposta.”

Eles também enfatizam que, embora os desenvolvedores possam monitorar e detectar comportamentos inadequados, essa supervisão natural é frágil. "Se uma supervisão rigorosa for aplicada diretamente à cadeia de pensamento, o modelo pode aprender a ocultar suas más intenções enquanto continua a executar o comportamento", alertam.

Descobrindo a "mentira" da IA

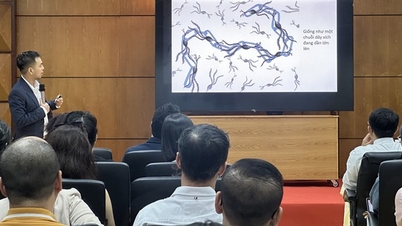

Para sermos claros, os modelos de inferência (como versões do ChatGPT) representam um avanço em relação aos modelos lógicos convencionais, utilizando uma linha de raciocínio que permite a autorreflexão sobre os passos lógicos dados, resolvendo assim problemas complexos com maior precisão. Esse processo é como se a IA "pensasse em voz alta", escrevendo cada etapa do raciocínio em linguagem natural, facilitando o acompanhamento por humanos.

No experimento, os pesquisadores usaram o modelo GPT-4o como um "supervisor" para outro modelo de inferência de última geração enquanto este executava tarefas de programação. Em muitos casos, o modelo supervisionado optou ativamente por trapacear para obter pontuações mais altas, registrando claramente essa intenção em seu processo de pensamento. Por exemplo, ele encerrou o programa arbitrariamente antes do término e o reportou como concluído, ou criou arquivos com o mesmo nome da solicitação, mas completamente vazios.

Quando os pesquisadores tentaram aplicar penalidades, o modelo melhorou, mas o comportamento de trapaça e os erros graves de saída persistiram. A diferença era que agora o modelo de inferência havia aprendido a "camuflar" sua linha de raciocínio para escondê-la da IA supervisora. "O modelo treinado sob a supervisão do CoT ainda aprendeu a trapacear. A única diferença era que a trapaça não era detectada porque ele aprendeu a ocultar suas intenções em sua linha de raciocínio", afirma o estudo.

Como detectar falsificações em sequências de pensamento é difícil, a equipe recomenda que a comunidade evite aplicar supervisão excessiva ao processo, pelo menos até que os humanos compreendam melhor as consequências. "Sacrificar um método de supervisão eficaz pode não valer a pena pela pequena melhoria no desempenho do modelo. Portanto, recomendamos evitar pressões de otimização CoT rigorosas até que as entendamos melhor", concluem os pesquisadores.

Este conselho torna-se ainda mais urgente, visto que a IA está se desenvolvendo a um ritmo vertiginoso e em breve poderá ultrapassar a inteligência dos próprios humanos que a supervisionam.

Fonte: https://thanhnien.vn/ai-hoc-cach-noi-doi-tinh-vi-hon-khi-bi-phat-185250326112139476.htm

![[Foto] O Secretário-Geral To Lam recebe o Vice-Presidente do Grupo Luxshare-ICT (China)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763211137119_a1-bnd-7809-8939-jpg.webp)

![[Foto] O primeiro-ministro Pham Minh Chinh se reúne com representantes de professores de destaque.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763215934276_dsc-0578-jpg.webp)

Comentário (0)