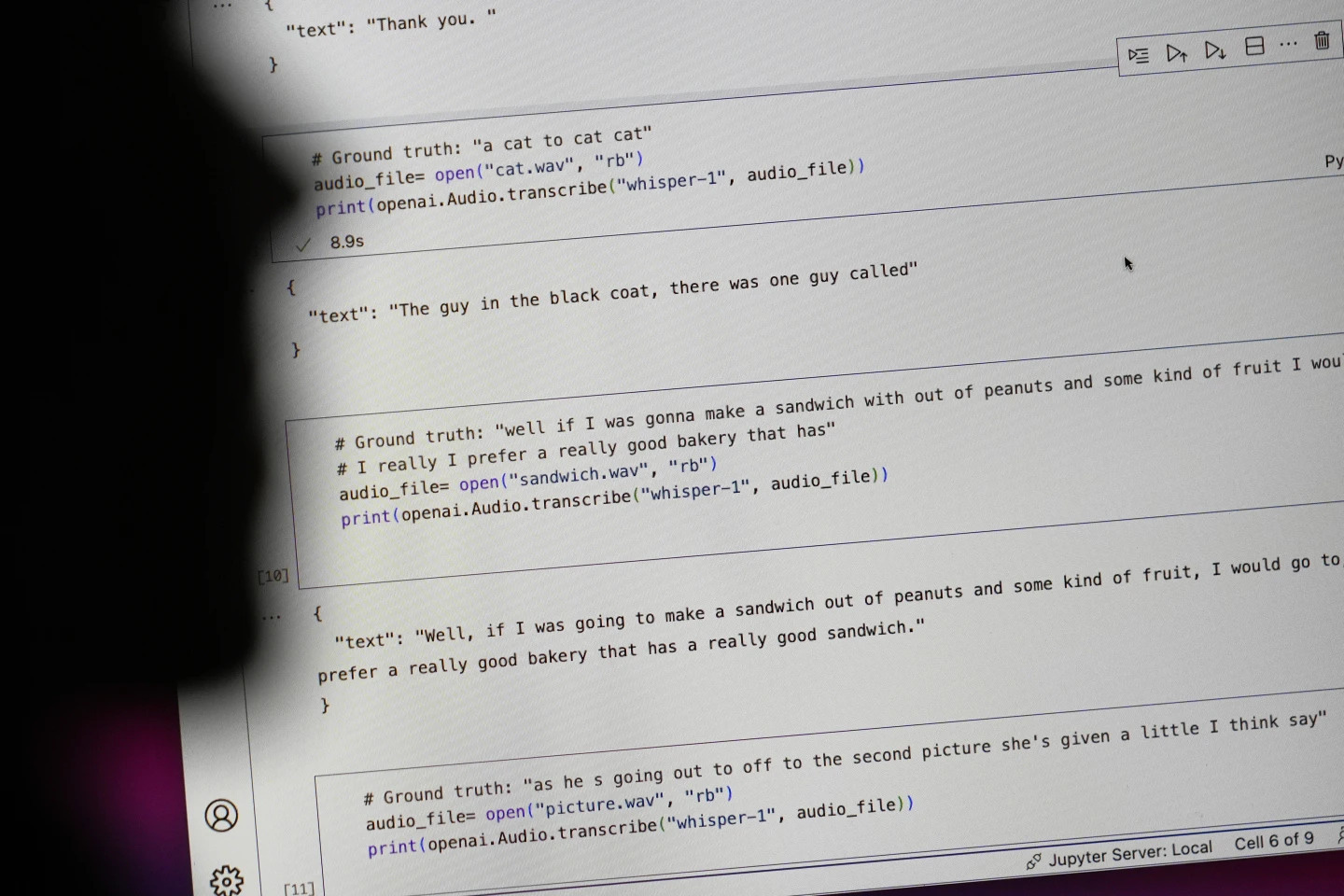

A gigante da tecnologia OpenAI promoveu sua ferramenta de conversão de voz em texto, Whisper, como uma IA com "precisão e robustez semelhantes às humanas". Mas o Whisper tinha uma falha grave: gerava textos e frases completamente falsos.

Alguns dos textos gerados pela IA – chamados de “alucinações” – podem incluir comentários raciais, linguagem violenta e até mesmo tratamentos médicos imaginários – Foto: AP

Alguns dos textos gerados pela IA são chamados de "alucinatórios", dizem os especialistas, de acordo com a AP, incluindo comentários raciais, linguagem violenta e até mesmo tratamentos médicos imaginários.

Alta taxa de “ilusão” em textos gerados por IA

Os especialistas estão particularmente preocupados porque o Whisper é amplamente utilizado em muitos setores ao redor do mundo para traduzir e transcrever entrevistas, gerar texto em tecnologias de consumo populares e criar legendas para vídeos.

O mais preocupante é que muitos centros médicos estão usando o Whisper para transferir consultas entre médicos e pacientes, embora a OpenAI tenha alertado que a ferramenta não deve ser usada em áreas de “alto risco”.

A extensão total do problema é difícil de determinar, mas pesquisadores e engenheiros dizem que regularmente encontram "alucinações" do Sussurro em seus trabalhos.

Um pesquisador da Universidade de Michigan afirmou ter encontrado "alucinações" em oito de cada dez transcrições de áudio que examinou. Um engenheiro de computação encontrou "alucinações" em cerca de metade das transcrições de mais de 100 horas de áudio que analisou. Outro desenvolvedor afirmou ter encontrado "alucinações" em quase todas as 26.000 gravações que criou usando o Whisper.

O problema persiste mesmo com amostras de áudio curtas e claramente gravadas. Um estudo recente realizado por cientistas da computação encontrou 187 "ilusões" em mais de 13.000 clipes de áudio nítidos que eles examinaram. Essa tendência levaria a dezenas de milhares de transcrições falsas em milhões de gravações, disseram os pesquisadores.

Tais erros podem ter “consequências muito sérias”, especialmente em ambientes hospitalares, de acordo com Alondra Nelson, que chefiou o Escritório de Ciência e Tecnologia da Casa Branca no governo Biden até o ano passado.

“Ninguém quer um diagnóstico errado”, disse Nelson, agora professor do Instituto de Estudos Avançados em Princeton, Nova Jersey. “É preciso haver um padrão mais elevado.”

O Whisper também é usado para criar legendas para surdos e deficientes auditivos — uma população particularmente vulnerável a erros de tradução. Isso ocorre porque pessoas surdas e deficientes auditivas não têm como identificar trechos inventados "escondidos em todo o restante do texto", diz Christian Vogler, surdo e diretor do Programa de Acessibilidade Tecnológica da Universidade Gallaudet.

A OpenAI é chamada para resolver o problema

A prevalência dessas "alucinações" levou especialistas, defensores e ex-funcionários da OpenAI a apelar ao governo federal para que considere a regulamentação da IA. No mínimo, a OpenAI precisa corrigir essa falha.

“Esse problema pode ser resolvido se a empresa estiver disposta a priorizá-lo”, disse William Saunders, um engenheiro de pesquisa de São Francisco que deixou a OpenAI em fevereiro devido a preocupações com a direção da empresa.

"Seria um problema se você o divulgasse e as pessoas ficassem tão confiantes sobre o que ele pode fazer que o integrassem a todos esses outros sistemas." Um porta-voz da OpenAI disse que a empresa está constantemente trabalhando em maneiras de mitigar as "ilusões" e aprecia as descobertas dos pesquisadores, acrescentando que a OpenAI incorpora feedback nas atualizações do modelo.

Enquanto a maioria dos desenvolvedores assume que ferramentas de conversão de texto em fala podem cometer erros de digitação ou outros erros, engenheiros e pesquisadores dizem que nunca viram uma ferramenta de conversão de texto em fala com tecnologia de IA que "alucinasse" tanto quanto o Whisper.

Prêmio Nobel de Física 2024: As pessoas que lançaram as bases da IA

Prêmio Nobel de Física 2024: As pessoas que lançaram as bases da IA[anúncio_2]

Fonte: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

Comentário (0)