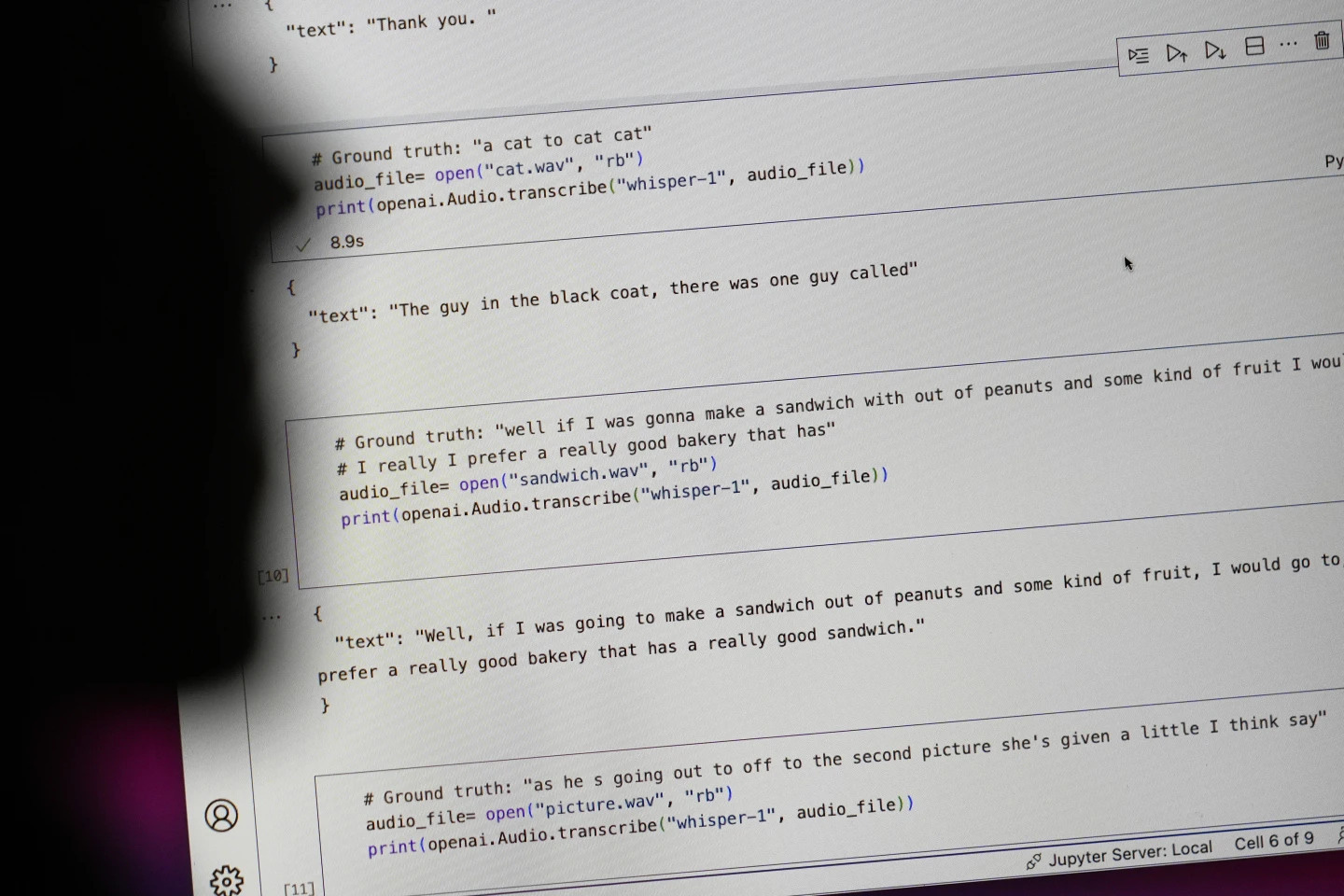

Технологический гигант OpenAI рекламировал свой инструмент преобразования речи в текст Whisper как искусственный интеллект с «человеческой точностью и надёжностью». Но у Whisper был один серьёзный недостаток: он генерировал текст и предложения, которые были совершенно нереалистичными.

Некоторые тексты, генерируемые ИИ, называемые «галлюцинациями», могут включать расистские комментарии, грубую лексику и даже вымышленные медицинские процедуры. Фото: AP

По данным Associated Press, эксперты утверждают, что часть текста, сгенерированного ИИ, является так называемым «галлюцинаторным» и содержит расистские комментарии, грубую лексику и даже вымышленные методы лечения.

Высокий уровень «иллюзий» в текстах, сгенерированных ИИ

Эксперты особенно обеспокоены, поскольку Whisper широко используется во многих отраслях по всему миру для перевода и расшифровки интервью, генерации текста в популярных потребительских технологиях и создания субтитров для видеороликов.

Еще большую тревогу вызывает тот факт, что многие медицинские центры используют Whisper для передачи консультаций между врачами и пациентами, хотя OpenAI предупреждает, что этот инструмент не следует использовать в зонах «высокого риска».

Точный масштаб проблемы определить сложно, но исследователи и инженеры утверждают, что в своей работе они регулярно сталкиваются с «галлюцинациями» Whisper.

Исследователь из Мичиганского университета сообщил, что обнаружил «галлюцинации» в восьми из десяти изученных им аудиозаписей. Инженер-компьютерщик обнаружил «галлюцинации» примерно в половине транскрипций более 100 часов проанализированных им аудиозаписей. Другой разработчик сообщил, что обнаружил «галлюцинации» почти во всех из 26 000 записей, созданных им с помощью Whisper.

Проблема сохраняется даже с короткими, чётко записанными аудиофрагментами. Недавнее исследование, проведённое учёными в области компьютерных технологий, выявило 187 «иллюзий» в более чем 13 000 изученных ими чётких аудиофрагментах. Эта тенденция приводит к десяткам тысяч ложных транскрипций в миллионах записей, утверждают исследователи.

По словам Алондры Нельсон, которая до прошлого года возглавляла Управление по науке и технологиям Белого дома в администрации Байдена, такие ошибки могут иметь «очень серьезные последствия», особенно в условиях стационара.

«Никто не хочет получить неправильный диагноз», — сказал Нельсон, ныне профессор Института перспективных исследований в Принстоне, штат Нью-Джерси. «Необходим более высокий стандарт».

Whisper также используется для создания субтитров для глухих и слабослышащих — группы населения, которая особенно подвержена риску неправильного перевода. Это связано с тем, что глухие и слабослышащие не могут распознать поддельные тексты, «скрытые во всем остальном тексте», — говорит Кристиан Фоглер, глухой и директор Программы доступности технологий в Университете Галлодет.

OpenAI призван решить проблему

Распространенность подобных «галлюцинаций» побудила экспертов, активистов и бывших сотрудников OpenAI призвать федеральное правительство рассмотреть вопрос о регулировании ИИ. Как минимум, OpenAI необходимо устранить этот недостаток.

«Эта проблема разрешима, если компания готова уделить ей первостепенное внимание», — сказал Уильям Сондерс, инженер-исследователь из Сан-Франциско, покинувший OpenAI в феврале из-за сомнений относительно направления развития компании.

«Проблема возникнет, если вы выпустите его, и люди настолько уверятся в его возможностях, что начнут интегрировать его во все эти другие системы». Представитель OpenAI заявил, что компания постоянно работает над способами развеять эти «иллюзии» и высоко ценит выводы исследователей, добавив, что OpenAI учитывает отзывы при обновлении моделей.

Хотя большинство разработчиков предполагают, что инструменты преобразования текста в речь могут допускать опечатки или другие ошибки, инженеры и исследователи утверждают, что никогда не видели инструмента преобразования текста в речь на базе искусственного интеллекта, который бы «галлюцинировал» так часто, как Whisper.

Нобелевская премия по физике 2024 года: люди, заложившие основы ИИ

Нобелевская премия по физике 2024 года: люди, заложившие основы ИИИсточник: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Фото] Торжественное открытие 10-й сессии 15-го Национального собрания](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760937111622_ndo_br_1-202-jpg.webp)

![[Фото] Премьер-министр Фам Минь Чинь встречается со спикером Национальной ассамблеи Венгрии Ковером Ласло](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760970413415_dsc-8111-jpg.webp)

![[Фото] Председатель Национального собрания Чан Тхань Ман проводит переговоры с председателем Национального собрания Венгрии Ковером Ласло](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760952711347_ndo_br_bnd-1603-jpg.webp)

![[Фото] Председатель венгерского парламента посещает мавзолей президента Хо Ши Мина](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760941009023_ndo_br_hungary-jpg.webp)

![[Фото] Оргкомитет Осенней ярмарки 2025 года проверяет ход организации](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760918203241_nam-5371-jpg.webp)

Комментарий (0)