مصنوعی ذہانت (AI) کی تیز رفتار ترقی نے خدشات کو جنم دیا ہے کہ یہ اس تیزی سے ترقی کر رہی ہے جتنا کہ انسان اس کے اثرات کو سمجھ سکتا ہے۔

تصویر: ST

ChatGPT جیسے ٹولز کے ظہور کے بعد جنرل AI کے استعمال میں نمایاں اضافہ ہوا ہے۔ اگرچہ ان ٹولز کے بہت سے فائدے ہیں، لیکن ان کا غلط استعمال نقصان دہ طریقوں سے بھی کیا جا سکتا ہے۔

اس خطرے کو سنبھالنے کے لیے، امریکہ اور کئی دیگر ممالک نے سات کمپنیوں سے معاہدے حاصل کیے ہیں، جن میں Amazon، Anthropic، Google، Inflection، Meta، Microsoft، اور OpenAI شامل ہیں، AI ٹیکنالوجی کو تیار کرنے میں محفوظ طریقوں سے عہد کرنے کے لیے۔

وائٹ ہاؤس کا اعلان اس کی اپنی اصطلاحات کے ساتھ آتا ہے جو اوسط فرد کے لیے ناواقف ہو سکتا ہے، جیسے "ریڈ ٹیمنگ" اور "واٹر مارکنگ" جیسی اصطلاحات۔ یہاں AI سے متعلق سات شرائط ہیں جن پر دھیان رکھنا ہے۔

مشین لرننگ

AI کی اس شاخ کا مقصد مشینوں کو تربیت دینا ہے کہ وہ پیٹرن کی شناخت کرکے ایک مخصوص کام کو درست طریقے سے انجام دے سکیں۔ اس کے بعد مشین اس ڈیٹا کی بنیاد پر پیشین گوئیاں کر سکتی ہے۔

گہری تعلیم

تخلیقی AI کام اکثر گہری سیکھنے پر انحصار کرتے ہیں، ایک ایسا طریقہ جس میں کمپیوٹرز کو نیورل نیٹ ورکس کا استعمال کرتے ہوئے تربیت دی جاتی ہے، الگورتھم کا ایک سیٹ جو انسانی دماغ میں نیوران کی نقل کرنے کے لیے ڈیزائن کیا گیا ہے، متن، تصاویر یا دیگر مواد پیدا کرنے کے لیے پیٹرن کے درمیان پیچیدہ رابطہ قائم کرنا ہے۔

چونکہ ڈیپ لرننگ ماڈلز میں نیوران کی متعدد پرتیں ہوتی ہیں، اس لیے وہ روایتی مشین لرننگ سے زیادہ پیچیدہ پیٹرن سیکھ سکتے ہیں۔

زبان کا بڑا ماڈل

ایک بڑے لینگویج ماڈل، یا LLM، کو بڑی مقدار میں ڈیٹا پر تربیت دی جاتی ہے اور اس کا مقصد زبان کو ماڈل کرنا یا ایک ترتیب میں اگلے لفظ کی پیشین گوئی کرنا ہے۔ بڑے زبان کے ماڈل، جیسے ChatGPT اور Google Bard، کاموں کے لیے استعمال کیے جا سکتے ہیں جن میں خلاصہ، ترجمہ اور گفتگو شامل ہیں۔

الگورتھم

ہدایات یا قواعد کا ایک مجموعہ جو مشینوں کو پیشین گوئیاں کرنے، مسائل حل کرنے یا کاموں کو مکمل کرنے کی اجازت دیتا ہے۔ الگورتھم خریداری کی سفارشات فراہم کر سکتے ہیں اور فراڈ کا پتہ لگانے اور کسٹمر سروس چیٹ کے افعال میں مدد کر سکتے ہیں۔

تعصب

چونکہ AI کو بڑے ڈیٹا سیٹس کا استعمال کرتے ہوئے تربیت دی جاتی ہے، اس لیے یہ نقصان دہ معلومات کو ڈیٹا میں شامل کر سکتا ہے، جیسے نفرت انگیز تقریر۔ نسل پرستی اور جنس پرستی AI کو تربیت دینے کے لیے استعمال ہونے والے ڈیٹا سیٹس میں بھی ظاہر ہو سکتی ہے، جس سے گمراہ کن مواد ہوتا ہے۔

AI کمپنیوں نے AI سسٹمز میں نقصان دہ تعصب اور امتیازی سلوک سے بچنے کے طریقے کے بارے میں گہرائی میں جانے پر اتفاق کیا ہے۔

ریڈ ٹیمنگ

کمپنیوں نے وائٹ ہاؤس سے جو وعدے کیے ہیں ان میں سے ایک AI ماڈلز اور سسٹمز پر اندرونی اور بیرونی طور پر "ریڈ ٹیمنگ" کرنا ہے۔

"ریڈ ٹیمنگ" میں ممکنہ کمزوریوں سے پردہ اٹھانے کے لیے ماڈل کی جانچ کرنا شامل ہے۔ یہ اصطلاح ایک فوجی مشق سے آتی ہے جہاں ایک ٹیم حکمت عملی کے ساتھ آنے کے لیے حملہ آور کے اعمال کی نقالی کرتی ہے۔

یہ طریقہ بڑے پیمانے پر مائیکروسافٹ اور گوگل جیسی کمپنیوں کے کلاؤڈ کمپیوٹنگ پلیٹ فارم جیسے سسٹمز میں حفاظتی خطرات کو جانچنے کے لیے استعمال کیا جاتا ہے۔

واٹر مارکنگ

واٹر مارک یہ بتانے کا ایک طریقہ ہے کہ آیا کوئی آواز یا تصویر AI نے بنائی ہے۔ تصدیق کے لیے جانچے گئے حقائق میں یہ معلومات شامل ہو سکتی ہے کہ اسے کس نے بنایا، ساتھ ہی یہ کیسے اور کب بنایا گیا یا اس میں ترمیم کی گئی۔

مثال کے طور پر، مائیکروسافٹ نے اپنے AI ٹولز کے ذریعے تخلیق کردہ واٹر مارک امیجز کا وعدہ کیا ہے۔ کمپنیوں نے وائٹ ہاؤس سے یہ وعدہ کیا ہے کہ وہ تصاویر کو واٹر مارک کریں یا ان کی اصلیت کو ریکارڈ کریں تاکہ ان کی شناخت AI سے تیار کی جائے۔

واٹر مارکس کا استعمال عام طور پر دانشورانہ املاک کی خلاف ورزیوں کو ٹریک کرنے کے لیے بھی کیا جاتا ہے۔ AI سے تیار کردہ امیجز کے لیے واٹر مارکس ناقابل تصور شور کے طور پر ظاہر ہو سکتے ہیں، جیسے کہ ہر ساتویں پکسل میں ہلکی سی تبدیلی۔

تاہم، AI سے تیار کردہ متن کو واٹر مارک کرنا زیادہ پیچیدہ ہو سکتا ہے اور اس میں لفظ ٹیمپلیٹ کو تبدیل کرنا شامل ہو سکتا ہے تاکہ اس کی شناخت AI سے تیار کردہ مواد کے طور پر کی جا سکے۔

ہوانگ ٹن (پوئنٹر کے مطابق)

ماخذ

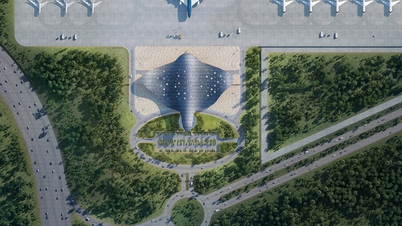

![[تصویر] قومی اسمبلی کے چیئرمین ٹران تھان مین ون فیوچر 2025 ایوارڈ کی تقریب میں شرکت کر رہے ہیں](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

تبصرہ (0)