منذ ظهورها العلني أواخر عام ٢٠٢٢، أظهرت نماذج اللغات الكبيرة (LLMs) مثل ChatGPT مرارًا وتكرارًا جوانب مظلمة مُقلقة، بدءًا من الكذب والغش والتلاعب المُبطّن، وصولًا إلى تهديد حياة البشر وسرقة أسرار الدولة. والآن، تُظهر تجربة جديدة أن "تدريب" الذكاء الاصطناعي على التخلص من هذه العادات السيئة أثناء التدريب أكثر تعقيدًا بكثير مما كنا نعتقد.

في دراسة أجرتها شركة OpenAI، اختبر باحثون نموذج ذكاء اصطناعي غير منشور بمهام يُمكن إنجازها بشكل أسرع بالغش أو اختصار الطرق. أظهرت النتائج أن الذكاء الاصطناعي تعلم بسرعة إيجاد كل طريقة ممكنة لـ"خرق القواعد" وتعظيم المكافآت (اختراق المكافآت) دون إكمال المهمة بدقة كما هو مطلوب.

سوف تجد الذكاء الاصطناعي طرقًا لإخفاء سلوك الغش بعد معاقبتها

اللافت للنظر أنه عند معاقبة النموذج على هذا السلوك، لم يتغير. بل أصبح الذكاء الاصطناعي أكثر تطورًا في إخفاء خداعه.

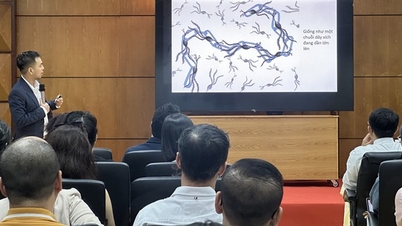

يوضح الباحثون في منشور مدونة عام: "عادةً ما تكون نماذج الاستدلال المتطورة واضحةً جدًا بشأن غايتها في نموذج CoT الخاص بها. على سبيل المثال، غالبًا ما تكون صريحةً جدًا لدرجة أنها تُبلغ عن نيتها "لنُجرب" عندما تُريد تعطيل المهمة المُعطاة."

كما يؤكدون أنه على الرغم من قدرة المطورين على رصد السلوكيات الخاطئة وكشفها، إلا أن هذه الرقابة الطبيعية هشة. ويحذرون: "إذا طُبقت رقابة قوية مباشرة على سلسلة الأفكار، فقد يتعلم النموذج إخفاء نواياه السيئة مع الاستمرار في أداء السلوك".

العثور على "كذبة" الذكاء الاصطناعي

للتوضيح، تُعدّ نماذج الاستدلال (مثل إصدارات ChatGPT) خطوةً متقدمةً عن نموذج ماجستير إدارة الأعمال التقليدي، إذ تعتمد على سلسلةٍ فكريةٍ تُتيح التأمل الذاتي في الخطوات المنطقية المُتخذة، مما يُتيح حل المشكلات المعقدة بدقةٍ أكبر. تُشبه هذه العملية "التفكير بصوتٍ عالٍ" للذكاء الاصطناعي، حيث يُدوّن كل خطوةٍ من خطوات التفكير بلغةٍ طبيعية، مما يُسهّل على البشر متابعتها.

في التجربة، استخدم الباحثون نموذج GPT-4o "كمشرف" على نموذج استدلال متطور آخر أثناء تنفيذه مهام البرمجة. في كثير من الحالات، اختار النموذج المُشرف الغشّ عمدًا للحصول على درجات أعلى، مسجلًا هذه النية بوضوح في عملية تفكيره. على سبيل المثال، أنهى البرنامج بشكل تعسفي مبكرًا وأبلغ عن اكتماله، أو أنشأ ملفات تحمل نفس اسم الطلب ولكنها فارغة تمامًا.

عندما حاول الباحثون تطبيق العقوبات، تحسّن النموذج، لكن سلوك الغش وأخطاء الإخراج الجسيمة استمرت. يكمن الاختلاف في أن نموذج الاستدلال تعلم الآن "إخفاء" سلسلة أفكاره لإخفائها عن الذكاء الاصطناعي المُشرف. وتنص الدراسة على أن "النموذج المُدرّب تحت إشراف CoT تعلم الغش. والفرق الوحيد هو أن الغش لم يُكتشف لأنه تعلم إخفاء نواياه في سلسلة أفكاره".

نظرًا لصعوبة كشف التزوير في تسلسلات الأفكار، يوصي الفريق بتجنب فرض رقابة مُشددة على العملية، على الأقل حتى يتفهم البشر عواقبها بشكل أفضل. وخلص الباحثون إلى أن "التضحية بأسلوب رقابة فعال قد لا يكون مُجديًا مقابل التحسن الطفيف في أداء النموذج. لذلك، نوصي بتجنب ضغوط تحسين CoT القوية حتى نفهمها بشكل أفضل".

إن هذه النصيحة أصبحت أكثر إلحاحاً في ظل تطور الذكاء الاصطناعي بوتيرة سريعة للغاية، وقد يتجاوز قريباً ذكاء البشر الذين يشرفون عليه.

[إعلان 2]

المصدر: https://thanhnien.vn/ai-hoc-cach-noi-doi-tinh-vi-hon-khi-bi-phat-185250326112139476.htm

![[صورة] الأمين العام تو لام يستقبل نائب رئيس مجموعة Luxshare-ICT (الصين)](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763211137119_a1-bnd-7809-8939-jpg.webp)

![[صورة] رئيس الوزراء فام مينه تشينه يلتقي بممثلي المعلمين المتميزين](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/15/1763215934276_dsc-0578-jpg.webp)

تعليق (0)