تجمع حلقة النقاش "الذكاء الاصطناعي من أجل الإنسانية: أخلاقيات الذكاء الاصطناعي والسلامة في العصر الجديد" في إطار أسبوع العلوم والتكنولوجيا VinFuture 2025 العلماء والسياسيين والمخترعين لمناقشة تطوير الذكاء الاصطناعي المسؤول، نحو القيم الإنسانية.

وعلى هامش المناقشة، تحدث البروفيسور توبي والش - جامعة نيو ساوث ويلز (أستراليا)، عضو الأكاديمية في الجمعية الأمريكية لآلات الحوسبة، حول الاستخدام الأخلاقي والمسؤول للذكاء الاصطناعي.

يجب أن يكون الاستخدام المسؤول للذكاء الاصطناعي إلزاميًا

- وفقًا للأستاذ، هل ينبغي أن يكون الاستخدام المسؤول للذكاء الاصطناعي طوعيًا أم إلزاميًا؟ وكيف ينبغي لنا أن نتعامل مع الذكاء الاصطناعي؟

البروفيسور توبي والش: أؤمن إيمانًا راسخًا بضرورة أن يكون الاستخدام المسؤول للذكاء الاصطناعي إلزاميًا. هناك حوافز غير منطقية حاليًا، مع المبالغ الطائلة التي تُجنى من الذكاء الاصطناعي، والسبيل الوحيد لضمان حسن السلوك هو وضع لوائح صارمة، بحيث تُوازن المصلحة العامة دائمًا مع المصالح التجارية.

- هل يمكنك تقديم أمثلة محددة من بلدان مختلفة لتطبيقات الذكاء الاصطناعي المسؤولة والأخلاقية؟

البروفيسور توبي والش: أحد الأمثلة الكلاسيكية على ذلك هو القرارات ذات المخاطر العالية، مثل إصدار الأحكام والعقوبات في الولايات المتحدة، حيث يتم استخدام نظام الذكاء الاصطناعي لتقديم توصيات بشأن مدة سجن الشخص واحتمالية عودته إلى الجريمة.

للأسف، تم تدريب هذا النظام على بيانات تاريخية، ويعكس، دون قصد، تحيزات عنصرية سابقة تؤدي إلى التمييز ضد السود. لا ينبغي أن نسمح لأنظمة كهذه بتحديد من يُسجن.

عندما يرتكب الذكاء الاصطناعي خطأً، من المسؤول؟ وخاصةً مع وكلاء الذكاء الاصطناعي، هل لدينا القدرة على إصلاح آليات عملهم؟

البروفيسور توبي والش: تكمن المشكلة الأساسية عند ارتكاب الذكاء الاصطناعي للأخطاء في عدم قدرتنا على محاسبته. فهو ليس إنسانًا، وهذا عيبٌ في كل نظام قانوني في العالم . البشر وحدهم مسؤولون عن قراراتهم وأفعالهم.

فجأة، أصبح لدينا "وكيل" جديد يسمى الذكاء الاصطناعي، والذي يمكنه - إذا سمحنا له - اتخاذ القرارات واتخاذ الإجراءات في عالمنا، الأمر الذي يشكل تحديًا: من سنحاسبه؟

والجواب هو تحميل الشركات التي تنشر وتشغل أنظمة الذكاء الاصطناعي المسؤولية عن العواقب التي تسببها هذه "الآلات".

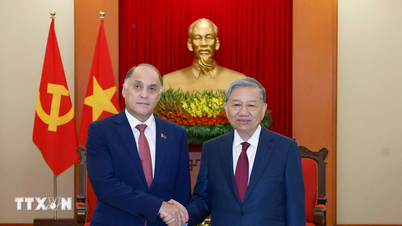

شارك البروفيسور توبي والش، من جامعة نيو ساوث ويلز، في ندوة "الذكاء الاصطناعي من أجل الإنسانية: أخلاقيات الذكاء الاصطناعي وسلامته في العصر الجديد"، ضمن فعاليات أسبوع العلوم والتكنولوجيا "فينفيوتشر 2025". (تصوير: مينه سون/فيتنام+)

تتحدث العديد من الشركات أيضًا عن الذكاء الاصطناعي المسؤول. كيف يمكننا الوثوق بها؟ كيف نتأكد من جديتها وشموليتها، وأنها لا تستخدم "الذكاء الاصطناعي المسؤول" كحيلة تسويقية؟

البروفيسور توبي والش: نحتاج إلى تعزيز الشفافية. من المهم فهم قدرات وحدود أنظمة الذكاء الاصطناعي. علينا أيضًا "التصويت بالممارسة" - أي اختيار استخدام الخدمات بمسؤولية.

أعتقد اعتقادًا راسخًا أن استخدام الشركات للذكاء الاصطناعي بمسؤولية سيُحدث فرقًا في السوق، ويمنحها ميزة تجارية. فإذا احترمت الشركة بيانات عملائها، ستستفيد وتجذب عملاء جدد.

ستدرك الشركات أن القيام بالتصرف الصحيح ليس أخلاقيًا فحسب، بل سيزيد من نجاحها أيضًا. أرى هذا وسيلةً للتمييز بين الشركات، فالشركات المسؤولة هي التي نشعر بالراحة في التعامل معها.

"إذا لم نكن حذرين، فقد نشهد فترة من الاستعمار الرقمي"

فيتنام من الدول القليلة التي تُفكّر في إصدار قانون الذكاء الاصطناعي. ما تقييمكم لهذا الأمر؟ برأيكم، ما هي التحديات الأخلاقية والأمنية في تطوير الذكاء الاصطناعي بالنسبة للدول النامية مثل فيتنام؟ ما هي توصيات الأستاذ لفيتنام لتحقيق أهدافها في استراتيجية الذكاء الاصطناعي، وأن تكون في صدارة المنطقة والعالم في أبحاث الذكاء الاصطناعي وإتقانه؟

البروفيسور توبي والش: يسعدني أن فيتنام من الدول الرائدة التي ستُصدر قانونًا مُخصصًا للذكاء الاصطناعي. هذا مهم لأن لكل دولة قيمها وثقافتها الخاصة، وتحتاج إلى قوانين لحماية هذه القيم.

تختلف القيم والثقافة الفيتنامية عن تلك الموجودة في أستراليا والصين والولايات المتحدة. لا يمكننا أن نتوقع من شركات التكنولوجيا الصينية أو الأمريكية حماية الثقافة واللغة الفيتناميتين تلقائيًا. يجب على فيتنام أن تبادر بحماية هذه القيم.

يُحذّر البروفيسور توبي والش من أننا إن لم نكن حذرين، فقد نشهد فترة استعمار رقمي. (صورة: مينه سون/فيتنام+)

أُدرك أن العديد من الدول النامية شهدت في الماضي فترة استعمار مادي. إذا لم نكن حذرين، فقد نمر بفترة "استعمار رقمي". ستُستغل بياناتك وستصبح موردًا رخيصًا.

وهذا الأمر معرض للخطر إذا قامت الدول النامية بتطوير صناعة الذكاء الاصطناعي بطريقة تستغل البيانات فقط دون السيطرة على مصالحها أو حمايتها.

- إذن كيف نتغلب على هذا الوضع يا أستاذ؟

البروفيسور توبي والش: الأمر بسيط: استثمروا في الموارد البشرية. طوّروا مهاراتهم، وتأكدوا من فهمهم للذكاء الاصطناعي. ادعموا رواد أعمال الذكاء الاصطناعي والشركات والجامعات. كونوا سباقين. بدلًا من انتظار دول أخرى لنقل التكنولوجيا أو توجيهنا، علينا أن نكون سباقين ونمتلك التكنولوجيا.

والأمر الأكثر أهمية هو أننا بحاجة إلى الدعوة بقوة إلى أن تعمل منصات التواصل الاجتماعي على خلق بيئة آمنة للمستخدمين في فيتنام، مع عدم التأثير على ديمقراطية البلاد.

في الواقع، هناك أمثلة عديدة لكيفية تأثير محتوى وسائل التواصل الاجتماعي على نتائج الانتخابات، وتقسيم الدول، وحتى التحريض على الإرهاب.

الذكاء الاصطناعي متطور للغاية في فيتنام. في الآونة الأخيرة، اعتمدت فيتنام العديد من السياسات لتعزيز الذكاء الاصطناعي، لكنها تواجه أيضًا مشكلة الاحتيال الناجم عن الذكاء الاصطناعي. فكيف ينبغي لفيتنام، وفقًا للأستاذ، التعامل مع هذا الوضع؟

البروفيسور توبي والش: بالنسبة للأفراد، أعتقد أن أبسط طريقة هي التحقق من المعلومات. على سبيل المثال، عندما نتلقى مكالمة هاتفية أو بريدًا إلكترونيًا، من بنك مثلاً، نحتاج إلى التحقق منه مرة أخرى: يمكننا معاودة الاتصال برقم الهاتف أو التواصل مع البنك مباشرةً للتحقق من المعلومات. في الوقت الحاضر، هناك العديد من رسائل البريد الإلكتروني وأرقام الهواتف المزيفة، وحتى مكالمات زووم يمكن تزييفها. هذه الاحتيالات بسيطة جدًا وغير مكلفة ولا تستغرق وقتًا طويلاً.

في عائلتي، لدينا أيضًا إجراء أمني خاص بنا: "سؤال سري" لا يعرفه إلا أفراد العائلة، مثل اسم أرنبنا الأليف. هذا يضمن بقاء المعلومات المهمة ضمن العائلة وعدم تسريبها.

- شكراً جزيلاً./.

البروفيسور توبي والش باحث فخري في مركز البحوث الأسترالي (ARC) وأستاذ في مجال الذكاء الاصطناعي بجامعة نيو ساوث ويلز سيدني (UNSW). وهو من أشدّ المؤيدين لوضع حدودٍ لضمان استخدام الذكاء الاصطناعي لتحسين حياة الناس.

وهو أيضًا زميل في الأكاديمية الأسترالية للعلوم وتم إدراجه في القائمة الدولية لـ "الأشخاص المؤثرين في مجال الذكاء الاصطناعي".

(فيتنام+)

المصدر: https://www.vietnamplus.vn/doanh-nghiep-su-dung-ai-co-trach-nhiem-se-mang-lai-loi-the-thuong-mai-post1080681.vnp

![[صورة] عبادة تمثال تويت سون - كنز عمره ما يقرب من 400 عام في معبد كيو](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764679323086_ndo_br_tempimageomw0hi-4884-jpg.webp&w=3840&q=75)

![[صورة] عرض عسكري احتفالا بالذكرى الخمسين لليوم الوطني لاوس](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

تعليق (0)