Wer schon einmal in sozialen Medien unterwegs war, ist wahrscheinlich auf KI-generierte Bilder oder Videos gestoßen. Viele wurden getäuscht, wie beispielsweise durch das virale Video von Kaninchen, die auf einem Trampolin springen. Doch Sora – eine Schwester-App von ChatGPT, entwickelt von OpenAI – hebt KI-Video auf ein neues Niveau und macht die Erkennung von gefälschten Inhalten immer dringlicher.

KI-gestützte Videotools erschweren es mehr denn je, authentische Videos zu erkennen. (Quelle: CNET)

Die 2024 gestartete und kürzlich mit Sora 2 aktualisierte App verfügt über eine TikTok-ähnliche Benutzeroberfläche, wobei alle Videos KI-generiert sind. Die „Cameo“-Funktion ermöglicht es, echte Personen in simuliertes Videomaterial einzufügen und so erschreckend realistische Videos zu erstellen.

Viele Experten befürchten daher, dass Sora die Verbreitung von Deepfakes begünstigen und so Informationen verfälschen und die Grenzen zwischen Realität und Fiktion verwischen wird. Prominente sind besonders gefährdet, weshalb Organisationen wie SAG-AFTRA OpenAI auffordern, den Schutz zu verstärken.

Die Identifizierung KI-generierter Inhalte stellt Technologieunternehmen, Social-Media-Plattformen und Nutzer gleichermaßen vor große Herausforderungen. Es gibt jedoch Möglichkeiten, mit Sora erstellte Videos zu erkennen.

Find Sora-Wasserzeichen

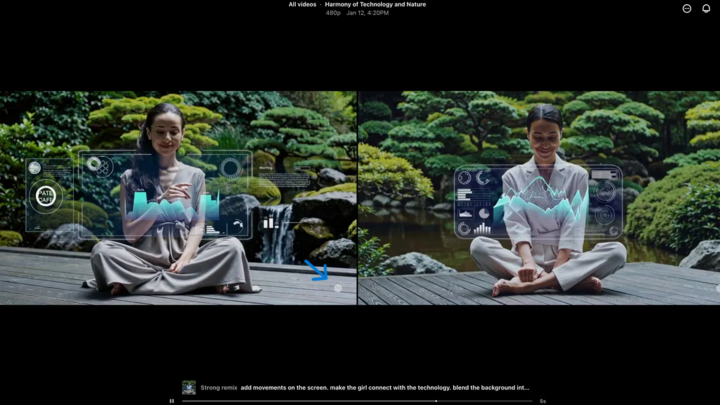

Das Sora-Wasserzeichen (gekennzeichnet durch den blauen Pfeil) ist ein Kennzeichen, das das zur Videoerstellung verwendete Tool identifiziert. (Quelle: CNET)

Jedes mit der Sora iOS-App erstellte Video hat beim Herunterladen ein Wasserzeichen – das weiße Sora-Logo (Wolken-Symbol) bewegt sich an den Rändern des Videos entlang, ähnlich wie beim TikTok-Wasserzeichen.

Dies ist eine visuelle Methode, um KI-generierte Inhalte zu erkennen. Googles Gemini-Modell, das an eine Nano-Banane erinnert, fügt beispielsweise automatisch ein Wasserzeichen zu Bildern hinzu. Wasserzeichen sind jedoch nicht immer zuverlässig. Statische Wasserzeichen lassen sich leicht entfernen. Selbst dynamische Wasserzeichen wie das von Sora können mithilfe spezieller Anwendungen entfernt werden.

Auf die Frage danach argumentierte OpenAI-CEO Sam Altman, dass sich die Gesellschaft an die Realität anpassen müsse, dass jeder gefälschte Videos erstellen kann. Vor Sora gab es kein Tool, das so populär und zugänglich war und für dessen Erstellung keine besonderen Kenntnisse erforderlich waren. Seine Sichtweise unterstreicht die Notwendigkeit, auf alternative Verifizierungsmethoden zurückzugreifen.

Metadaten prüfen

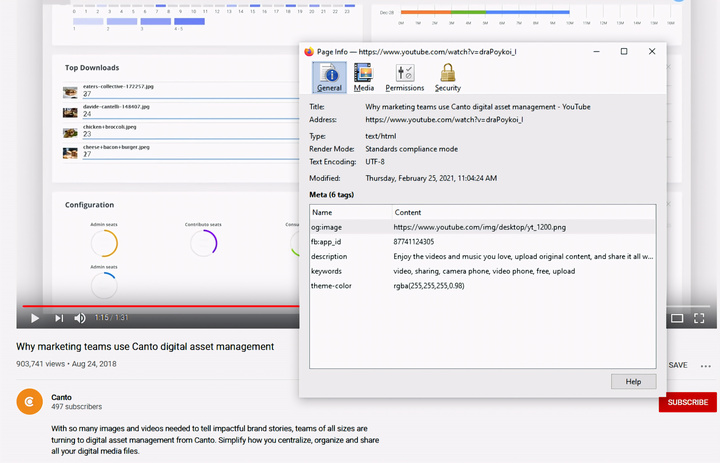

Überprüfung der Metadaten – ein entscheidender Schritt, um festzustellen, ob ein Video von einer KI wie Sora erstellt wurde. (Quelle: Canto)

Man könnte meinen, die Überprüfung von Metadaten sei zu kompliziert, aber in Wirklichkeit ist sie recht einfach und sehr effektiv.

Metadaten sind Informationen, die beim Erstellen von Inhalten automatisch hinzugefügt werden, wie z. B. Kameratyp, Aufnahmeort, Aufnahmezeitpunkt und Dateiname. Unabhängig davon, ob die Inhalte von Menschen oder KI erstellt wurden, enthalten sie Metadaten. Bei KI-generierten Inhalten enthalten die Metadaten häufig auch Angaben zur Quelle.

OpenAI ist Mitglied der Coalition for Content Origin and Authenticity (C2PA), daher enthalten Sora-Videos C2PA-Metadaten. Sie können dies mit dem Verifizierungstool der Content Authenticity Initiative überprüfen:

So prüfen Sie Metadaten:

- Besuchen Sie verify.contentauthenticity.org

- Laden Sie die zu prüfende Datei hoch.

- „Öffnen“ drücken

- Siehe die Informationen in der Tabelle auf der rechten Seite.

Wurde das Video von einer KI erstellt, wird dies in der Zusammenfassung deutlich angegeben. Bei Sora-Videos sehen Sie den Hinweis „Veröffentlicht von OpenAI“ sowie Informationen, die bestätigen, dass das Video mithilfe einer KI erstellt wurde. Alle Sora-Videos müssen diese Informationen enthalten, um ihre Herkunft zu verifizieren.

Quelle: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Foto] Premierminister Pham Minh Chinh empfängt den laotischen Minister für Bildung und Sport, Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Bild] Der unnachgiebige Kampfgeist des vietnamesischen Frauenfußballs](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F17%2F1765990260956_ndo_br_4224760955870434771-copy-jpg.webp&w=3840&q=75)

![[Foto] Premierminister Pham Minh Chinh empfängt den Gouverneur der Provinz Tochigi (Japan).](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Live] Gala der Community Action Awards 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Bild] Durchgesickerte Bilder vor der Community Action Awards Gala 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Live] Abschlusszeremonie und Preisverleihung des Video-/Clip-Wettbewerbs „Beeindruckender Vietnam-Tourismus“ 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Kommentar (0)