Produkte der KI: Rassismus und Voreingenommenheit

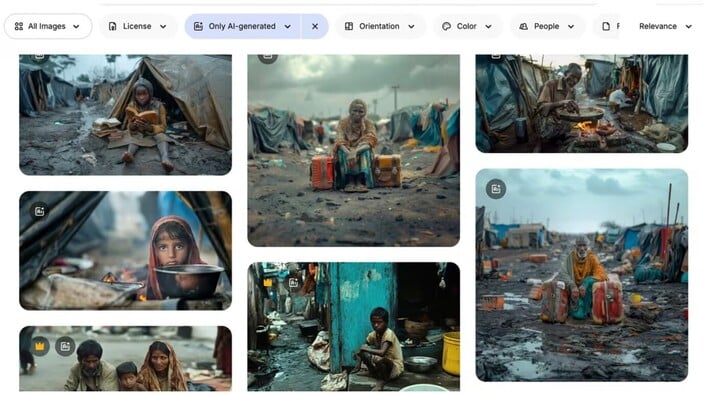

Laut globalen Gesundheitsexperten überschwemmen KI-generierte Bilder von Themen wie Armut, Kindern und Opfern sexueller Gewalt Online-Fotoarchive, die zunehmend von Nichtregierungsorganisationen (NGOs) genutzt werden. Experten warnen, dies könne den Beginn einer „neuen Ära der Armutsausbeutungskultur“ einläuten.

„Diese Bilder spiegeln die gängige Vorstellung von Armut wider – Kinder mit leeren Schüsseln, rissiger Boden… sehr stereotypisch“, sagte Arsenii Alenichev, ein Forscher am Institut für Tropenmedizin in Antwerpen, der sich mit der Produktion globaler Gesundheitsbilder beschäftigt .

Herr Alenichev sammelte mehr als 100 KI-generierte Bilder von extremer Armut, die von Einzelpersonen oder NGOs in Social-Media-Kampagnen gegen Hunger und sexuelle Gewalt verwendet wurden.

Die Bilder, die er dem Guardian zukommen ließ, zeigen übertriebene, stereotype Szenen: Kinder, die in Schlammpfützen kauern; ein afrikanisches Mädchen im Brautkleid, dem Tränen über die Wangen laufen. In einem kürzlich in der Fachzeitschrift „The Lancet Global Health“ veröffentlichten Kommentar argumentierte er, dass es sich bei den Bildern um eine Art „Armutsporno 2.0“ handle.

Screenshot einer KI-generierten Darstellung von „Armut“ auf einer Fotowebsite. (Foto: Freepik)

Herr Alenichev und viele andere Experten geben an, dass der Einsatz von KI-Bildern aufgrund von Bedenken hinsichtlich Urheberrecht und Kosten zunimmt. Die Kürzungen des US- amerikanischen Budgets für Nichtregierungsorganisationen haben das Problem verschärft.

„Offensichtlich fangen viele Organisationen an, KI-generierte Bilder anstelle von echten Fotos zu verwenden, weil es kostengünstig ist. Man muss sich auch keine Gedanken über Urheberrechte und viele andere Dinge machen“, sagte er.

Liegt die Verantwortung beim Nutzer oder bei der Plattform?

KI-generierte Bilder von Armut tauchen auf Dutzenden von Foto-Websites auf, darunter Adobe Stock Photos und Freepik. Viele tragen Bildunterschriften wie: „Surreales Kind in einem Flüchtlingslager“, „Asiatische Kinder schwimmen in einem mit Müll gefüllten Fluss“, „Weißer Freiwilliger gibt schwarzen Kindern in einem afrikanischen Dorf medizinische Ratschläge“ und so weiter. Adobe verkauft die Rechte an den beiden letztgenannten Bildern für rund 60 Pfund.

„Diese Fotos sind eindeutig rassistisch und sollten nicht veröffentlicht werden dürfen, weil sie die schlimmsten Stereotypen über Afrika, Indien oder irgendetwas anderes, was man sich vorstellen kann, darstellen“, sagte Alenichev.

Joaquín Abela, CEO von Freepik, erklärte, die Verantwortung für die Verwendung solch extremer Bilder liege bei den Nutzern, nicht bei Plattformen wie seiner. Seiner Ansicht nach werden KI-generierte Stockfotos von einer globalen Nutzergemeinschaft erstellt, die Lizenzgebühren erhält, wenn Freepik-Kunden ihre Fotos kaufen.

Freepik hat versucht, die in seinen Fotobibliotheken vorhandenen Verzerrungen durch „die Einbindung von Diversität“ einzudämmen. Gleichzeitig bemüht sich das Unternehmen auch um ein ausgewogenes Geschlechterverhältnis bei Fotos von Anwälten und Führungskräften.

Doch, so sagt er, seine Plattform könne nur begrenzt etwas bewirken. „Es ist, als würde man versuchen, den Ozean auszutrocknen. Wir haben es versucht, aber die Realität ist: Wenn Kunden auf der ganzen Welt wollen, dass ihre Bilder auf eine bestimmte Art und Weise aussehen, kann man absolut nichts dagegen tun.“

KI-generiertes Bild aus der Anti-Kinderheirat-Kampagne 2023 der Hilfsorganisation Plan International, die den Schutz der „Privatsphäre und Würde von Mädchen“ zum Ziel hat. (Foto: Plan International)

Viele angesehene Organisationen haben KI-generierte Bilder verwendet, sogar die Vereinten Nationen.

Letztes Jahr veröffentlichte die UNO ein Video auf YouTube, das „Nachstellungen“ sexueller Gewalt zeigte, darunter die Aussage einer burundischen Frau, die schilderte, wie sie 1993 von drei Männern vergewaltigt und zum Sterben zurückgelassen wurde. Der Inhalt wurde vollständig von KI generiert. Das Video wurde entfernt, nachdem der Guardian die UNO um ein Interview gebeten hatte.

Ein UN-Sprecher erklärte später, warum das Video entfernt wurde: „Wir gehen davon aus, dass das Video fehlerhaft von einer KI generiert wurde und möglicherweise die Integrität von Informationen gefährdet, da es reales Filmmaterial mit künstlichen Inhalten vermischt, die echt wirken.“

Es ist seit Langem bekannt, dass KI-generierte Produkte Nachahmungen sind, die die Wahrheit mitunter übertreiben. Laut Herrn Alenichev könnte die Verbreitung dieser verzerrten Bilder das Problem verschärfen, da sie sich im Internet verbreiten und zur Entwicklung der nächsten KI-Generation genutzt werden können.

Ein Sprecher von Plan International erklärte, die NGO rate derzeit davon ab, KI zur Darstellung von Kindern einzusetzen.

Minh Hoan

Quelle: https://vtcnews.vn/chuyen-gia-bao-dong-tinh-trang-ai-tao-anh-rap-khuon-phong-dai-ar972160.html

Kommentar (0)