Laut Reuters erklärte Nick Clegg, Leiter der globalen Geschäftsentwicklung bei Meta, dass das Unternehmen Markierungen in die Dateien integrieren wird. Inhalte, die auf den Plattformen Facebook, Instagram und Threads veröffentlicht werden, werden entsprechend gekennzeichnet. Dies soll Nutzern signalisieren, dass Bilder (die echten Fotos ähneln können) tatsächlich digitale, von künstlicher Intelligenz generierte Produkte sind. Auch Inhalte, die mit den eigenen KI-Tools erstellt wurden, sind bereits entsprechend gekennzeichnet.

Sobald das neue System eingerichtet und betriebsbereit ist, wird Meta dasselbe für Bilder tun, die über Dienste von OpenAI, Microsoft, Adobe, Midjourney, Shutterstock und Alphabet generiert wurden. Die Ankündigung liefert erste Informationen über ein neues Standardsystem, das Technologieunternehmen entwickeln, um die Schäden durch KI-generierte Technologien zu minimieren, die mit einfachen Quellen gefälschte Inhalte erstellen können.

Die Kennzeichnung von KI-generierten Bildern wird dazu beitragen, Fehlinformationen und Betrug einzudämmen.

Dieser Ansatz baut auf dem Muster auf, das Unternehmen im Laufe des letzten Jahrzehnts entwickelt haben, um die Entfernung verbotener Inhalte auf Plattformen zu koordinieren, wie etwa Darstellungen von Massengewalt und Kindesausbeutung.

Clegg ist der Ansicht, dass Unternehmen KI-generierte Bilder bereits jetzt zuverlässig kennzeichnen können, merkt aber an, dass sich anspruchsvollere Werkzeuge zur Annotation von Audio- und Videoinhalten noch in der Entwicklung befinden.

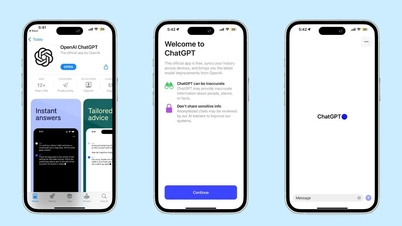

Meta wird zunächst von Nutzern verlangen, veränderte Audio- und Videoinhalte zu kennzeichnen und Verstöße dagegen mit Strafen belegen. Clegg erklärte jedoch, dass es derzeit keinen praktikablen Mechanismus zur Kennzeichnung von Texten gebe, die von KI-Tools wie ChatGPT generiert werden.

Metas unabhängiger Aufsichtsrat hat die Unternehmensrichtlinie zu irreführend bearbeiteten Videos kritisiert und argumentiert, dass Inhalte gekennzeichnet statt entfernt werden sollten. Clegg glaubt daher, dass Metas neuer Schritt dazu beitragen könnte, solche Inhalte besser zu kategorisieren.

Quellenlink

![[Foto] Premierminister Pham Minh Chinh empfängt den laotischen Minister für Bildung und Sport, Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Foto] Premierminister Pham Minh Chinh empfängt den Gouverneur der Provinz Tochigi (Japan).](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Live] Gala der Community Action Awards 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Bild] Durchgesickerte Bilder vor der Community Action Awards Gala 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

Kommentar (0)