La explosión de la inteligencia artificial (IA) aporta grandes beneficios a la humanidad pero también conlleva innumerables consecuencias: desde los prejuicios raciales y los sofisticados fraudes en línea hasta el riesgo de que los países en desarrollo se conviertan en "minas de datos" baratas.

Ante esta realidad, ¿debería el uso responsable de la IA ser voluntario u obligatorio? ¿Qué debería hacer Vietnam al construir un corredor legal en este campo?

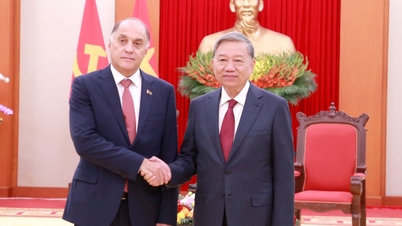

En el marco del evento Semana de Ciencia y Tecnología VinFuture, el reportero conversó con el profesor Toby Walsh - Universidad de Nueva Gales del Sur (Australia), académico de la American Computer Society.

El profesor ofrece ideas sobre cómo nos "comportamos" con la IA, desde responsabilizar a las "máquinas" hasta consejos para que las familias se protejan de la ola de estafas de alta tecnología.

¿Quién es responsable de la IA?

Profesor, ¿el uso responsable de la IA debería ser voluntario u obligatorio? ¿Y cómo deberíamos comportarnos realmente con ella?

Creo firmemente que el uso responsable de la IA debería ser obligatorio . Existen incentivos perversos , ya que se generan enormes cantidades de dinero con la IA, y la única manera de garantizar un comportamiento adecuado es imponer regulaciones estrictas , de modo que el interés público siempre se equilibre con los intereses comerciales .

Cuando la IA comete un error, ¿quién es responsable? Especialmente con los agentes de IA, ¿tenemos la capacidad de corregir sus mecanismos operativos?

El problema principal de los errores de la IA es que no podemos exigirle responsabilidades. La IA no es humana, y esto es una falla en todos los sistemas legales del mundo . Solo los humanos pueden rendir cuentas de sus decisiones y acciones.

De repente, tenemos un nuevo “agente”, la IA, que puede, si se lo permitimos, tomar decisiones y realizar acciones en nuestro mundo, lo que plantea un desafío: ¿a quién le pediremos cuentas?

La respuesta es: las empresas que implementan y operan sistemas de IA deben hacerse responsables de las consecuencias que causan estas “máquinas”.

Muchas empresas también hablan de IA responsable. ¿Cómo podemos confiar en ellas? ¿Cómo sabemos que son serias e integrales, y que no solo usan la "IA responsable" como estrategia de marketing?

Necesitamos aumentar la transparencia. Es importante comprender las capacidades y limitaciones de los sistemas de IA. También deberíamos "votar haciendo", es decir, optar por usar los servicios de forma responsable .

Creo sinceramente que la forma en que las empresas utilizan la IA de forma responsable se convertirá en un diferenciador en el mercado y les otorgará una ventaja comercial.

Si una empresa respeta los datos de sus clientes, se beneficiará y atraerá clientes. Las empresas comprenderán que hacer lo correcto no solo es ético, sino que también les ayudará a tener más éxito. Considero que esto es una forma de diferenciar entre empresas, y las empresas responsables son aquellas con las que podemos sentirnos cómodos al hacer negocios.

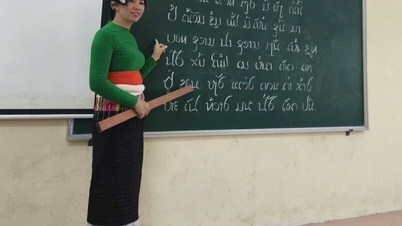

Vietnam necesita proteger proactivamente los valores culturales.

Vietnam es uno de los pocos países que están considerando promulgar la Ley de Inteligencia Artificial. ¿Cuál es su evaluación al respecto? En su opinión, para países en desarrollo como Vietnam, ¿cuáles son los desafíos en materia de ética y seguridad en el desarrollo de la IA?

Me alegra mucho que Vietnam sea uno de los países pioneros en contar con una Ley especializada en Inteligencia Artificial. Esto es importante porque cada país tiene sus propios valores y cultura, y necesita leyes que los protejan .

Los valores y la cultura vietnamitas difieren de los de Australia, China y Estados Unidos. No podemos esperar que las empresas tecnológicas de China o Estados Unidos protejan automáticamente la cultura y el idioma vietnamitas. Vietnam debe tomar la iniciativa para protegerlos.

Soy consciente de que, en el pasado, muchos países en desarrollo han pasado por un período de colonización física. Si no tenemos cuidado, podríamos atravesar un período de «colonización digital». Sus datos serán explotados y se convertirán en un recurso barato.

Esto corre riesgo si los países en desarrollo desarrollan la industria de la IA de una manera que sólo explota los datos sin controlar ni proteger sus propios intereses.

Entonces, ¿cómo superar esta situación?

Es simple: Invertir en las personas. Capacitarlas, asegurarse de que comprendan la IA. Apoyar a los emprendedores, a las empresas de IA y a las universidades. Ser proactivos. En lugar de esperar a que otros países nos transfieran tecnología o nos guíen, debemos ser proactivos y dominar la tecnología.

El profesor Toby Walsh comparte en la Semana de Ciencia y Tecnología de VinFuture (Foto: Comité Organizador).

En segundo lugar, debemos defender firmemente las plataformas de redes sociales para crear un entorno seguro para los usuarios en Vietnam, sin afectar la democracia del país.

De hecho, hay numerosos ejemplos de cómo el contenido de las redes sociales ha influido en los resultados electorales, dividido países e incluso incitado al terrorismo.

He dedicado 40 años a la inteligencia artificial. Durante los primeros 30, me preocupé por cómo hacer que la IA fuera más potente. En los últimos 10 años, he desarrollado cada vez más interés y me he pronunciado a favor de un desarrollo responsable de la IA.

¿Puede darnos algún consejo ahora que Vietnam está en proceso de redactar la Ley sobre Inteligencia Artificial?

Hay muchos casos en los que no se necesitan nuevas leyes. Ya tenemos leyes de privacidad y de competencia. Estas leyes vigentes se aplican tanto al espacio digital como al mundo físico.

Es importante aplicar estas leyes tan estrictamente en el entorno digital como lo hacemos en el entorno físico.

Sin embargo, están surgiendo nuevos riesgos y estamos empezando a observarlos. Las personas están empezando a relacionarse con la IA, utilizándola como terapeuta, y en ocasiones esta puede causar daño a los usuarios, por lo que debemos ser cautelosos.

Siempre responsabilizamos a los fabricantes cuando lanzan productos. Por ejemplo, si las empresas de IA lanzan productos de IA que dañan a los humanos, también deberían asumir la responsabilidad.

Entonces, ¿cómo podemos evitar que la IA cause efectos nocivos en los niños y crear un entorno seguro para ellos cuando aparezca la IA, señor?

Creo que no hemos aprendido muchas lecciones de las redes sociales. Muchos países están empezando a comprender que tienen grandes beneficios, pero también muchas desventajas, especialmente el impacto en la salud mental, los niveles de ansiedad y la imagen corporal de los jóvenes, especialmente las chicas.

Muchos países ya han comenzado a implementar medidas para abordar este problema. En Australia, el límite de edad para el uso de redes sociales entrará en vigor el 10 de diciembre. Creo que necesitamos medidas similares para la IA.

Estamos construyendo herramientas que pueden tener impactos positivos pero también pueden causar daño, y necesitamos proteger las mentes y los corazones de nuestros niños de estos impactos negativos.

Además, espero que los países también emitan regulaciones estrictas para gestionar las redes sociales, creando así un entorno verdaderamente seguro para todos al utilizar IA.

De hecho, no solo los niños, sino también los adultos se enfrentan a los riesgos que la propia IA conlleva. Entonces, ¿cómo pueden las personas usar la IA para mejorar sus vidas y no convertirse en un peligro?

La IA se aplica en muchos campos, ayudando a mejorar nuestra calidad de vida. En medicina, la IA ayuda a descubrir nuevos fármacos. En educación , también aporta numerosos beneficios.

Sin embargo, dar acceso a la IA sin las garantías adecuadas es demasiado arriesgado. En Estados Unidos, hemos visto demandas de padres contra empresas tecnológicas que llevaron a sus hijos al suicidio tras interactuar con chatbots de IA.

Aunque el porcentaje de usuarios de ChatGPT que experimentan problemas de salud mental es solo un pequeño porcentaje, con cientos de millones de usuarios, el número real está en cientos de miles.

Los datos son muy importantes para el desarrollo de la IA, pero desde una perspectiva de gestión, una gestión de datos demasiado estricta obstaculizará su desarrollo. En su opinión, ¿qué peligros puede acarrear una gestión de datos menos rigurosa? ¿Cómo se puede equilibrar la recopilación y la gestión segura de datos con el desarrollo de la IA?

Estoy totalmente de acuerdo. Los datos son la base del progreso de la IA , porque son los que la impulsan. Sin datos, no progresaremos. Los datos de alta calidad son la base de todo lo que hacemos. De hecho, el valor comercial y la ventaja competitiva que obtienen las empresas provienen de los datos. Tengamos o no datos de calidad, esa es la clave.

Es indignante ver cómo los libros de autores de todo el mundo, incluido el mío, se utilizan sin permiso ni compensación. Es un acto de robo del fruto del trabajo ajeno. Si esta situación continúa, los autores perderán la motivación para escribir libros y nosotros perderemos los valores culturales que tanto apreciamos.

Necesitamos encontrar una solución más equitativa que la que tenemos ahora.

Actualmente, "Silicon Valley" les roba contenido y creatividad a los autores sin pagarles; esto es insostenible. Comparo la situación actual con Napster y los inicios de la música en línea en la década del 2000. En aquel entonces, toda la música en línea era "robada", pero eso no podía durar para siempre, porque los músicos necesitaban ingresos para seguir creando.

Finalmente, existen sistemas de streaming de pago , como Spotify o Apple Music, o música con publicidad, donde una parte de los ingresos se destina al artista. Necesitamos hacer lo mismo con los libros, para que los autores obtengan valor de sus datos. De lo contrario, nadie se motivará a escribir libros, y el mundo estará mucho peor sin que se escriban nuevos libros.

En el marco de la Semana de la Ciencia y la Tecnología VinFuture, también se llevará a cabo la exposición “Toa V – Touchpoint of Science” en el Centro de Arte Contemporáneo Vincom Royal City (Foto: Comité Organizador).

La IA está muy desarrollada en Vietnam. Recientemente, Vietnam ha implementado numerosas políticas para promover la IA, pero también enfrenta un problema: el fraude causado por ella. Entonces, según el profesor, ¿cómo debería Vietnam gestionar esta situación? ¿Cuál es el consejo del profesor para quienes utilizan la IA actualmente para garantizar la seguridad y proteger sus datos?

Para cada persona, creo que la forma más sencilla es verificar la información. Por ejemplo, al recibir una llamada o un correo electrónico, por ejemplo, de un banco, necesitamos volver a verificar: podemos devolver la llamada al número del suscriptor o contactar directamente con el banco para verificar la información .

Hoy en día, hay muchísimos correos electrónicos falsos, números de teléfono falsos e incluso llamadas de Zoom falsas. Estas estafas son sencillas, económicas y no requieren mucho tiempo.

En mi familia, también tenemos nuestra propia medida de seguridad: una "pregunta secreta" que solo conocen los miembros de la familia, como el nombre de nuestro conejo. Esto garantiza que la información importante permanezca en la familia y no se filtre.

Vietnam también ha incluido la educación en IA en la educación general, entonces, ¿qué se debe tener en cuenta en ese proceso?

La IA transforma lo que se enseña y cómo se enseña. Afecta habilidades importantes del futuro, como el pensamiento crítico, las habilidades de comunicación, la inteligencia social y la inteligencia emocional. Estas habilidades serán esenciales.

La IA puede ayudar a enseñar estas habilidades, por ejemplo, como tutor personal, asistente de estudio personal, proporcionando herramientas educativas muy efectivas a través de aplicaciones de IA.

¡Gracias Profesor por tomarse el tiempo para nuestra charla!

Fuente: https://dantri.com.vn/cong-nghe/viet-nam-can-lam-gi-de-tranh-nguy-co-tro-thanh-nguon-luc-re-tien-20251203093314154.htm

![[Foto] Desfile para celebrar el 50 aniversario del Día Nacional de Laos](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764691918289_ndo_br_0-jpg.webp&w=3840&q=75)

![[Foto] Adoración a la estatua de Tuyet Son, un tesoro de casi 400 años de antigüedad en la Pagoda Keo](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F02%2F1764679323086_ndo_br_tempimageomw0hi-4884-jpg.webp&w=3840&q=75)

Kommentar (0)