|

De nombreux candidats ont fait remarquer que l'épreuve de mathématiques était longue et difficile à terminer en 90 minutes. Cependant, cela ne constitue pas un obstacle pour l'IA. Photo : Duy Hieu . |

L'après-midi du 26 juin, les candidats ont passé l'épreuve de mathématiques du baccalauréat 2025, d'une durée de 90 minutes. Il s'agissait de la première épreuve depuis l'introduction par le ministère de l'Éducation et de la Formation d'un nouveau format, réputé plus difficile que les années précédentes.

Bien que les problèmes de mathématiques de cette année puissent s'avérer difficiles pour les candidats en raison de leur longueur et du temps qu'ils demandent, les chatbots d'IA sont rapides à traiter. Afin de tester l'efficacité de l'IA, Tri Thuc - Znews a utilisé quatre chatbots (ChatGPT, Google Gemini, Claude AI et Grok AI) pour résoudre des questions de dissertation de l'examen de fin d'études secondaires de cette année.

Traitement rapide, résultats aléatoires

Des chatbots ont été utilisés pour répondre aux questions courtes du code de test 0109. ChatGPT et Gemini ont fourni les réponses les plus correctes et les plus rapides. Les deux chatbots ont répondu à six questions, avec un temps de réponse de 7 à 15 secondes par question. Gemini, grâce à son modèle Flash 2.5 (sans raisonnement), a pu résoudre les problèmes avec une grande efficacité.

Pendant ce temps, Claude a complètement raté ses calculs, donnant systématiquement des résultats incorrects. Malgré les demandes de recalcul, le chatbot d'Anthropic a maintenu sa réponse. Grok a répondu correctement à environ la moitié des questions, mais avec un temps de réponse très long (plus de deux minutes par question).

Pour ChatGPT et Grok, la résolution de ces questions nécessite la version par inférence, beaucoup plus longue. Gemini est très rapide, environ 5 secondes pour la question la plus rapide, et utilise uniquement le modèle Flash 2.5.

|

ChatGPT présente le processus de réflexion de manière très vivante. |

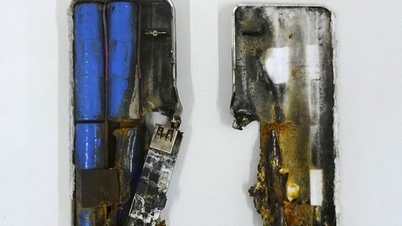

En termes de rapidité, Gemini affichait le temps de traitement le plus rapide, avec une moyenne inférieure à 10 secondes par problème, mais ses solutions étaient plus complexes, verbeuses et difficiles à comprendre. Viaient ensuite les modèles d'inférence de ChatGPT, avec une moyenne de 25 secondes. Quant à Grok, bien qu'il fournisse des résultats corrects, son temps de raisonnement était long : 148 secondes pour une question de difficulté moyenne.

Bien que la question ait été posée en vietnamien, les trois modèles ont présenté leur raisonnement en anglais. ChatGPT a fourni la description la plus concise, accompagnée de nombreuses illustrations, de graphiques et d'une analyse facile à comprendre. Gemini a également clarifié et présenté le raisonnement du modèle de manière structurée.

Grok, en particulier, possède un processus de pensée très proche de celui de l'humain. Le modèle se pose constamment des questions comme « cependant, attendez, au contraire », à l'instar d'un étudiant confronté à un problème de mathématiques. Cela peut amener le chatbot à trop réfléchir et à ralentir son temps de réponse.

|

Grok a mis 148 secondes à détailler ses résultats. |

L'IA résout les problèmes mathématiques différemment des humains.

Une étude d'Apple a révélé que les modèles d'inférence n'utilisent pas réellement leur cerveau, mais se contentent d'apprendre par cœur à partir de données existantes. L'étude suggère également que l'IA possède un processus de pensée totalement différent de celui des humains, et qu'elle tente donc d'imiter notre façon de résoudre un problème. Toutefois, il est possible que ce processus de raisonnement soit purement artificiel.

Face à des examens de fin d'études secondaires de plus en plus difficiles et exigeant une forte capacité d'analyse, le recours à l'IA comme outil de référence et d'apprentissage est devenu courant pour les élèves. Parmi les chatbots mentionnés, ChatGPT et Gemini constituent deux options pertinentes pour l'auto-apprentissage, permettant aux élèves de trouver des solutions à des problèmes complexes.

|

Élèves de Hanoï passant l'examen de fin d'études secondaires en 2025. Photo : Viet Ha . |

Cependant, bien que l'IA produise des résultats rapidement et facilement, son processus de raisonnement reste encore mal compris des développeurs. Dans le milieu universitaire, la capacité de réflexion humaine demeure essentielle. M. Tuan Nguyen, maître de conférences dans une université internationale d'Hô-Chi-Minh-Ville, a déclaré que l'utilisation de l'IA est courante, mais que les étudiants doivent comprendre les leçons, développer leur esprit critique et maîtriser les outils numériques pour étudier plus efficacement.

M. Tran Manh Tung, chef du département de mathématiques du lycée Newton, a indiqué que le format de l'examen était similaire à celui de l'examen blanc précédemment publié par le ministère de l'Éducation et de la Formation. « Toutefois, en termes de difficulté, l'examen réel était plus exigeant et plus nuancé que l'examen blanc », a-t-il précisé.

L’examen de cette année se compose de trois parties, chacune correspondant à un chiffre romain. Les deux premières sont des questions à choix multiples, relativement faciles à réussir, a indiqué M. Tung. Les deux dernières sont des questions courtes, similaires aux dissertations d’il y a quelques années, à la différence que les candidats doivent uniquement saisir leurs réponses, sans avoir à les présenter.

Source : https://znews.vn/ai-chi-mat-10-giay-de-giai-bai-toan-thi-tot-nghiep-thpt-post1563990.html

![[Photo] Le président de l'Assemblée nationale, Tran Thanh Man, assiste à la cérémonie de remise des prix VinFuture 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764951162416_2628509768338816493-6995-jpg.webp&w=3840&q=75)

![[Photo] 60e anniversaire de la fondation de l'Association vietnamienne des artistes photographes](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F05%2F1764935864512_a1-bnd-0841-9740-jpg.webp&w=3840&q=75)

Comment (0)